Deux ans après avoir plongé un data center composé de 800 serveurs au large de l'Écosse, Microsoft l'a remonté à la surface pour observer les effets de l'eau sur ses serveurs. Premier constat : au-delà d'être plus écologique, c'est aussi plus fiable sur le plan technique.

au sommaire

Pour aller plus loin que le simple refroidissement des data centers avec l'eau de mer, MicrosoftMicrosoft a lancé le projet Natick en 2018. L'idée est de placer les serveurs au fond de l'eau. Ainsi, il y a deux ans, au large de l'Écosse, la firme a ainsi placé à 35 mètres de profondeur plus de 800 serveurs pour un total de 27,6 pétaoctets de stockage. L'objectif : prouver que c'est à la fois écoénergétique mais aussi plus fiable que sur la terre ferme.

En effet, sur terre, les data centers souffrent de la corrosioncorrosion due à l'oxygène ambiant, l'humidité et aux variations de température, et Microsoft souhaitait observer si les serveurs sont mieux protégés dans un caisson étanche, sous l'eau, avec des conditions climatiques qui varient très peu. Deux ans plus tard, Microsoft a remonté à la surface son caisson et les premières conclusions sont très encourageantes.

La coque du caisson est restée en très bon état, et c'est ce qui a aussi impressionné les ingénieurs. © Microsoft

Plus de la moitié de la population pourrait en profiter

Ainsi, le data-center sous-marin ne présentait que 12 % du taux habituel de défaillance d'un centre de donnéescentre de données terrestre et c'est considérable. En clair, pour huit serveurs défaillants, et donc changés sur terre, on n'en change qu'un lorsqu'il est sous l'eau. Cette fiabilité est essentielle pour gérer la maintenance puisque ça signifie que les techniciens devront moins intervenir sur les serveurs, et c'est d'autant plus important qu'il est compliqué d'opérer sous l'eau.

Puisque la fiabilité semble réelle, Microsoft envisage de placer des serveurs près des villes côtières pour diminuer le temps d'accès aux données et applicationsapplications stockées dans le Cloud. La firme rappelle ainsi que plus de la moitié de la population mondiale vit à moins de 200 km d'une côte, et en plaçant les centres de données sous l'eau, près des villes, la navigation sur Internet sera plus rapide et l'accès aux jeux en ligne et aux vidéos sera plus fluide. Comme l'eau...

Projet Natick de Microsoft : un datacenter sous-marin au large de l'Écosse

Deux ans après avoir officialisé son projet de datacenter sous-marinsous-marin, Microsoft annonce un essai d'un an au large des îles Orcades, près de l'Écosse. Le prototype a été assemblé en France par Naval Group.

Publié le 08/06/2018 par Marc ZaffagniMarc Zaffagni

Microsoft vient d'engager une nouvelle phase de son projet Natick de centre de données (datacenter) sous-marin en annonçant qu'il avait débuté l''essai d'une nouvelle installation immergée par 35 mètres de fond au large des îles Orcades, au nord de l'Écosse. Il sera testé pendant un an, notamment pour évaluer sa consommation d'énergieénergie, le taux d'humidité et la température intérieure, ainsi que ses émissionsémissions acoustiques.

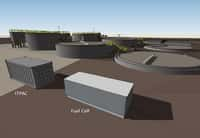

Le datacenter se présente sous la forme d'un conteneur cylindrique de douze mètres de long qui renferme 864 serveurs. Il a été conçu et assemblé en France, à Brest, par Naval Group, une entreprise spécialisée dans la fabrication de navires et de sous-marins de classe militaire. Naval Group a justement exploité cette expertise en adaptant un procédé de refroidissement par circulation d'eau de mer couramment utilisé pour les sous-marins.

Le datacenter de Microsoft alimenté par des énergies renouvelables

Le datacenter de Microsoft est situé sur le European Marine Energy Center, un site d'essai pour les technologies marémotrices et houlomotrices. Sur les îles Orcades, des éoliennes et des panneaux solaires alimentent les 10.000 habitants à 100 %. Le datacenter sera lui aussi alimenté uniquement par des énergies renouvelables. Microsoft indique qu'il consomme un peu moins d'un quart de mégawatt lorsqu'il fonctionne à pleine charge.

Ce centre de données est prévu pour pouvoir fonctionner cinq ans sans maintenance. Avec ce projet Natick lancé en 2014, le géant américain explique qu'il veut déterminer la viabilité économique d'un tel concept avant d'envisager un déploiement opérationnel.

Nos données bientôt hébergées au fond des mers ?

Article initial de Marc Zaffagni, paru le 2/02/2016

Les gigaoctets de données qui transitent chaque seconde sur Internet passent par des centres de données dont les milliers de serveurs consomment autant d'énergie pour fonctionner que pour se refroidir. Dès lors, l'idée de plonger ces installations dans l'eau et de les alimenter grâce aux courants marins n'est peut-être pas si surprenante. Microsoft a tenté l'expérience et obtenu des résultats prometteurs.

L'eau, qui plus est salée, n'est pas le premier élément dans lequel on envisage de plonger des ordinateurs. Et pourtant, c'est exactement ce qu'a fait Microsoft. Le géant de l'informatique a lancé un programme expérimental portant le nom de code projet Natick (nom d'une ville nord-américaine de l'État du Massachusetts) qui consiste à immerger un centre de données (datacenter) dans un conteneur étanche à une dizaine de mètres de profondeur. Les objectifs sont multiples.

Tout d'abord, il s'agit de refroidir efficacement ces installations qui dégagent une énorme quantité de chaleur. Sur terre, le problème du refroidissement des centres de données est un véritable casse-tête. En 2008, GoogleGoogle avait lui aussi envisagé d'installer des serveurs dans l'océan avec, en prime, une récupération de l'énergie des vaguesvagues à l'aide d'une barge flottante articulée.

Plongé dans l'eau froide, le conteneur n'a pas besoin d'être climatisé. Microsoft précise que son datacenter n'utilise pas non plus d'eau pour se refroidir, la dissipation se faisant par des échangeurs thermiques. À l'intérieur, le caisson est pressurisé avec de l'azoteazote, lequel transmet la chaleurchaleur produite par les circuits électroniques. L'autre avantage mis en avant est la rapiditérapidité avec laquelle des centres de données de ce type peuvent être mis en service. Là où il faut compter environ deux ans de travaux pour aménager un datacenter sur la terre ferme, ces conteneurs pourraient être opérationnels sous 90 jours.

Par ailleurs, l'immersion près des côtes, à quelques encablures des villes, pourrait contribuer à améliorer les performances des services en ligne. En effet, Microsoft rappelle que la moitié de la population vivant à moins de 200 kilomètres de la mer, installer des centres de données sous-marins permettrait de réduire le délai de latence, c'est-à-dire la duréedurée du transittransit de l'information entre la source et son destinataire. Un facteur clé sachant que la consultation de vidéos en streaming est désormais le plus gros consommateur du trafic Internet, sans parler de l'explosion à venir de l'Internet des objetsInternet des objets qui nécessitera toujours plus de puissance de calcul.

Les crevettes font plus de bruit que les disques durs

Pour ce qui est de l'alimentation, l'idée est de recourir à des énergies renouvelablesénergies renouvelables produites, par exemple, par des hydroliennes. Microsoft dit vouloir créer des installations « zéro émission » à partir de matériaux recyclés et, de plus, recyclables une fois en fin de vie. Un datacenter sous-marin pourrait fonctionner pendant environ cinq ans sans maintenance, avant que les serveurs ne doivent être remplacés par des modèles plus performants. La durée de vie totale de l'ensemble serait « au moins » de vingt ans.

Un essai en conditions réelles a été mené durant la période août-novembre 2015. Le conteneur baptisé Leona Philpot (nom d'un personnage du jeu vidéo Halo développé par Microsoft) a passé 105 jours dans l'océan Pacifique par dix mètres de fond, à environ un kilomètre de San Luis Obispo (Californie). Une série de capteurscapteurs avaient été installés pour surveiller non seulement la stabilité de l'installation informatique, mais aussi son impact sur l'environnement. Des capteurs acoustiques ont permis de constater que le cliquetis de la queue des crevettes vaquant autour du caisson couvrait le bruit des disques dursdisques durs et des ventilateurs.

Quant à la chaleur dégagée à proximité immédiate du caisson, l'équipe en charge du projet assure qu'elle est minime. À voir tout de même ce qu'il en sera du bruit et de la dissipation thermique avec un datacenter plus volumineux, car celui-ci ne contenait qu'une seule baie. L'équipe du projet Natick est en train de plancherplancher sur une installation trois fois plus grande qui sera co-développée avec un concepteur de systèmes d'énergie renouvelable issus de la mer. Un nouvel essai aura lieu l'année prochaine, peut-être du côté de la Floride ou en Europe du Nord. Microsoft n'a pour le moment annoncé aucun plan pour un déploiement commercial de ce type d'installation.