au sommaire

Le concept de trou noir est assez ancien puisqu'on peut le faire remonter à Michell et Laplace mais, probablement plus que tout autre, c'est Subrahmanyan ChandrasekharSubrahmanyan Chandrasekhar qui est responsable de son introduction dans le monde de la physique théorique et surtout de l'astrophysique. Dans l'esprit du grand public, un trou noir est ce monstre vorace qui attire tout et dont on ne peut s'échapper. Pourtant, si notre Soleil devait se transformer en trou noir, son attraction sur notre planète serait identique et il n'y aurait que dans la zone s'étendant entre la surface actuelle du Soleil et celle de la surface du nouveau trou noir, d'un diamètre de moins de 10 km, que l'intensité du champ de gravitation serait beaucoup plus grande.

Jamais cependant notre étoileétoile ne se transformera en trou noir car il faudrait pour cela que sa massemasse soit plusieurs dizaines de fois supérieure. Dans le cas des étoiles dépassant les 30 masses solaires, il est alors possible un jour que leur cœur dépasse la masse de Chandrasekharmasse de Chandrasekhar qui est de 1,4 fois la masse du Soleil environ. Arrivé à ce point de l'évolution des réactions nucléairesréactions nucléaires dans ce coeur et en vertu des lois de la mécanique quantiquemécanique quantique et de la relativité, plus aucune force ne sera capable de s'opposer à la gravitation et, si l'on excepte le cas des étoiles à neutronsétoiles à neutrons dont la masse limite n'est guère plus élevée, un effondrementeffondrement gravitationnel en une singularité se produira inévitablement, pour le moins dans toute théorie faisant intervenir la relativité généralerelativité générale d'EinsteinEinstein sous sa forme classique et non quantique.

Combien pèse le plus petit des trous noirs ?

La masse de Chandrasekhar est-elle la masse du plus petit trou noir pouvant exister dans le cosmoscosmos ? Presque, même si l'on sait bien qu'en réalité, pour une masse M donnée, il suffirait de pouvoir la concentrer dans une région sphérique dont le rayon est donné par Rs=2GM/c2, le rayon de Schwarzschildrayon de Schwarzschild, pour obtenir un trou noir (G est la constante de la gravitationconstante de la gravitation, c la vitesse de la lumièrevitesse de la lumière )). Mais comme il faut des pressionspressions énormes que l'on ne retrouve que dans le domaine de l'astrophysique, il faut en conclure que la masse limite d'une étoile à neutrons, celle dite de Landau-Oppenheimer-Volkoff, est bien, non seulement la masse limite pour la stabilité d'une étoile ayant épuisé son carburant nucléaire mais aussi la masse minimale pour un trou noir.

De gauche à droite Chandrasekhar, Novikov et Zeldovitch. © DP

Mais cette conclusion est fausse ! Stephen HawkingStephen Hawking le démontra en 1971 en utilisant notamment les travaux des deux grands leaders de l'astrophysique et de la cosmologiecosmologie relativiste qu'étaient Yakov Zeldovich et Igor Novikov publiés en 1967.

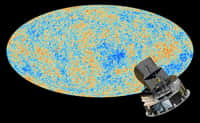

Dans le cadre des modèles cosmologiques de type Big BangBig Bang, on sait que la densité « initiale » de l'UniversUnivers observable était très grande et, si l'on en croit les équationséquations tentant de décrire l'état de la matièreétat de la matière et du champ de gravitation proche de la singularité cosmologique initiale en relativité générale classique, l'Univers était alors très turbulent avec des fluctuations chaotiques de sa métrique et de sa densité comme le montrent bien les travaux de Misner (c'est le modèle connu sous le nom de mixmaster univers), ainsi que de Belinsky, Khalatnikov et Lifchitz.

Dans ces conditions infernales, si une fluctuation de densité devient telle qu'une masse donnée passe sous son rayon de Schwarzschild, un mini trou noir en résultera. En fait, étant donné la vitesse limite de propagation des interactions (celle de la lumière), si l'on considère une bulle de lumière émise par une zone de la taille de la longueur de Plancklongueur de Planck au temps de Plancktemps de Planck, que l'on pourra approximer par des valeurs nulles, alors une telle densité de matière (ou d'énergieénergie car un gazgaz de photonsphotons ferait tout aussi bien l'affaire) pourra conduire à un effondrement gravitationnel à l'instant t si une masse

M(t)=c3t/G = 1015 (t /10-23) g

se trouve à l'intérieur de cette bulle de lumière dont le rayon aura une longueur ct.

Cela est facile à comprendre. Si la fluctuation de densité occupe une région de taille supérieure à cette bulle, les interactions gravitationnelles n'ont pas eu le temps de se propager entre ces différentes parties depuis le «début » de la naissance de l'Univers observable et la surdensité ne « sait » pas qu'elle doit s'effondrer.

On peut ainsi former des mini trous noirs de masse aussi faible que la masse de Planck, Mp=10-5 g, et au-delà, puisque la masse des trous noirs pouvant apparaître 1s après le Big Bang est de 105 masses solaires.

Des trous noirs au cœur des atomes ?

Selon le modèle cosmologique que l'on utilise pour décrire la naissance du cosmos observable, le spectrespectre des fluctuations de densité de matière/énergie ne sera pas le même, et donc, la taille et le nombre de trous noirs primordiaux existant actuellement seront des indications précieuses pour poser des bornes sur la turbulenceturbulence et le type de modèle cosmologique adapté à la description des premières secondes de l'histoire du cosmos avant que la géométrie de l'espace-tempsespace-temps ne s'isotropise et ne s'homogénéise pour finir par être décrite par de légères perturbations sur un fond de type Friedmann Robertson-Walker avec constante cosmologiqueconstante cosmologique.

C'est d'ailleurs ce que Stephen Hawking a été le premier à comprendre et qui fit l'objet de deux publications, avant sa découverte retentissante de 1974. Il était même allé plus loin car, connaissant l'existence de solutions décrivant des trous noirs chargés, il avait postulé qu'une partie des particules du rayonnement cosmique pouvait être constituée de ces mini trous noirs et que des sortes d'atomesatomes, avec en leur centre un tel mini trou noir, pouvaient s'être formés.

C'est notamment en étudiant les propriétés de ces mini trous noirs qu'il découvrit que ces derniers pouvaient se comporter comme des particules élémentairesparticules élémentaires, ou des noyaux chauds instables, en train de se désintégrer en émettant ce qui fut baptisé par la suite le rayonnement Hawking. En fait, comme il l'avait montré dès 1974, même des trous noirs produits par des étoiles devaient être capables de s'évaporer en émettant ce rayonnement.

Le processus est d'autant plus rapide que le trou noir est petit. Or, lorsque celui-ci atteint la masse de Planck, les calculs de Hawking s'effondrent et il faut faire intervenir une théorie de la gravitation quantique comme la théorie des supercordesthéorie des supercordes ou la gravitation quantique à bouclesgravitation quantique à boucles. Le destin ultime de l’évaporation d’un mini trou noir est en fait l’un des grands problèmes irrésolus de la physique théorique moderne. Comme on l'a déjà laissé entendre, au fur et à mesure qu'un mini trou noir se rapproche de la masse de Planck, on peut le considérer comme l'ultime particule élémentaire, celle où toute la physique des hautes énergies, toutes les particules et les forces s'unifient avec l'espace-temps.

Des sujets d'études fascinants mais difficilement saisissables

Il n'y a donc probablement pas d'objets physiques aussi fascinants et aussi cruciaux dans notre compréhension du cosmos dans l'Univers, si l'on excepte évidemment le cerveaucerveau humain. Si l'on fait le bilan de ce que l'on vient d'exposer, les mini trous noirs sont en effet :

- Des sondes cosmologiques de l'Univers primordial et de sa « naissance » ;

- Des sondes ultimes de la physique des hautes énergies ;

- Le lieu de l'Unification de toute la physique, l'espace-temps, la matière, les forces, la relativité générale et la mécanique quantique.

Si les mini trous noirs sont bien d'une certaine façon l'ultime particule élémentaire, alors il serait du plus haut intérêt de pouvoir les fabriquer en accélérateur. Cela permettrait de tester en laboratoire des théories de gravitation quantique en champ fort, précisément ce dont on a besoin pour unifier toute la physique et comprendre l'origine de l'Univers.

Quelle serait la taille d'un tel accélérateur capable d'atteindre l'énergie de Planck ? La réponse est simple, pour accélérer selon les mêmes techniques qu'au LHCLHC des paires de protonsprotons et produire des collisions avec des énergies au moins égales à celle de Planck, c'est-à-dire 1019 GeVGeV, il faudrait un accélérateur grand comme la GalaxieGalaxie, donc d'un diamètre de 100.000 années-lumièreannées-lumière environ !

Même dans les délires les plus fous dans lesquels l'humanité coloniserait la Galaxie, une telle machine est évidemment impossible à construire. La situation semblait sans espoir jusqu'à la fin des années 1990, lorsque deux groupes de chercheurs firent deux découvertes remarquables qui changèrent complètement les perspectives.

Le premier groupe était constitué de Nima Arkani-Ahmed, Gia Dvali, Savas Dimopoulos et le second de LisaLisa Randall et Raman Sundrum. Pour comprendre ce qu'ils ont fait, il faut malheureusement entrer dans quelques détails techniques mais en fait, que le lecteur ait la foi en ses capacités et qu'il ne s'effraie pas !

Une certaine incompatibilité avec les théories en vigueur

Dans les deux cas, les chercheurs étaient partis des problèmes suivant.

Dans le cadre du modèle standardmodèle standard des quarksquarks et des leptonsleptons, intéragissant grâce aux forces électrofaible et nucléaire forte, on sait que la masse des particules y est fixée par le mécanisme de Higgs et son fameux boson.

Pour que cela marche, il faut que ce bosonboson ait une masse inférieure à 1 TeV (1.000 GeV). Jusque-là tout va bien.

Mais voilà... Si l'on plonge le modèle électrofaible dans une théorie grand unifiée (GUTGUT) pour incorporer la force nucléaire forte et encore mieux la gravitation, on tombe sur un petit souci. Les effets des corrections quantiques « renormalisent » la masse du Higgs et exigent que sa masse soit de l'ordre de celles des énergies auxquelles ces forces s'unifient, donc 1015 GeV environ pour la Grande Unification (GUT) et la masse de Planck, Mp = 1019 GeV, si l'on incorpore la gravitation. Cette valeur très élevée est incompatible avec ce que l'on sait par ailleurs des masses de particules, rappelons que la masse d'un proton est d'à peine 1 GeV et celle d'un électronélectron presque 2000 fois plus faible.

On peut essayer de faire un réglage fin artificiel des équations de la théorie pour échapper au problème mais chaque fois qu'on essaie de le jeter par la porteporte il revient par la fenêtrefenêtre quelque part ailleurs dans les équations sous la même forme et surtout, on n'a aucune explication du réglage fin qui reste ad hoc. C'est le célèbre problème de la hiérarchie !

Pourquoi un tel écart entre l'échelle de brisure de symétrie du modèle standard, lorsque les forces faibleforces faible et électromagnétique se séparent (~1.000 GeV) et celle des théories de type GUT (~1015 GeV), l'échelle à laquelle la force nucléaire de la QCD (chromodynamique quantiquechromodynamique quantique) s'individualise ?

Et surtout comment empêcher l'une de contaminer l'autre, en particulier lorsque l'Unification à la gravitation se produit ?

En gros, jusque vers 1998, il n'y avait qu'une réponse : la supersymétriesupersymétrie ( la seconde, la technicouleur, semble exclue par les données du LEPLEP, au début des années 1990). C'est d'ailleurs une des raisons majeures de son introduction, mais pas de sa découverte.

En route vers de nouvelles dimensions

Une seconde solution existe, introduire des dimensions supplémentaires. Voyons-voir pourquoi. Ce qui est ennuyeux c'est au fond que la masse de Planck soit si grande. Mais alors pourquoi ne pas faire baisser cette masse de Planck ?

Cela peut sembler complètement fou car, après tout, la masse de Planck dépend uniquement de la vitesse de la lumière c, de la constante de Planckconstante de Planck h et de la constante de la gravitation G , des constantes universelles justement. Patience, suivons initialement l'idée de Dimopoulos, Dvali, Arkani-Hamed en 1998 qui sont partis de la théorie des supercordes.

Nima Arkhani-Hamed. © Rutgers university

Comme toujours en physique fondamentale, les lois découlent d'un principe de moindre action. Il n'est pas central pour le lecteur de savoir ce que cela signifie pour comprendre la suite de l'article. Tout ce qu'il faut savoir, c'est qu'il existe une quantité baptisée action de Einstein-Hilbert et que l'on note SEH et qui permet de dériver les équations d'Einstein du champ de gravitation. Elle s'écrit:

SEH = c4/16πG4 ∫R4 d4x

Où R4 est le scalaire de courbure en 4d de l'espace-temps (obtenu par contraction du tenseur de Riemann) et G4, notre bonne vieille constante de la gravitation en dimension 4. L'action de Einstein Hilbert se calcule en faisant une somme intégrale sur un domaine de l'espace-temps à quatre dimensions.

Lorsque l'on cherche à unifier les interactions avec la gravitation, une stratégie est d'augmenter le nombre de dimensions de l'espace, comme dans les cas des théories de Kaluza-Klein et des supercordes. On peut alors dériver les équations d'Einstein en n dimensions immédiatement avec SEH en sommant dans un volumevolume d'espace-temps à n dimensions.

Plus précisément, ajoutons p dimensions supplémentaires tel que p+4=n, on aura alors :

SEH ~∫Rn d4x dpy

Où Rn est toujours le scalaire de courbure mais en n dimensions.

Posons Gn comme étant la constante de la gravitation dans un espace-temps à n dimensions.

Si on intègre sur y alors on obtient magiquement que ce que l'on prend pour la « vraie » constante de gravitation en 4d est en fait la constante exacte en nd corrigée par un facteur de volume Vp provenant des dimensions supplémentaires.

Au final, la vrai constante de la gravitation Gn en n dimensions est donnée par

Gn = G4Vp

Si l'on fait intervenir le carré de la masse de Planck Mpl habituelle en 4 dimensions, la véritable masse de Planck M en n dimensions devient alors (si l'on pose h=c=1 dans un système d'unités convenable).

M2 pl = Mn+2 Vp

La solution saute aux yeuxyeux !

Si Vp est suffisamment grand l'échelle de grande unification est alors autour de 1 Tev et tout rentre dans l'ordre même sans supposer la supersymétrie.

En bonus, cela voudrait dire que toute la physique de la Grande Unification et de la gravitégravité quantique pourrait être accessible au LHC !

Raman Sundrum. © TASI

Il existe une autre approche du problème de la hiérarchie qui utilise elle aussi des dimensions supplémentaires mais qui ne présuppose pas que la théorie des cordesthéorie des cordes soit vraie. Elle repose sur le modèle de géométrie déformée (warped products) avec une dimension supplémentaire et elle était en fait connue depuis les années 1980 dans les théorie de supergravitéssupergravités de Kaluza-Klein.

Elle a été proposée en 1999 par Lisa Randall et Raman Sundrum. Elle consiste juste à prendre les équations de la gravitation d'Einstein en 5d (Kaluza-Klein) pour décrire deux univers parallèles en 4 dimensions séparés par une distance faible s'étendant selon une cinquième dimension. La métrique d'espace temps servant à mesurer les distances dans un tel Univers, une généralisation du théorème de Pythagorethéorème de Pythagore, est alors de la forme suivante.

ds2 = f(y)[-dt2+dl2] +dy2

où y correspond à une cinquième coordonnée d'espace.

En introduisant cette métrique dans le scalaire de courbure précédent de l'action de Einstein-Hilbert, magiquement, on retombe sur la situation décrite précédemment. Tous calculs faits dans des intégrales similaires à la précédente on trouve un facteur V qui dépend de f(y) et qui peut lui aussi être grand.

Dans les deux cas, la masse de Planck pourrait donc être de 1 TeV mais en fait, rien ne l'y force, elle pourrait tout aussi bien être de 1.000 TeV. La prendre égale à quelques TeV n'est qu'une des façons d'éliminer le problème de la hiérarchie de façon élégante, mais rien ne nous prouve que la Nature ait choisi cette façon de procéder.

Lisa Randall. © Matthew J. Lee

Il devrait être possible de fabriquer des mini trous noirs

Soyons optimiste et prenons-la égale à 5 TeV. Dans ces conditions, si deux particules possédant une énergie E supérieure à cette masse de Planck entre en collision et dans un volume dont le rayon est inférieur au rayon de Schwarzschild Rs=2GM/c2 donné par l'équivalent en masse M=E/c2 de cette énergie, un mini trou noir se formera aussitôt !

Les premiers à envisager cette possibilité furent Tom Banks et Willy Fischler en 1999. Cet article précurseur envisageait clairement qu'un tel mini trou noir devait s'évaporer très rapidement à cause de l'effet Hawking mais il faudra attendre le coup de tonnerretonnerre des articles de Steven Giddings et Savas Dimopoulos en 2001 pour que les premiers calculs un peu détaillés de ce scénario soient publiés et attirent l'attention d'une large partie de la communauté scientifique.

Tom Banks. © Rutgers University

Steven Giddings expliquant la théorie du Paysage cosmique (Landscape) avec une surface de Riemann. © Richard Harris, NPR

Très rapidement, les deux articles de 2001 ont donné lieu à de multiples autres explorant non seulement la possibilité de créer des mini trous noirs au LHC mais aussi de les observer dans les collisions des rayons cosmiquesrayons cosmiques à hautes énergies tombant sur Terre, avec des instruments au sol comme Auger et IceCube. Le débat a aussi fait ragerage sur le bien-fondé des calculs de production de mini trous noirs à des énergies supérieures à l'énergie associée à la nouvelle masse de Planck, ainsi que sur l'observabilité du rayonnement Hawking de ces mini trous noirs.

C'est dans ce contexte que les travaux d’Aurélien Barrau et ses collègues, parmi lesquels Julien Grain et Stanislas Alexeyev, s'inscrivent. Futura-Sciences a donc demandé au lauréat du prix Bogoliubov 2006 de nous en dire plus sur la possible découverte de mini trous noirs au LHC. Etant donné la polémique sur InternetInternet au sujet des prétendus risques d’une fin du Monde entraînée par de tels objets, nous lui avons bien évidemment demandé aussi ce qu'il en pensait. Il a généreusement pris de son temps pour répondre à toutes nos questions lors d'une interview, celle-ci fera l'objet d'un prochain article.