au sommaire

Novembre 2015 fut marqué par le centenaire de la découverte par EinsteinEinstein de la théorie de la relativité générale. Puis, en 2016 -- soit cent ans après la découverte théorique de la première solution des équations d'Einstein décrivant un trou noir, par Karl Schwarzschild, et les premiers travaux d'Einstein sur les ondes gravitationnellesondes gravitationnelles --, les membres de la collaboration eLigo ont annoncé la mesure directe sur Terre, pour la première fois, des ondes gravitationnelles provenant de la fusion de deux trous noirs.

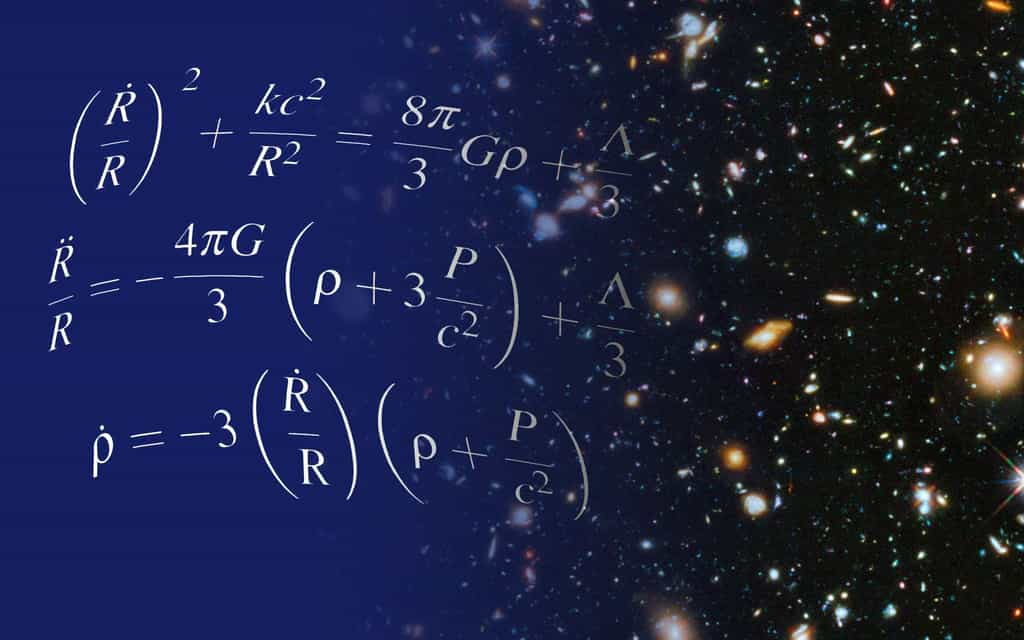

En cette année 2017, nous pouvons à nouveau fêter un centenaire remarquable : celui de la découverte du tout premier modèle de cosmologie relativiste (en 1917, donc), et c'est encore à Einstein que nous devons cette découverte. Pour diverses raisons, pour construire ce modèle, le père de la relativité avait été conduit à introduire une nouvelle constante physique dans les équations de la relativité générale, naturellement permise, voire présente, du fait des principes mathématiques de cette théorie. Cette constante lui permettait notamment d'obtenir un universunivers statique et éternel, réminiscence du monde céleste supralunaire d'AristoteAristote.

Einstein se trompait au moins sur un point : celui du caractère statique de l'espace-tempsespace-temps, comme devaient le montrer Friedmann, Hubble et Lemaître. Toutefois, en ce qui concerne la constante cosmologiqueconstante cosmologique, l'intérêt et la signification de sa nature ne cessent de fluctuer depuis lors.

À la fin des années 1990, alors que cette constante avait été éliminée des modèles de cosmologie relativiste, la découverte de l'expansion accélérée de l'univers observable imposa sa réintroduction. Un prix Nobel fut accordé en 2011 aux découvreurs mais, prudemment, il se limita à récompenser la découverte de cette accélération et ne célébra pas du tout son interprétation possible, avec la présence de la constante cosmologique d'Einstein, à savoir l'existence de l'énergie noire.

L’univers est en expansion. Si l’on tient compte de la gravité, cette expansion devrait ralentir et pourtant elle semble accélérer au cours du temps. Ce phénomène pourrait être dû à une force étrange : l’énergie noire. Jean-Pierre Luminet, astrophysicien de renom, explique, pour Futura, ce que recouvre cette étrange notion. © Futura

L'homogénéité, une hypothèse commode pour résoudre les équations d'Einstein

Ce point est important en raison de la récente publication dans les célèbres Monthly Notices of the Royal Astronomical Society d'un article étonnant, disponible sur arXiv. Dans celui-ci, un groupe de chercheurs hongrois suggère que l'énergie noireénergie noire n'existe tout simplement pas !

Toutefois, ils ne remettent nullement en cause l'existence d'une phase d'expansion accélérée depuis quelques milliards d'années de l'univers observable. La cosmologie standard n'en serait donc nullement bouleversée, pas plus que la théorie du Big BangBig Bang.

En revanche, s'ils ont raison, cela réduirait à néant l'espoir de découvrir de la nouvelle physique en précisant les caractéristiques des causes de cette accélération (avec, en particulier, la mise en service du LSST et du satellite EuclideEuclide). Pour comprendre pourquoi il pourrait en être ainsi, il faut remonter aux hypothèses de base de la cosmologie relativiste, et plus particulièrement à celle de l'homogénéité de l'univers observable à suffisamment grande échelle.

Les équations de la relativité générale sont particulièrement difficiles à résoudre car elles sont non linéaires. L'une des caractéristiques qui font un bon physicienphysicien est la capacité de trouver des hypothèses permettant de simplifier les équations avec de judicieuses approximations qui permettent de les résoudre simplement tout en trouvant des solutions qui ne s'écartent pas trop des solutions exactes. On a donc fait l'hypothèse que si l'on considère l'univers à suffisamment grande échelle, sa densité de matièrematière est partout la même. On peut donc poser que le cosmoscosmos observable est une sorte de fluide de galaxiesgalaxies, tout comme l'eau nous apparaît un fluide à notre échelle et que nous ne notons pas le vide entre les moléculesmolécules d'eau ni le fait qu'elles soient un peu plus nombreuses dans certaines régions.

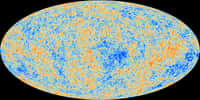

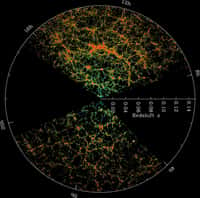

Cette hypothèse semble particulièrement bien justifiée quand on observe l'univers à une échelle de plusieurs centaines de millions d'années-lumièreannées-lumière, surtout quand il était jeune, au moment où le rayonnement fossilerayonnement fossile a été émis. Cependant, presque 10 milliards d'années après le Big Bang, nous observons bien aussi que les galaxies ont fini par se rassembler pour former des filaments avec de grands vides à une échelle inférieure à plusieurs centaines de millions d'années-lumière.

Les simulations numériques conduites par les chercheurs hongrois. En haut à gauche, en rouge, la formation des grandes structures dans le cadre du modèle standard avec énergie noire et accélération de l'expansion. En haut à droite, en vert, un modèle sans constante cosmologique et qui décélère. En haut, au milieu, en bleu, un modèle sans énergie noire mais avec constante cosmologique et qui accélère. Le résultat ressemble beaucoup à celui du modèle standard. © Royal Astronomical Society

Une constante cosmologique sans nouvelle physique ?

Ne faudrait-il pas considérer des solutions aux équations d'Einstein dans lesquelles la répartition de la matière ne peut pas vraiment être considérée comme homogène bien qu'elle le soit un peu quand même ? La question se pose depuis un certain temps et de célèbres théoriciens, comme Robert Wald et Thomas Buchert, s'affrontent sur l'importance ou non à donner en cosmologie relativiste sur les effets de la prise en compte d'un univers finalement pas vraiment homogène. Le sujet est d'importance car, qui dit un univers non homogène, dit un univers dont la vitessevitesse d'expansion, à un même moment global de son histoire, ne serait pas la même de façon non négligeable selon les densités, et donc les lieux, dans cet univers.

Or, magiquement, quand on fait des moyennes avec ces densités variables dans les équations d'Einstein sans constante cosmologique au départ, on aboutit finalement à l'apparition de cette constante qui ne serait donc qu'un effet d'une physique très ordinaire et bien connue.

C'est justement pour en avoir le cœur net que les astrophysiciensastrophysiciens hongrois ont décidé de refaire les simulations numériquessimulations numériques de leurs collègues décrivant la formation et l'évolution des grandes structures avec une expansion localement variable en fonction des densités locales de matière. On aboutit donc à un système d'équations dans lequel ces densités rétroagissent sur les vitesses d'expansion qui font elles-mêmes varier ces densités au cours du temps et dans l'espace.

Or, selon ces chercheurs, leurs simulations reproduiraient aussi bien l'évolution des grandes structures de galaxies de l'univers observable que le modèle standardmodèle standard avec son hypothèse d'homogénéité. Reste à savoir quelles vont être les réactions de leurs collègues qui vont peut-être finir par pointer du doigt quelques erreurs dans les hypothèses à la base des méthodes numériques utilisées. Ou peut-être faudra-t-il abandonner l'énergie noire, tout en maintenant l'existence d'une constante cosmologique dont l'étude ne nous donnerait donc pas d'indice sur l'unification des lois de la physique et la naissance du cosmos à moins qu'elle ne soit connectée à la matière noirematière noire de façon particulière.

Faut-il remettre en cause l'énergie noire ? L'avis d'Alain Blanchard

Article de Laurent SaccoLaurent Sacco publié le 08/11/2016

La découverte de l'accélération de l'expansion de l'universaccélération de l'expansion de l'univers observable, un phénomène que l'on attribue à l'existence de l'énergie noire, a été remise en cause par un groupe de chercheurs. Pour savoir si elle est fondée, Futura a interrogé le cosmologiste Alain Blanchard.

Tout récemment, Subir Sarkar, un éminent physicien et cosmologiste à la tête du groupe des théoriciens de la physique des particules de l'université d'Oxford, a fait quelques vaguesvagues en publiant un article dans Nature avec des collègues. Il a certainement attiré l'attention de tous ceux qui, au minimum, se sentent mal à l'aise avec le modèle standard en cosmologie du fait qu'il postule l'existence de deux composantes de nature largement inconnues dans l'univers observable : l'énergie noire, qui accélère son expansion, et la matière noire, qui rend compte des propriétés des structures galactiques. Il a dû réjouir également les opposants à la théorie du Big Bang.

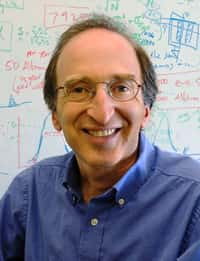

Subir Sarkar est l'auteur de nombreuses recherches en astrophysique, en cosmologie par exemple sur la théorie de l'inflation, la nucléosynthèse, les neutrinos, la matière noire, l'énergie noire. Il est professeur à Oxford et membre du Rudolf Peierls Centre for Theoretical Physics. © The Mag Theme

Il faut dire que Subir Sarkar remet en cause la solidité des résultats observationnels qui ont conduit à la réintroduction de la constante cosmologique d’Einstein en cosmologie, ou, plus prosaïquement, la découverte de l'expansion accélérée du cosmos observable vers la fin des années 1990 qui a conduit à l'attribution d'un prix Nobel de physique en 2011.

Les supernovae et l'énergie noire

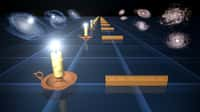

Rappelons que cette découverte s'est faite en utilisant les supernovaesupernovae SNSN Ia que l'on peut considérer comme d'assez bonnes chandelles standardschandelles standards même s'il faut faire des corrections aux observations pour en faire de bons étalons de distance dans l'univers observable. On a des raisons de penser que les SN Ia sont des explosions dont la luminositéluminosité est relativement constante, donc moins elles apparaissent lumineuses, plus elles sont loin. En mesurant leur luminosité apparente ainsi que leurs décalages spectraux, on peut déterminer la vitesse d'expansion de l'univers au cours de son histoire.

Nous disposons maintenant d'un plus grand nombre d'observations de SN Ia qu'au siècle dernier. Ce qui veut dire que l'on peut en principe obtenir une mesure plus précise des variations de la vitesse d'expansion et, surtout, de consolider la découverte de son accélération. Ce n'est pas difficile à comprendre. Par analogieanalogie, on a moins de chance de se tromper dans l'estimation du résultat d'une élection si l'on interroge 10.000 personnes que 10.

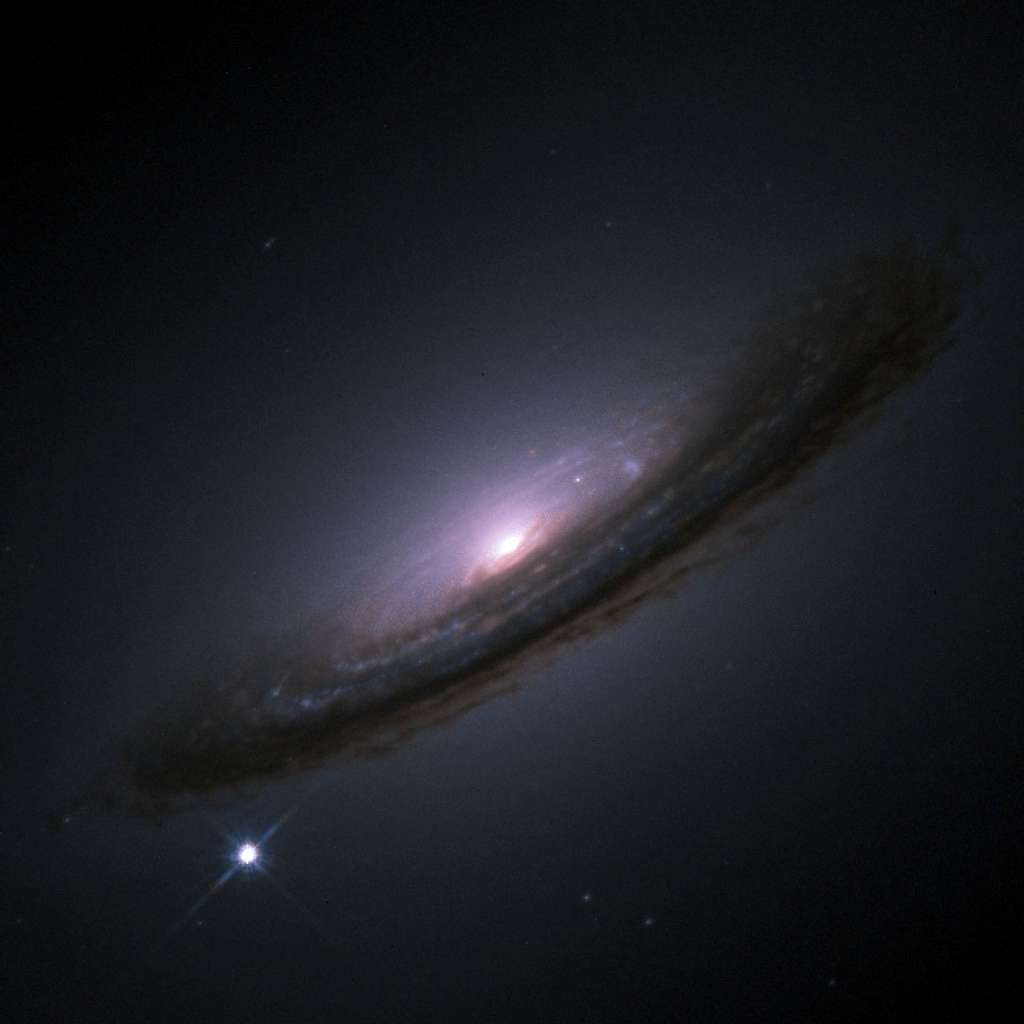

La supernova SN 1994d dans la galaxie NGC 4526. © Nasa, ESA, The Hubble Key Project Team, The High-Z Supernova Search Team

Subir Sarkar et ses collègues ont donc utilisé un catalogue de 740 SN Ia, soit près de 10 fois plus de supernovae, pour tenter de confirmer l'existence d'une accélération de l'expansion. Les chercheurs ont par ailleurs utilisé une méthode statistique un peu différente de leurs prédécesseurs.

Le résultat obtenu a de quoi troubler, en première impression en tout cas. L'accélération de l'expansion ne serait en fait pas prouvée par les données issues des SNIa. Elles suggèrent bien son existence mais avec, selon le jargon des physiciens, une évidence d'environ 3 sigma. Or il faut au moins 5 sigma pour parler d'une découverte en physique, c'est-à-dire un signal qui diffère à tel point d'un effet du hasard qu'il n'est pas raisonnable de penser, bien que cela reste logiquement possible, que cela en soit bien un.

Le modèle de concordance en cosmologie standard

Faut-il en conclure que ceux qui pensent que les astrophysiciens et les cosmologistes ont une attitude bien dogmatique et manquent naïvement de prudence en accréditant le fameux modèle cosmologique ΛCDM avaient raison ? Doit-on même aller jusqu'à remettre en cause le Big Bang ? Pour le savoir, Futura s'est tourné vers le cosmologiste Alain Blanchard qui lui-même a eu des doutes pendant un moment sur l'existence de l'énergie noire.

Une présentation de l'astrophysicien et cosmologiste Alain Blanchard. © La Novela

Futura : Les Anglo-saxons ont une expression qui décrit assez bien la surprise qu'on éprouve en prenant connaissance de l'article de Subir Sarkar, « A bolt out of the blue », « une flèche tombée du ciel ». Est-ce justifié ?

Alain Blanchard : Pas vraiment, en 2014 par exemple, une équipe internationale d'astronomesastronomes et de physiciens des particules avait déjà analysé les données de 740 supernovae SN Ia, obtenues grâce au Sloan Digital Sky Survey II et au SuperNova Legacy Survey. L'analyse, menée en particulier par Marc Bétoule du LPNHE avait conduit à un résultat similaire. Bien que suggérée par ces données, l'accélération de l'expansion de l'univers observable depuis quelques milliards d'années n'est en effet pas démontrée en se basant sur les SN Ia.

Cela semble extrêmement dérangeant, le comité du Prix Nobel a-t-il fait une grave erreur en attribuant le prix Nobel de physique en 2011 à Saul Perlmutter, Brian Schmidt et Adam Riess ?

Alain Blanchard : Non, absolument pas. Il ne faut pas oublier, et Subir Sarkar et ses collègues ne le font pas, qu'il existe d'autres observations qui conduisent à admettre l'existence d'une accélération de l'expansion de l'univers observable et donc celle de l'énergie noire. Lorsque les équipes menées par Perlmutter, Riess et Schmidt ont annoncé de 1998 à 1999 que leurs mesures conduisaient à suspecter fortement cette accélération, ils ont convaincu la communauté scientifique qu'il fallait prendre au sérieux la réintroduction de la constante cosmologique d'Einstein dans les modèles de cosmologie relativiste. Des recherches en ce sens ont donc été entreprises.

En fait, le grand cosmologiste Jim Peebles proposait déjà depuis le début des années 1980 qu'il fallait la réintroduire parce que le développement de la théorie de l'inflation indiquait que la géométrie de l'espace de l'univers observable devait être très proche d'une géométrie plate. Or il n'y avait pas assez de matière sous forme baryonique pour aboutir à cette géométrie. Paradoxalement, alors qu'il allait être l'initiateur du modèle de la matière noire froide en cosmologie, Peebles avait des réticences à postuler l'existence de cette matière non baryonique et il préférait augmenter la densité moyenne de l'univers en invoquant une constante cosmologique.

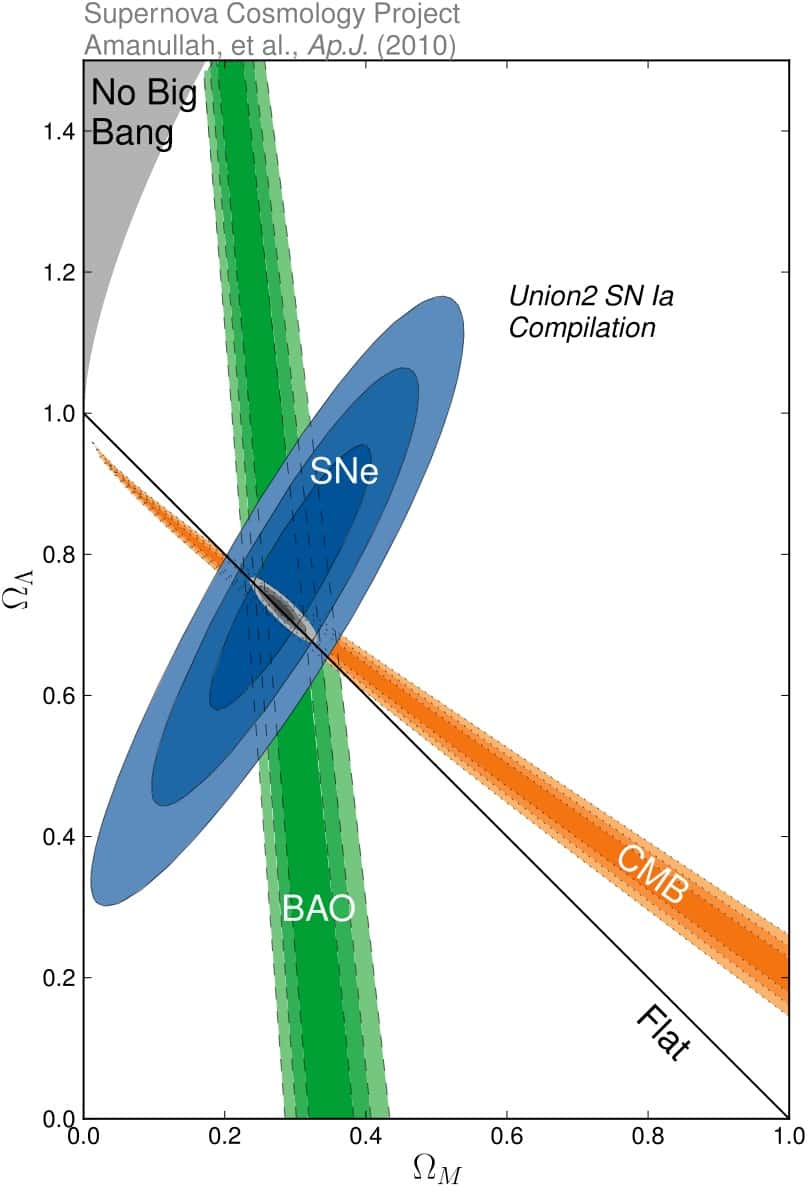

Au cours des années 2000 puis 2010, les mesures effectuées concernant le rayonnement fossile avec WMap puis PlanckPlanck et enfin celles concernant les oscillations acoustiques de baryonsbaryons se sont ajoutées à celles des supernovae. La confiance dans l'existence d'une accélération de l'expansion du fait de la présence dans les équations d'Einstein d'une constante cosmologique s'est alors considérablement renforcée et, avant 2011, on pouvait déjà parler d'une découverte.

En abscisse sur ce diagramme ΩM désigne la proportion de matière, baryonique et noire, dans la composition de l'univers observable et en ordonnée, ΩΛ, celle de l'énergie noire. Les contours colorés indiquent les valeurs de ces deux grandeurs compatibles avec les observations déduites de l'étude des supernovae (SNe), du rayonnement fossile (CMB) et des oscillations acoustiques de baryons (BAO). Les valeurs les plus probables sont aux centres des bandes colorées. On voit ainsi que déjà en 2010, la découverte de l'énergie noire était solidement acquise. © Lawrence Berkeley National Lab

Subir Sarkar mentionne en effet ces observations mais pour les critiquer aussitôt en faisant remarquer qu'elles ne font que confirmer un modèle qui sert à interpréter ces mesures, ce qui pourrait être un cercle vicieux.

Alain Blanchard : Effectivement, d'ailleurs la méthode d'analyse que lui et ses collègues ont employée apparaît comme une tentative de vérifier si l'on peut soutenir l'existence d'une accélération de l'univers observable en se basant sur un minimum d'hypothèse.

Il laisse entendre par exemple que l'on pourrait bien être victime des hypothèses de simplification à la base de la constructionconstruction du modèle standard, en particulier celle concernant l’homogénéité de l’univers à suffisamment grande échelle.

Alain Blanchard : Il y a eu des travaux qui ont montré qu'en ne supposant pas que les galaxies puissent être considérées à très grande échelle comme une distribution de densité constante, on peut bel et bien aboutir à un diagramme de HubbleHubble des supernovae qui se comporte comme en présence d'une constante cosmologique dans les équations dites de Friedmann-Lemaître-Robertson-Walker. On ne suppose donc pas de nouvelle physique ou un effet de l'énergie du vide quantique pour rendre compte de ces observations.

Depuis 2011, où en est-on justement en ce qui concerne la consolidation des preuves du modèle standard ?

Alain Blanchard : Il n'existe toujours pas d'alternative théorique vraiment crédible et convaincante et les observations de Planck ainsi que l'étude des oscillations acoustiques de baryons (baryon acoustic oscillations ou BAO en anglais) avec le Sloan Digital Sky Survey ont considérablement raffermi l'existence de l'énergie noire et de la matière noire. Tout dernièrement d'ailleurs, mes collègues et moi nous nous sommes penchés sur cette question dans un article disponible sur arXiv. Nous avons trouvé également qu'en se basant sur l'étude des supernovae seules, ou même en conjonctionconjonction avec les données concernant les BAO, il est possible d'accorder les observations avec aussi bien le modèle ΛCDM que d'autres, en particulier si l'on admet que la luminosité des SN Ia a évolué au cours de l'histoire de l'univers. Mais si l'on combine les mesures obtenues avec les supernovae, les BAO et le rayonnement fossile, seul le modèle standard passe le test et les alternatives que nous avons considérées sont fortement défavorisées.

Deux collègues viennent aussi de déposer sur arXiv une analyse de l'article de Subir Sarkar et ils sont très critiques. Au final, l'existence de la constante cosmologique semble bel et bien acquise avec, dans le jargon des physiciens, une découverte à 75 sigma, c'est énorme.

Il est assez ironique de penser que jusqu'il y a peu, nous concevions la gravitationgravitation comme une force attractive. Mais à l'échelle de l'univers, elle apparaît plutôt comme répulsive.

Ce qu’il faut

retenir

- L'expansion accélérée de l'univers observable depuis quelques milliards d'années n'est pas bien comprise.

- Le modèle cosmologique standard l'explique en introduisant la fameuse constante cosmologique d'Einstein mais la nature de cette constante fait débat et elle pourrait même en fait varier dans le temps et l'espace, selon certaines théories au-delà de la physique standard.

- Des simulations numériques semblent expliquer cette constante sans invoquer la fameuse énergie noire, et donc sans invoquer directement de la nouvelle physique.

- La constante cosmologique serait en fait une manifestation d'importantes différences de densités de matière dans l'univers.

- La théorie du Big Bang en serait inchangée.