au sommaire

En 2013, presque un an après l'annonce par le Cern de la découverte du boson de Brout-Englert-Higgs, Lisa Randall, célèbre physicienne de Harvard, disait son inquiétude au magazine en ligne de la fondation Edge (une association d'intellectuels débattant de sujets dans les domaines scientifiques et technologiques). « Dans ma discipline, celle de la physique des particules, tout le monde est inquiet. Je ne parle pas à la légère. J'ai assisté à deux conférences la semaine dernière où son futur était l'un des principaux sujets de discussion et je suis dans une autre où la question sera également abordée ». Et la chercheuses d'ajouter : « Je suis préoccupée. Je suis angoissée à l'idée que je ne connaîtrai pas les réponses aux questions qui m'habitent profondément ».

Cette déclaration peut sembler incompréhensible pour le grand public après le succès de la découverte du boson de Brout-Englert-Higgs. Mais pour toute personne compétente en théorie quantique des champs et en physique des particules, elle n'est pas du tout surprenante.

Le cauchemar de la fin de la physique des particules

Le modèle standard s'est mis en place et a commencé à gagner ses lettres de noblesses entre, disons, 1967 et 1977, alors que la découverte des bosons W et Z restait à faire et que les premières théories de grande unificationthéories de grande unification, les GUT (acronyme de l'anglais Great Unified Theories) venaient d'être formulées. À ce moment-là, les théoriciens craignaient déjà qu'au-delà de la découverte des bosons du modèle électrofaible, et donc finalement du boson de Brout-Englert-Higgs, aucune technologie ne permettrait plus de progresser. Même un Fermitron, nom donné à un hypothétique accélérateur de la taille de la Terre, ne serait d'aucune utilité.

Il faudrait une machine de la taille de la Voie lactée... Les nouvelles particules de matièrematière et de force prédites par les GUT, ou éventuellement une théorie de gravitation quantiquegravitation quantique, ont en effet des massesmasses très élevées. On avait bien l'espoir de détecter quelques monopôles magnétiques, voire la désintégration des protons, mais pas grand-chose d'autre.

La physique menaçait d'être confrontée à « l'hypothèse du Grand DésertDésert ». Un cauchemar pour les physiciensphysiciens car les lois ultimes de la Nature, et donc les réponses potentielles à toutes les questions scientifiques et philosophiques allaient très probablement être pour toujours hors de portée de l'humanité, même d'une super IA, au moins sur le plan expérimental. Et comme la science n'existe pas en l'absence de données et de tests expérimentaux, nous aurions beau découvrir théoriquement certaines de ces réponses, nous ne pourrions les prendre vraiment au sérieux.

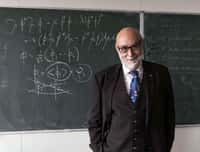

La physicienne Lisa Randall est professeur de physique théorique à l’université Harvard. Sportive, elle pratique la varappe. On lui doit des livres de vulgarisation, ainsi que le livret de l'opéra Hypermusic Prologue, A projective Opera in Seven Planes, en collaboration avec le compositeur Hèctor Parra. © Matthew J. Lee

La gueule de bois des physiciens

Par la suite, les théories supersymétriques et celles faisant intervenir des dimensions spatiales supplémentaires (celles de Kaluza-Klein et des supercordes) sont venues changer la donne, et encore plus, à la fin des années 1990 quand LisaLisa Randall et Raman Sundrum d'un côté et Nima Arkani-Hamed, Savas Dimopoulos, et Gia Dvali de l'autre, ont montré que la masse de PlanckPlanck fondamentale était peut-être plus petite qu'on ne le pensait. En fait, plusieurs problèmes rencontrés avec le modèle standard disparaissaient naturellement avec des combinaisons de théories supersymétriques ou de dimensions spatiales supplémentaires, lesquelles prévoyaient un extraordinaire zoo de nouvelles particules élémentairesparticules élémentaires visibles dans des collisions à des énergiesénergies de quelques TeV tout au plus. Le plus fascinant aurait été la mise en évidence de la production de minitrous noirs s'évaporant par effet Hawking.

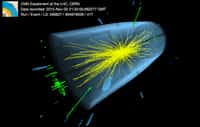

Mais la première campagne de prise de données par le LHCLHC n'a rien montré de tel et même la découverte du boson Brout-Englert-Higgs a rapidement montré des signes d'un comportement en tout point en accord avec le modèle standard, alors que l'on pouvait s'attendre à quelques différences, trahissant l'influence d'une nouvelle physique. Le cauchemar de l'hypothèse du désert a donc commencé à faire son retour. Et ce d'autant plus qu'aucune des expériences parties à la recherche de la matière noirematière noire, comme AMS, ou encore des GUT, dans le rayonnement fossilerayonnement fossile, comme Planck et Bicep II, n'ont pas non plus montré de signes d'une nouvelle physique.

Il faut donc prendre au sérieux le physicien Adam Falkowski lorsqu'il explique sur son célèbre blogblog que les physiciens des hautes énergies sont en train d'émerger d'une période d'euphorieeuphorie avec une gueule de boisbois. Pire, que finalement depuis quelques années, ils sont aux prises avec les fameuses cinq phases de deuil qu'a distinguées la psychiatre helvético-américaine, Elisabeth Kübler-RossRoss. Car le début de la seconde campagne de prises de données, avec un LHC toujours plus performant, des collisions à 13 TeV et une luminositéluminosité nominale déjà dépassée, ne fait toujours pas apparaître de nouvelles particules.

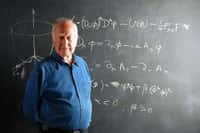

Julien Baglio présentant ses travaux sur le boson de Brout-Englert-Higgs lors de l’Hadron Collider Physics Symposium (HCP), à Kyoto, en novembre 2012. © HCP 2012 Local Organizing Committee

Un LHC plus performant que jamais

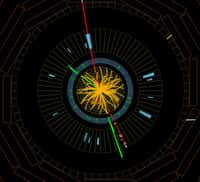

Et pourtant... En décembre 2015, un séminaire du Cern permettait aux membres des collaborations Atlas et CMS d'annoncer que les deux détecteurs géants du LHC commençaient à voir un signal pouvant indiquer un nouveau boson qui se désintégrerait en deux photonsphotons, avec la même masse de 750 GeVGeV. Il ne s'agissait pas encore d'une découverte mais on avait un peu l'impression de revivre les débuts de celle du boson de Brout-Englert-Higgs.

Pour nous éclairer sur la signification de ces mesures, Futura-Sciences avait interrogé le physicien Julien Baglio, qui nous avait parlé de ses recherches sur le boson de Brout-Englert-Higgs dans le cadre des théories supersymétriques. Il nous avait déjà mis en garde à l'époque, affirmant que cela méritait d'y regarder de plus près mais qu'il ne fallait pas s'emballer. Il était tout de même curieux qu'un même signal ait été observé dans deux détecteurs de conceptions différentes, ce qui rend moins probable un biais, une erreur systématique dans les mesures. Le chercheur nous avait donc conseillé d'attendre d'autres résultats de la seconde campagne de prise de donnée au LHC, et donc l'année 2016. Une date clé allait être l'International conference on high energy physics, ou Ichep, une biennale où se rassemblent aussi bien les théoriciens que les expérimentateurs. Elle se tient en ce moment à Chicago (États-Unis), du 3 au 10 août 2016.

Elle a permis d'annoncer officiellement que les signaux vus dans Atlas et CMSCMS n'étaient que des fluctuations statistiques, soit dit autrement une farce que nous a jouée le hasard. La nouvelle est d'autant plus décevante que la directrice générale du Cern, Fabiola Gianotti, a récemment déclaré dans un communiqué du Cern que « la superbe performance de l'accélérateur LHC, des expériences et de l'informatique est d'extrêmement bon augure pour une exploration détaillée et complète de l'échelle d'énergie de plusieurs TeV, et pour des progrès considérables de notre compréhension de la physique fondamentale ».

Il n'y a en effet pas de doute que les ingénieurs et les physiciens en charge des accélérateurs, des détecteurs, de la prise et de l'analyse des données ont fait un travail spectaculaire qui force le respect à tout point de vue, portant la machine à de nouveaux sommets. Le Cern précise d'ailleurs que les détecteurs Atlas, Alice, LHCb et CMS ont déjà enregistré environ cinq fois plus de données en 2016 qu'en 2015, après seulement quelques mois d'exploitation et que la luminosité nominale de faisceaux de protonsprotons, c'est-à-dire celle qui était initialement prévue pour le fonctionnement en régime de croisière du LHC, a été dépassée en juin. Ce qui veut dire que les objectifs prévus cette année seront atteints en avance.

La Grille de calcul mondiale, le réseau informatiqueréseau informatique connectant la puissance de calcul de plusieurs ordinateursordinateurs, a également largement battu ses précédents records en permettant de traiter 25 pétaoctets de données.

La plus grande surprise de la découverte du boson de Higgs ? Le fait qu'il n'y ait pas eu de surprises. Gian Francesco Giudice, dans cette conférence TEDxCern, en 2013, nous guide à travers un problème de physique théorique : et si le champ de Higgs existait dans un état ultradense qui pourrait signifier l'écroulement de toute matière atomique ? Avec charme et esprit, Giudice nous expose les grandes lignes d'un destin sinistre... Et pourquoi nous ne devrions pas nous en inquiéter tout de suite. © TED

Sommes-nous dans un multivers ?

L'exploration des territoires à hautes énergies et haute luminosité avec le nouveau LHC n'en est qu'à ses débuts. Il est tout de même inquiétant que pas le moindre petit signal d'une nouvelle physique, à défaut de preuve, ne pointe maintenant le bout de son neznez, alors que la machine n'a jamais été aussi performante, dépassant tous ses prédécesseurs.

La situation semble donner plus de poids à l'hypothèse du directeur de la division de physique théorique du Cern, Gian Francesco Giudice, présentée dans une conférence TEDx en 2013, envisageant l'existence d'un multivers. À nouveau, Futura-Sciences s'est tourné vers Julien Baglio pour savoir ce qu'il fallait en penser.

Dans sa conférence TEDx, Gian Francesco Giudice fait l'hypothèse que le modèle standard pourrait être valable jusqu'à des énergies très élevées. Bien qu'il ne le dise pas explicitement, on peut penser que c'est jusque vers 1012 ou 1016 TeV, donc bien au-delà de la dizaine de TeV accessible avec le LHC. Est-ce crédible ?

Julien Baglio : Malheureusement oui, la faible masse aujourd'hui mesurée du boson de Brout-Englert-Higgs (BEH) autorise les équationséquations du modèle standard à être valides, sans apparition de nouvelles particules, jusqu'à des énergies de l'ordre de celle de la gravitation quantique, c'est-à-dire 1016 TeV. Cela n'était pas évident avant la découverte de ce boson et on avait même de bonnes raisons de penser que ce n'était pas le cas.

Le vide quantique pourrait donc ne pas être dans son état de plus basse énergie ?

Julien Baglio : Absolument. Si l'on ne suppose pas l'intervention d'un nouvelle physique, on peut montrer maintenant que le vide quantique n'est pas instable, mais la précision des mesures des propriétés du boson de BEH et du quarkquark le plus lourd, le quark topquark top, autorise ce vide à être stable, ou au pire métastable. Dans ce dernier cas, comme l'expliquent Gian Francesco Giudice et d'autres physiciens, tels Giuseppe Degrassi, les caractéristiques de ce vide et donc finalement plusieurs caractéristiques des particules du modèle standard qui autorisent le développement de la vie pourraient changer mais très probablement pas avant un temps beaucoup, beaucoup plus long que l'âge de l'universunivers observable. La valeur de la masse du boson BEH semble être très curieusement réglée, mais peut-être pas plus que le fait que la Terre soit située à la bonne distance du SoleilSoleil pour permettre le développement de la vie.

N'est-ce pas là le vieux débat du principe anthropique, que plusieurs chercheurs résolvent en faisant intervenir la notion de multivers ?

Julien Baglio : En effet, ce curieux réglage de la masse du boson BEH pourrait indiquer (selon certains chercheurs car cela reste très spéculatif) qu'il existe un très grand nombre d'univers dans lesquels les constantes qui interviennent dans le modèle standard et qui n'ont toujours pas d'explication théorique, comme les masses des neutrinosneutrinos ou la valeur de la charge électrique, varient de façon aléatoire. Pas plus qu'il n'existe de mécanisme qui fixe le diamètre de l'orbiteorbite de la Terre autour du Soleil, il n'y aurait de théorie physique au-delà du modèle standard qui forcerait au moins certains de ses paramètres libres, comme la masse du boson BEH, à prendre une valeur déterminée.

En fait, depuis quelques années déjà, certains théoriciens laissaient entendre que l'on ne verrait pas de nouvelle physique au LHC à cause de considérations tirées des travaux sur la théorie des multivers venue de la théorie des cordesthéorie des cordes. Le fait que cette prédiction soit pour le moment couronnée de succès ne prouve rien, cependant, et elle laisse la physique dans une situation inconfortable.

Mais imaginons tout de même que cette nouvelle physique existe. Quelles sont maintenant les chances de la découvrir au LHC ?

Julien Baglio : C'est difficile à dire. D'un simple point de vue logique, tout reste encore possible à des énergies arbitraires, entre quelques TeV et 1016 TeV dans l'état actuel des connaissances. Mais nous n'avons plus d'arguments convaincants pour vraiment indiquer à quelle énergie de nouvelles particules pourraient émerger. Ceux qui laissaient penser que c'était très probablement vers quelques TeV n'ont pas conduit aux résultats escomptés. Ce qui nous laisse perplexe devant le « choix » qu'a fait la nature pour les lois de la physique.

Par rapport à ce que je vous disais l'année dernière au sujet des théories supersymétriques, la situation ne s'est pas arrangée, bien au contraire. Le modèle supersymétrique le plus simple, le MSSM dans sa version contrainte, est moribond. Si, dans quelques années, on ne trouve toujours pas de particules supersymétriques, certaines versions de la théorie à basse énergie seront encore en lice mais elles dépendront de valeurs de paramètres tellement particulières, nécessitant un réglage tellement fin que l'on n'aura finalement pas plus d'explications sur la vingtaine de paramètres libres du modèle standard. Une situation bien peu satisfaisante du point de vue du rasoir d'Occam.

Cependant, je reste optimiste devant les possibilités de découverte dans la physique des neutrinos, bien que peut-être pas en premier au LHC. Nous ne savons toujours pas quelle est leur nature réelle, de Majorana ou de Dirac ? Comment expliquer de façon satisfaisante leur masse, sachant que le mécanisme de Brout-Englert-Higgs, qui est possible pour les autres particules du modèle standard, est plus difficile à mettre en œuvre de façon satisfaisante pour les neutrinos ? Et même au LHC, nous ne sommes pas à l'abri de surprises, cette fois positives !

Que penser du « flop » du nouveau boson, suspecté et finalement inexistant ?

Julien Baglio : Je suis complètement d'accord avec les analyses d'Adam Falkowski à ce sujet. On ne peut rien reprocher aux travaux des expérimentateurs, au contraire ! Et en fait, ils avaient mis en garde les théoriciens depuis un moment. Déjà, aux Rencontres de Moriond, en mars 2016, les progrès dans l'analyse des données collectées faisaient, selon moi, encore plus sérieusement pencher la balance en faveur de simples fluctuations statistiques dans les données.

Avant, les théoriciens avaient de bonnes raisons de prendre les signaux détectés au sérieux et on peut comprendre leur impatience à exorciser le cauchemar de l'hypothèse du désert. Mais après Moriond, ils auraient dû se modérer fortement alors que près de 400 articles ont été publiés. Même si un certain nombre avaient une réelle valeur ajoutée scientifiquement parlant, beaucoup étaient finalement assez artificiels.

Sociologiquement, il semble probable que certains ont cédé à la tentation de faire grimper leur nombre de publications et de citations, sous la pressionpression de plus en plus grande de la part des organismes financeurs. Malheureusement, la science en pâtit.