au sommaire

À l'horizon de la fin du siècle, les projections du Giec dépendent évidemment de la consommation des combustiblescombustibles fossiles mais, selon les scénarios, la hausse des températures la plus probable se situerait entre 1,8 et 4 °C par rapport à la moyenne des températures de 1980 à 1999. C'est ce qu'indique le quatrième rapport du Giec (AR4, Assessment Report 4). Le bas de la fourchette inférieure correspond à des émissionsémissions cumulées de 800 gigatonnes d'équivalent-carbonecarbone (GtC) (soit 2.900 Gt de CO2) de 1990 à 2100, le haut de la fourchette à plus de 2.500 GtC.

Il est tout à fait possible que le choix entre ces scénarios soit imposé par les réserves disponibles mais en tout cas, depuis 1990, le total de ces émissions est de 150 GtC et les émissions croissent de 2,5 % tous les ans à l'exception de 2009, quand se sont fait sentir les effets de la crise économique. À ces incertitudes directement liées à l'activité humaine, il faut ajouter celles d'ordre scientifique, ce qui élargit la fourchette entre 1,1 et 6,5°C.

L'une des conséquences du réchauffement est la hausse du niveau de la mer. Elle a essentiellement deux causes majeures : la fontefonte des glaciers (glaciers de montagne et calottes glaciairescalottes glaciaires) et la dilatationdilatation thermique des océans. Toujours selon l'AR4, la hausse serait comprise entre 20 et 60 centimètres selon les scénarios et les modèles. Récemment pourtant, plusieurs articles (Rahmstorf 2007, Vermeer et Rahmstorf, 2009) font état de hausses très nettement supérieures : entre 0,75 et 1,90 mètre.

Une hausse du niveau des mers de 5 mètres ?

Hansen et Sato (en cours de publication) évoquent, eux, une hausse qui pourrait atteindre jusqu'à 5 mètres dans le cas où les émissions continueraient sur leur lancée (BAU : Business As Usual). Bien évidemment, les conséquences d'une hausse de plusieurs mètres du niveau des océans seraient considérables.

Une très grande partie du Bangladesh serait sous l'eau et des villes comme Shanghai ou New York seraient menacées voire complètement sous l'eau. On trouve sur InternetInternet de nombreux sites qui permettent de visualiser sur carte les zones inondables pour un niveau de hausse du niveau moyen donné, comme sur geology.com. Mais pour qu'une région demeure habitable, ce qui compte, ce n'est pas le niveau moyen mais le niveau maximum atteint lors des grandes tempêtes, ce serait donc encore plus grave.

Pourquoi de telles différences ?

La différence tient en deux mots : non-linéarités ou encore « effets de seuil ». Les projections de l'AR4 excluent les changements brusques du régime de fonte des calottes glaciaires, la seule raison en est qu'on ne disposait pas d'assez d'informations sur ces processus. En gros, pour les modèles de l'AR4, les calottes glaciaires sont de simples glaçons qui fondent tout doucement. La réalité est tout autre : sous certaines conditions, les calottes se disloquent au moins partiellement et déchargent alors dans l'océan des quantités de glace très importantes. Le processus est évidemment beaucoup plus rapide que la simple fonte. La diminution rapide de l'albédo qui en résulte amplifie encore le mécanisme. On commence maintenant à évaluer l'ampleur et la vitessevitesse de ces changements brusques.

La calotte la plus fragile est celle de l'AntarctiqueAntarctique Ouest. Elle a déjà connu des effondrementseffondrements partiels, le plus récent d'entre eux datant de 400.000 ans. On s'accorde en général sur 5 à 6 mètres de hausse du niveau des océans si cet inlandsis venait à s'effondrer. Des travaux récents revoient ce chiffre à la baisse - un peu plus de 3 mètres quand même - mais avec des disparités géographiques importantes.

On qualifie la calotte occidentale Antarctique de calotte marine parce qu'elle est posée sur un socle rocheux dont de nombreux secteurs sont situés sous le niveau de la mer. La nappe de glace recouvrant ce socle s'écoule vers l'océan et se prolonge sur la mer par des plateformes de glace flottantes, lesquelles assurent sa stabilité en jouant le rôle d'arc-boutant. Quand les plateformes se disloquent, les glaciers qu'elles retenaient glissent alors beaucoup plus rapidement et leur front se disloquent à leur tour.

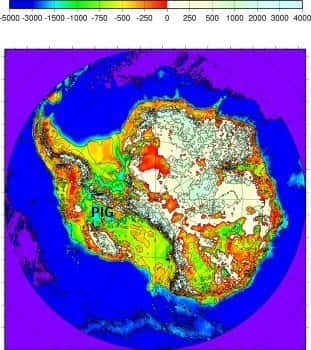

Le glacier de Pine Island (reporté approximativement sur la figure 1) fournit une illustration de ce type de processus. Des observations en sous-marin autonome ont montré que sa plateforme terminale reposait initialement sur une élévation sous-marine de près de 300 mètres de haut. La plateforme en est maintenant détachée, ce qui permet à l'eau plus chaude de saper la base du glacier dont l'écoulement s'est accéléré de façon quasi-continue depuis une dizaine d'années.

Figure 1 : Carte de l’altitude du socle antarctique. Les couleurs ont été choisies pour mettre l’accent sur la partie au-dessous du niveau de la mer. Le glacier de Pine Island (PIG, Pine Island Glacier) est le plus productif des glaciers de l'inlandsis antarctique. © CNRS Photothèque FRE2192 - LGGE - Saint-Martin d'Hères

Quel est le risque à court terme ?

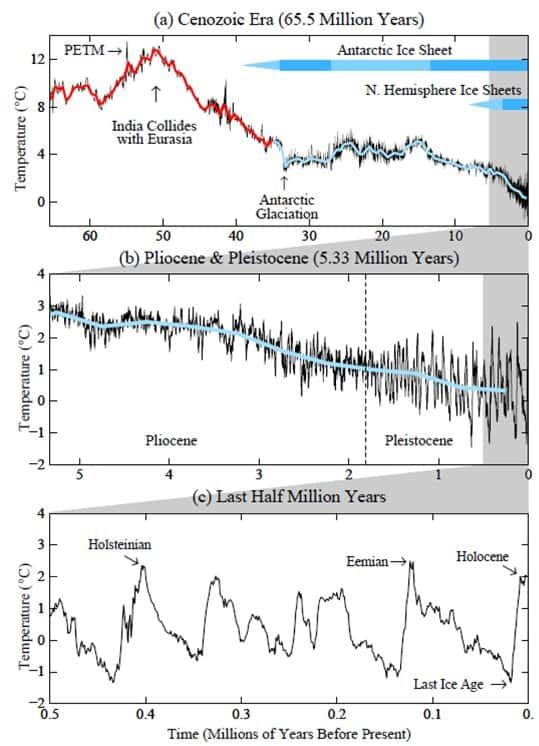

La paléoclimatologie permet d'en savoir un peu plus. On sait que depuis que l'Inde s'est soudée à l'Eurasie, il y a 50 millions d'années, la température de la planète s'est abaissée d'environ 10°C et la concentration atmosphérique en CO2 est passée de 1.100 ppmppm environ à moins de 200 ppm lors des périodes les plus froides. Au cours du PléistocènePléistocène (les deux derniers millions d'années), le climatclimat a oscillé entre de courtes périodes chaudes et des périodes froides beaucoup plus longues avec une périodicité commandée par les fluctuations de l'orbiteorbite de la TerreTerre autour du SoleilSoleil et de l'inclinaison de son axe (ce sont les cycles de Milankovic). L'analyse isotopique des sédimentssédiments marins et celle des carottes de glacecarottes de glace en Antarctique et au Groenland permet d'évaluer l'amplitude des variations correspondantes de la température moyenne de la planète à 5 +/-1 °C.

En parallèle la concentration en CO2 varie entre 180 et 300 ppm et le volumevolume et l'étendue des surfaces glacées varient fortement ainsi que la végétation, ce qui se traduit par des variations de l'albédo de la planète. Variations de la concentration atmosphérique en CO2 et des autres gaz à effet de serregaz à effet de serre tels le méthane (CH4) et le dioxyde d'azoteazote (N2O) et variation de l'albédo constituent les deux forçages globaux, eux-mêmes initiés par les changements de la distribution de l'éclairement solaire. Le forçage des GES peut être estimé assez précisément (3 +/- 0,5 W/m2). L'évaluation de celui de l'albédo, en revanche, est plus délicate. Dans leur article, Hansen et Sato, l'estiment à 3,5 +/- 1 W/m2. On en déduit que si le climat se comportait de façon linéaire, sa sensibilité serait d'environ trois quarts de degré par W/m2. C'est la valeur autour de laquelle tournent les différentes estimations depuis un demi-siècle.

Rétroactions positives

Cependant, la réponse du climat aux forçages n'est très certainement pas linéaire. La valeur de trois quarts de degré par W/m2 n'est donc qu'une première approximation assez grossière, valable seulement pour des conditions proches des conditions actuelles. Qu'en sera-t-il si, comme selon toute probabilité, le réchauffement actuel se poursuit ?

Ici, le forçage est dû à l'augmentation des GES, les variations de l'albédo sont la conséquence du réchauffement qui en résulte et constituent des rétroactions positivesrétroactions positives. Dans un premier temps, il est vraisemblable que le réchauffement amplifie cette rétroaction : disparition de la banquisebanquise arctiquearctique, fonte en surface des glaciers et calottes, diminution des surfaces enneigées (les variations de la surface enneigée en hiverhiver quand l'éclairement est faible ont beaucoup moins d'importance que celles qui se produisent lorsque l'éclairement est important). La sensibilité climatique doit donc être temporairement plus élevée.

Les périodes les plus chaudes du passé sont particulièrement intéressantes. L'analyse isotopique des sédiments marins et celle des carottes de glace montrent que depuis 500.000 ans, la planète n'a été plus chaude qu'actuellement que brièvement, au cours de deux périodes interglaciaires (Holsteinian à -400.000 ans et Eémien à -120.000 ans, voir la figure 2). À ces époques, le Groenland était sans doute environ 5°C plus chaud mais en moyenne planétaire, la différence était beaucoup plus faible. À ces époques, le niveau de la mer était pourtant plus élevé de 5 mètres, peut-être plus.

Figure 2 : Variations de la température de l’océan profond (en moyenne globale) au cours du Cénozoïque (a). La température est estimée à partir de l’analyse isotopique des sédiments marins. Les courbes b et c, agrandies, montrent les variations pour les périodes plus récentes. Ces courbes sont issues de Hansen et Sato, d’après des données originales de Zachos et al., 2001.

La période la plus chaude depuis la dernière glaciationglaciation (c'est-à-dire au cours de l'HolocèneHolocène) se situe il y a 8.000 ans. Depuis, la température a légèrement diminué en réponse au forçage orbital mais cette diminution a été faible et plus ou moins compensée par le réchauffement de ces 150 dernières années. Dans ces conditions, Hansen et Sato concluent que la température présente n'a sans doute jamais été dépassée de beaucoup plus de 1°C au cours des épisodes les plus chauds de ce dernier demi-million d'années et ceci bien que le niveau de la mer y ait été de plus de 5 mètres supérieur au niveau présent.

Mis à part pour les scénarios les moins gourmands, le réchauffement prévisible dépasse largement 1°C. Selon Hansen et Sato, nous sommes donc très près de conditions qui pourraient provoquer une hausse du niveau de la mer de plusieurs mètres. Dans les milieux climatosceptiques, on accuse souvent James Hansen de catastrophisme, il a au moins le mérite d'aborder des questions qui dérangent peut-être mais qui n'en sont pas moins très importantes. Le pire n'est évidemment pas certain et la question est loin d'être réglée. Le problème est que si l'on attend les certitudes, il sera trop tard même pour tout simplement s'adapter en minimisant les dégâts.