Une nouvelle étude prépubliée au sujet de la chloroquine fait parler d'elle sur les réseaux sociaux. Pourtant, elle donne à voir une méthodologie assez douteuse, parsemée d'erreurs ou de manipulations de données qui invalident complètement ses résultats.

au sommaire

La polémique autour de l'hydroxychloroquine (HCQ) et de l'azitrhomycine (AZI) n'en finit plus. Nous le rappelons, aucun traitement n'a fait ses preuves conformément aux standards actuels de l'évaluation d'une thérapeutique contre la Covid-19. Que ce soit le Remdesivir, le tocilizumab ou l'hydroxychloroquine, on ne sait pas si la balance bénéfices/risques de ces traitements est positive dans cette indication précise qui guérit spontanément dans 95 % des cas. Et dans l'urgence, mieux vaut ne pas se précipiter. Nous attendons toujours la publication de l'essai américain sur le Remdesivir qui viendra s'ajouter à l'essai chinois négatif, publié dans The Lancet. Sur le tocilizumab, l'annonce de l'AP-HPHP s'est retrouvée être un véritable fiasco : il s'ensuivit plusieurs démissions selon le Canard enchaîné. Concernant l'HCQ et l'AZI, le scandale continue, avec une nouvelle étude à la méthodologie plus que douteuse, réalisée par une équipe française dont un défenseur de la chloroquine : le Professeur Perronne.

Nous prenons le temps de faire ce bref point concernant toutes ces thérapeutiques pour faire preuve de transparencetransparence. Nous ne soutenons aucune thérapeutique sur la base d'intérêts ou d'influences quelconque. Nous critiquons plus souvent la chloroquine conformément à l'engouement qu'elle suscite dans le débat public. Nos autres articles moins nombreux reflètent tout autant le manque de données concernant les autres thérapeutiques. C'est notre rôle d'informateurs scientifiques que de contrebalancer un engouement supporté par des données aussi peu fiables. Ce que nous essayons de dire, c'est que, si demain, les mêmes équipes publient des études rigoureuses sur le plan méthodologique avec des résultats probants, nous serons heureux d'écrire un article intitulé : « Chloroquine : un traitement à la balance bénéfices/risques positive qui donne de bons résultats contre la covid-19 ». Après cette petite mise au point nécessaire, passons au décryptage de l'étude dont il est question.

Un cas d'école pour savoir ce qu'il ne faut pas faire

Il serait illusoire de dire que nous avons regardé toutes les études prépubliées concernant la chloroquine. Il y en a beaucoup trop. Nous avons choisi celle-ci car elle a fait beaucoup de bruit sur les réseaux sociauxréseaux sociaux. Ceci est très dommageable car ce genre d'étude prépubliée ne devrait pas servir à la communication auprès du grand public. Aussi, comme nous le disions, elle a été dirigée par un défenseur de la chloroquine. On s'attendrait donc, pour des personnes qui défendent une thérapeutique, qu'ils mènent une étude solidesolide pour convaincre l'ensemble de la communauté scientifique. Malheureusement, ce n'est pas le cas.

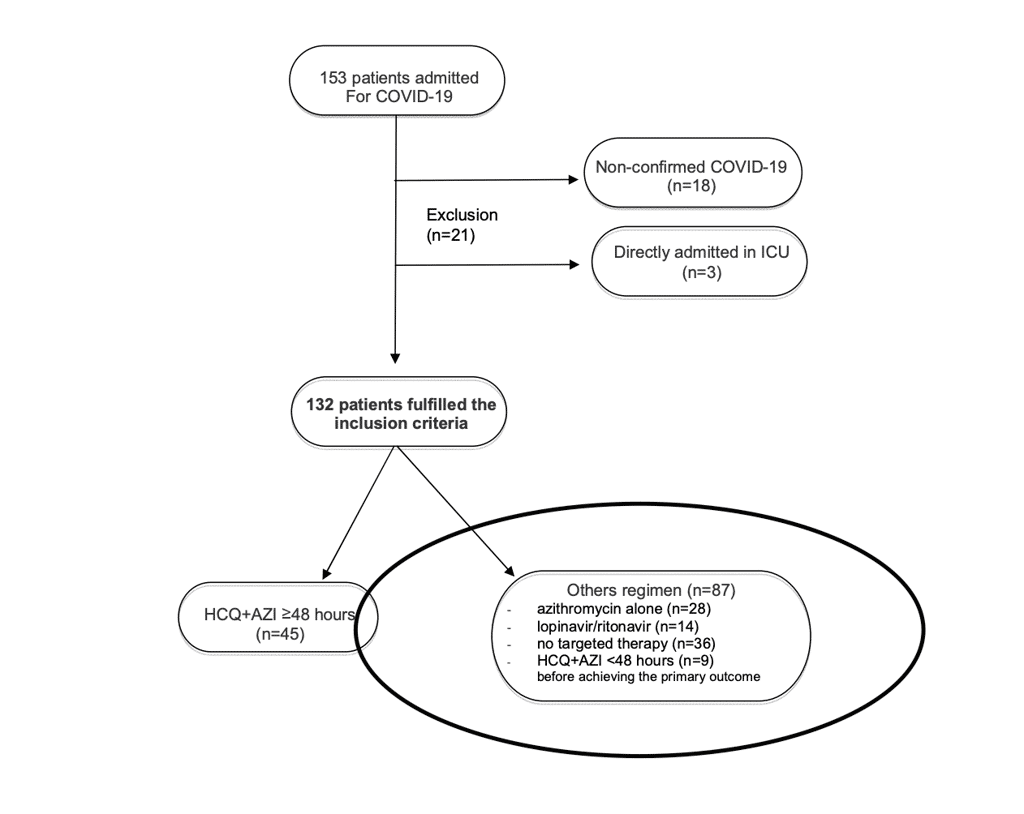

L'article s'intitule : « HydroxychloroquineHydroxychloroquine plus azithromycine : un intérêt potentiel pour réduire la morbidité hospitalière due à la pneumonie Covid-19 (HI-ZY-COVID) ? ». C'est une étude monocentrique (réalisée sur un seul site hospitalier), présentée comme rétrospective (on analyse des données qui sont déjà disponibles) portant sur un échantillon de 132 patients. Voici les questions qu'on se pose, et que nous avons posé à l'auteur principal de l'étude, lorsqu'on lit ce papier :

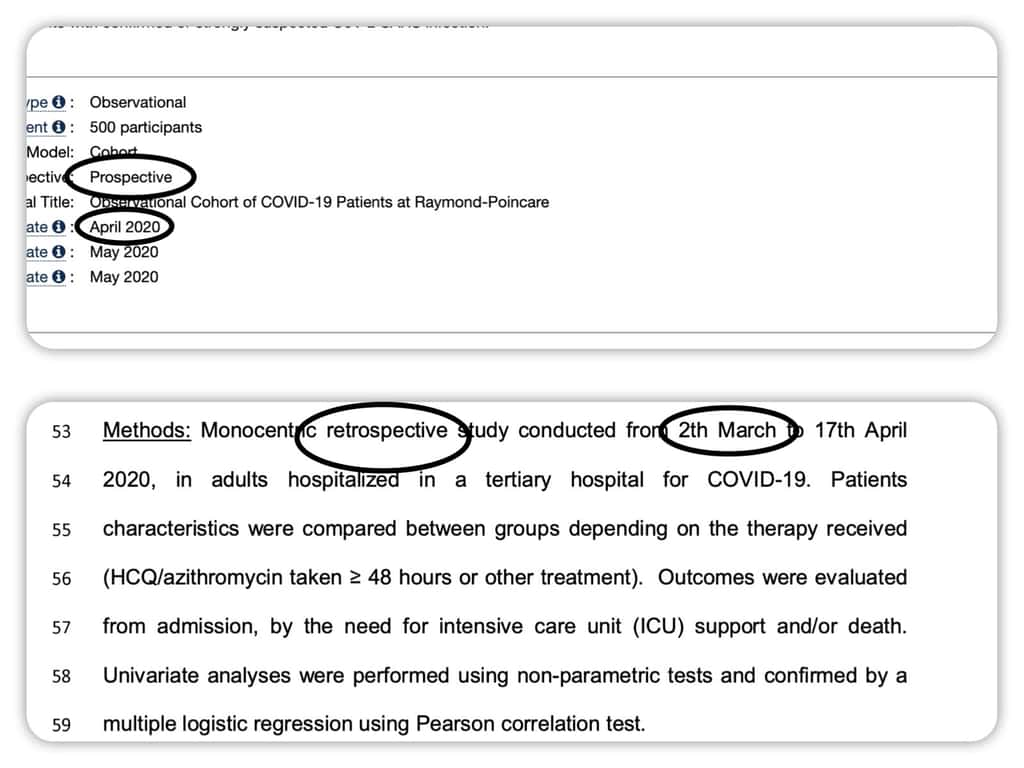

Pourquoi avoir mis « étude prospective » (on regarde ce qui se passe) dans le dépôt d'essai clinique puis transformé cela en rétrospectif (on regarde ce qui s'est passé) ? Et pourquoi avoir enregistré l'essai clinique fin avril alors que le recrutement a commencé début mars ?

On peut constater que dans l'enregistrement de l'étude, les auteurs ont d'abord qualifié leur expérience de prospective. Cela est donc étrange de la présenter en étude rétrospective pour la publication. Surtout que le traitement conféré suggère qu'il s'agit d'une utilisation non conforme à celle autorisée actuellement de l'HCQ dans le cadre de la Covid-19. Il semble donc que nous ayons affaire à une étude d'intervention. La deuxième du genre à se faire passer pour une étude d'observation. Aussi, le fait que les chercheurs aient commencé leur recrutement presque deux mois avant d'enregistrer l'essai clinique constitue une faute grave. Eh oui, on peut donc adapter son protocoleprotocole à sa guise lorsqu'on fait ce genre de chose. On n'oubliera également pas le fait que le comité d'éthique ayant validé l'étude soit le comité d'éthique local. Question indépendance, on peut mieux faire. Pour toutes ces raisons, nous soulevons une question : que fait l'Agence nationale de la sécurité du médicament (ANSM) pour cette étude mais également pour celle du Professeur Raoult, plus ancienne, portant sur 80 patients ?

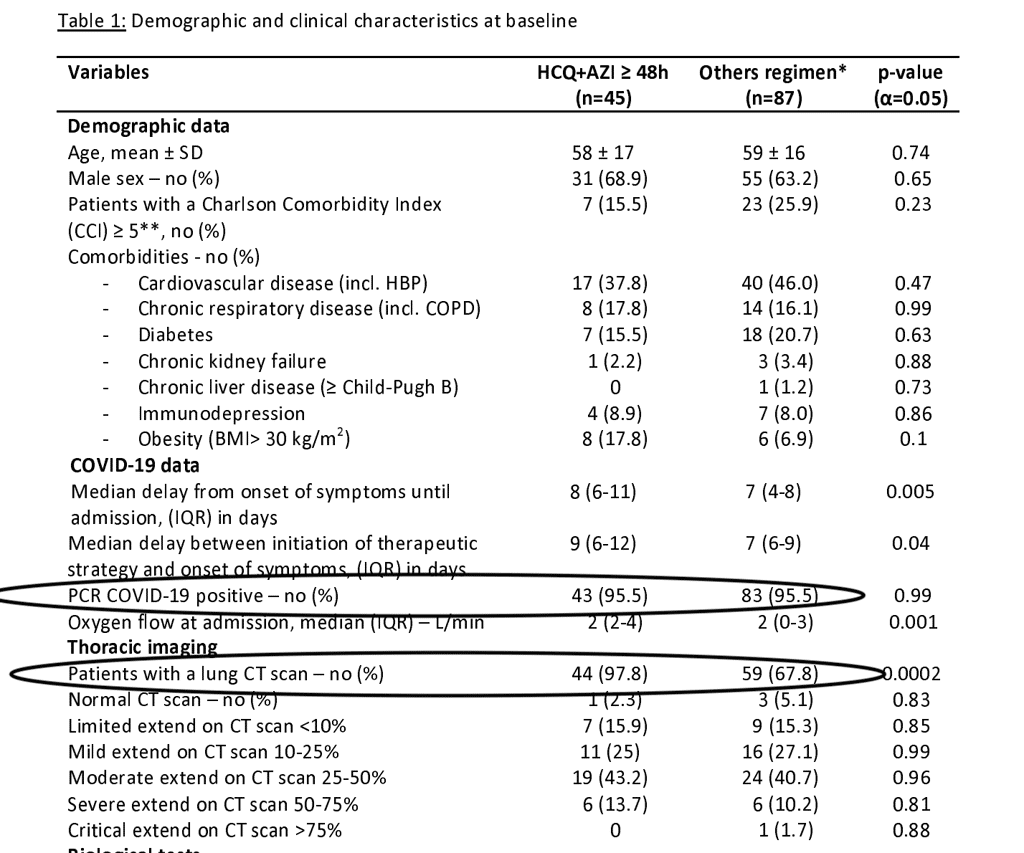

Pourquoi trouve-t-on six patients testés négatifs au SARS-CoV-2 dans l'étude et seulement 60 % de scannerscanner des poumonspoumons dans le groupe contrôle alors même que vos critères d'inclusions sont soit un test positif, soit un scanner des poumons très évocateur ? Tous les patients de votre étude souffraient-ils de la Covid-19 ?

Les critères d'inclusions sont des caractéristiques que définissent les chercheurs en amont d'une expérience pour pouvoir trier les patients qu'ils acceptent ou non dans leur étude. Ici, on constate que six patients négatifs au test PCRtest PCR ont été inclus dans l'étude. Seulement 60 % du groupe contrôle a passé un scanner pulmonaire. On peut donc avoir un doute concernant le fait que tous les patients étaient bien atteints de la Covid.

Pourquoi avoir fait un groupe contrôle « fourre-tout » où on retrouve des patients traités au lopinavir/ritonavir, sous azitrhomicine seule, sous hydroxychloroquine (HCQ) + azitrhomicine (AZI) mais moins de quarante-huit heures ?

Ce groupe contrôle est un mystère. On ne comprend vraiment pas pourquoi les groupes n'ont pas été séparés ou mieux homogénéisés. En l'absence de réponse, nous ne nous l'expliquons pas.

Pourquoi avoir retiré neuf patients du groupe HCQ + AZI sous prétexte qu'ils ont reçu le traitement moins de deux jours ? Pourquoi les avoir basculés dans le groupe contrôle alors même qu'ils ont été transférés en unité de soins intensifs ou sont décédés ?

Ici, c'est inquiétant. On assiste au mieux à une grosse erreur méthodologique, au pire à de la manipulation de données. En effet, des patients qui migrent comme cela d'un groupe à l'autre faussent forcément toute l'analyse statistique de l'étude.

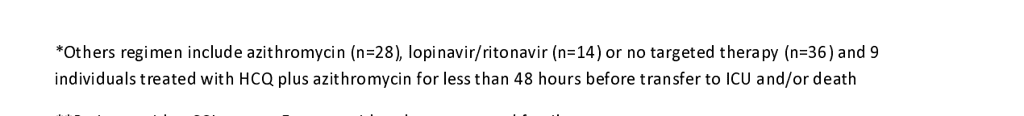

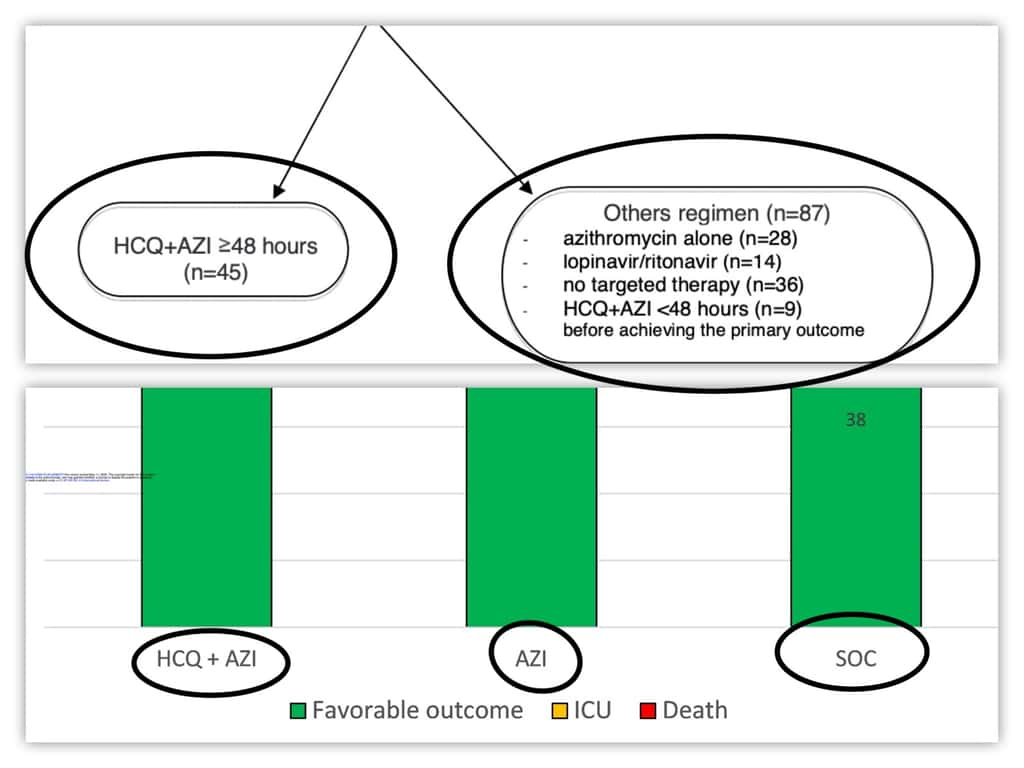

Pourquoi avoir scindé les deux groupes initiaux en trois groupes ?

Là encore, c'est inquiétant. Cela s'appelle du changement de design ad hoc. C'est-à-dire qu'on peut supposer que les chercheurs n'ont pas trouvé les résultats qui leur convenaient avec seulement deux groupes et qu'ils ont donc décidé de scinder le tout en trois groupes pour que l'effet qu'ils attendaient soit constaté statistiquement. C'est une attitude qu'on peut qualifier d'anti-scientifique. Par-dessus le tout, on peut remarquer, grâce à ce tour de passe-passe, l'absence de différence entre AZI seule et HCQ + AZI. Pour l'utilité de l'HCQ dans cette étude, on peut faire mieux également.

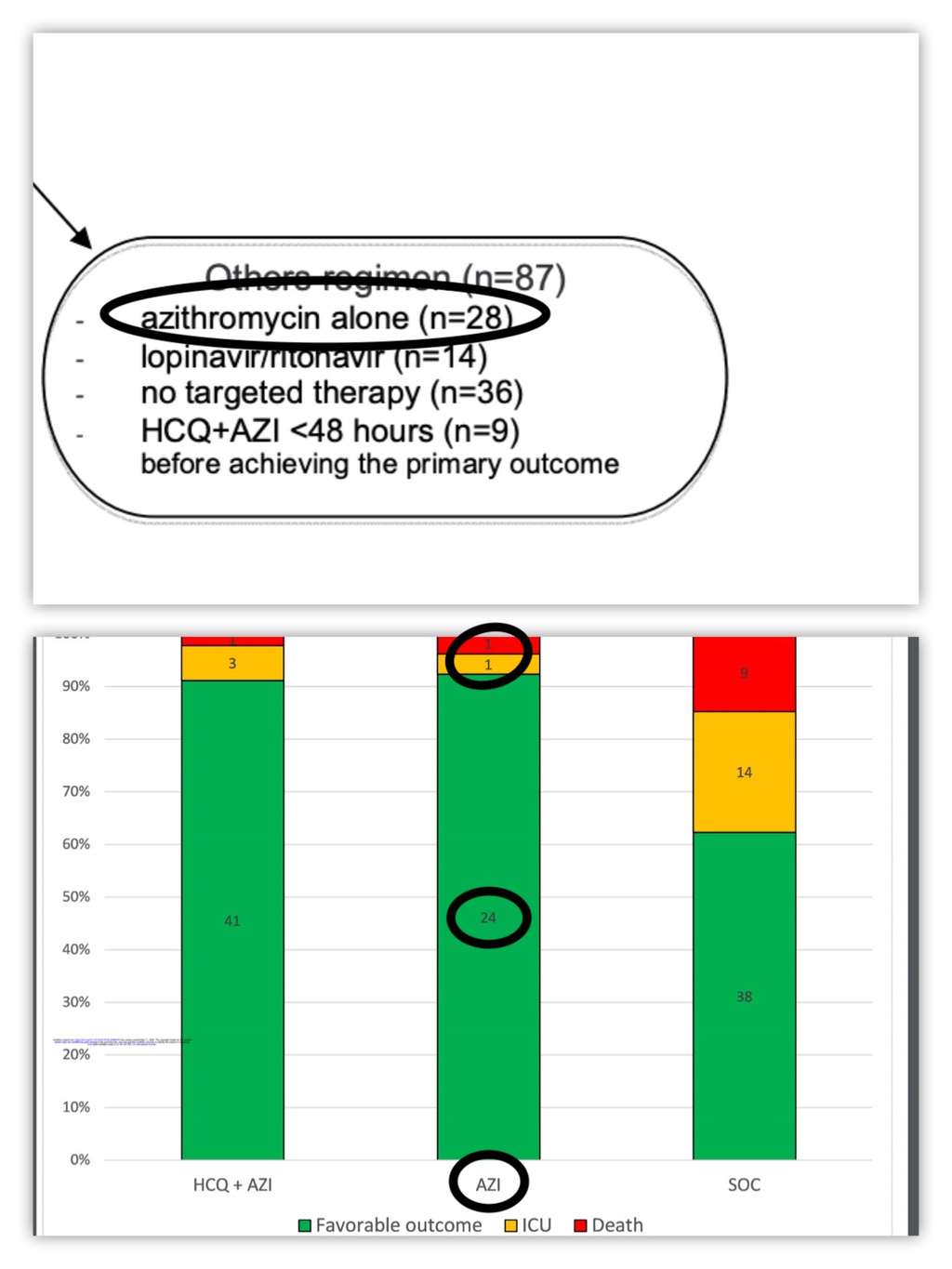

Pourquoi avoir fait migrer deux patients AZI dans le groupe contrôle après obtention de vos résultats ?

Ce troisième groupe créé a posteriori, c'est le groupe AZI dont les patients ont été retirés du groupe contrôle. Dans les deux groupes initiaux on constate que 28 patients sont sous AZI. Dans le groupe AZI retiré du groupe contrôle présent dans le tableau des résultats, on ne trouve que 26 patients. Lorsqu'on fait le calcul, on se rend compte que ces deux patients sont restés dans le groupe contrôle. Pourquoi ? Sont-ils allés en soin intensifs ? Sont-ils décédés ? Vont-ils bien ?

Pourquoi ne pas avoir utilisé un modèle de Cox qui permet d'incorporer l'aspect temporel des événements, ce qui est essentiel dans ce genre d'étude ?

L'utilisation d'un modèle de Cox est primordiale dans ce genre d'étude. Sans rentrer dans les détails, il s'agit d'un modèle mathématique permettant de pallier le décalage qui peut exister dans la survenue des événements entre patients et qui fausse l'analyse finale. Ici, typiquement, le moment de l'admission en soins intensifs, la mort ou la guérisonguérison du patient. Sans ça, l'étude souffre d'un gros problème méthodologique en plus de ceux cités précédemment.

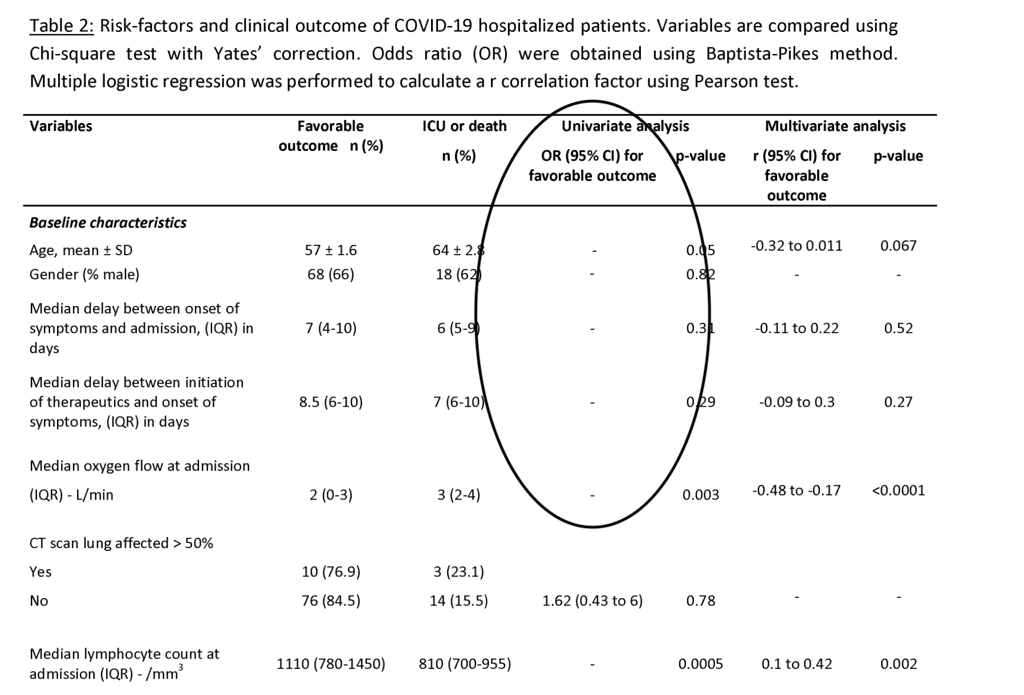

Pourquoi ne pas calculer les rapports de chances (odds ratio)) ajustés dans votre analyse multivariée (à plusieurs variables) à la place d'un facteur de corrélation dont on ne sait pas à quoi il correspond ? Surtout que vous les avez en partie calculés dans votre analyse univariée (à une seule variable).

Un odds ratio est un calcul qui mesure les rapports de chances entre deux groupes exposés ou non exposés à une ou plusieurs variables. Il permet en cela de comparer deux groupes sur une ou plusieurs variables données là où le facteur de corrélation ne fait que tisser un lien entre deux variables numériquesnumériques uniques et non pas entre groupe exposé/non exposé. Or, ce qui nous intéresse dans ce genre d'étude, c'est bien la différence entre les groupes de malades exposés ou non exposés à une thérapeutique.

Pourquoi ne pas avoir calculé les rapports de chances (odds ratio) pour vos variables numériques ?

On constate curieusement que les rapports de chances n'ont pas été calculés pour des variables numériques telles que l'âge. Pourtant, on connaît l'importance du facteur âge dans la maladie. Il aurait été bon de disposer de ce résultat pour savoir le poids que pesait (la taille d'effet serait plus juste en statistiques) chaque variable dans l'issue favorable ou non du patient.

Comment pouvez-vous conclure à « l'intérêt potentiel de la thérapie combinéethérapie combinée de HCQ/AZI (48 heures de prise au moins) pour limiter le taux de transfert en soins intensifs » alors même qu'en refaisant vos calculs avec les deux groupes décrits initialement sans basculer les neuf patients HCQ + AZI dans le groupe contrôle, on ne constate aucune différence ?

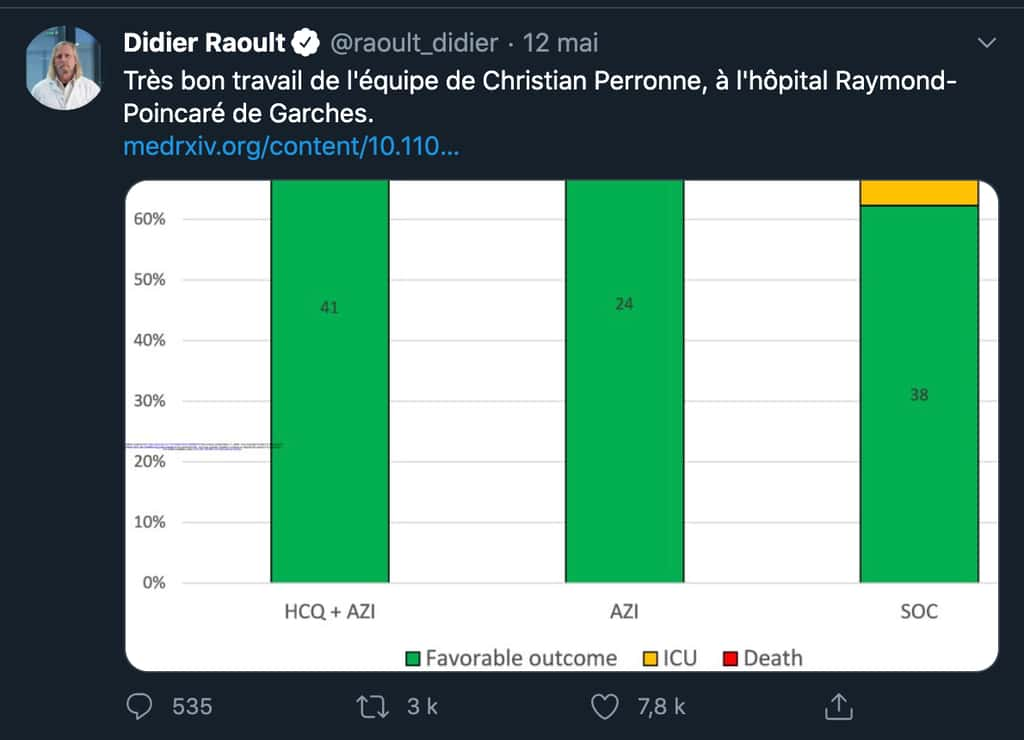

Nous l'avons vu, avec de tels biais, cette étude ne peut pas proposer cette conclusion. Nous n'aurions pas fait d'article si elle n'avait pas été partagée en massemasse sur les réseaux avec plus de 7.800 likes et 3.000 retweets sous un tweet du Professeur Raoult. À cause de ce partage massif et compte tenu de la potentielle manipulation de l'opinion publique que cela constitue, la rédaction de cet article nous a semblé nécessaire.

Un fiasco annoncé

Voici la réponse que nous avons reçue de l'auteur principal de l'étude : « Bonjour, l'article a été soumis à comité de lecture pour évaluation. Pas de commentaire. » Pourtant, tous les scientifiques que nous avons interrogés sont unanimes : ce papier ne passera jamais un processus de relecture par les pairs sérieux.

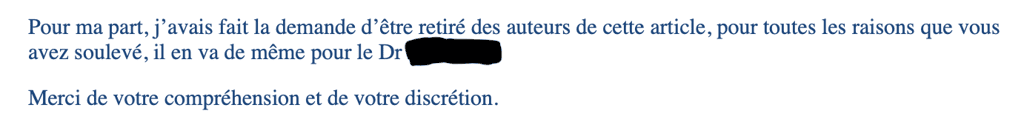

Cet article ne semble pas digne d'une attitude scientifique. En le lisant, nous avons vraiment l'impression que les données ont été manipulées pour coller avec la conclusion, mais nous ne pouvons l'affirmer clairement sans plus d'informations de la part des auteurs. Mais si ce n'était que cela. Voilà pourquoi cette étude pose question : plusieurs auteurs de l'étude contactés par Futura et souhaitant rester anonyme ont clairement affirmé leur volonté de voir leur nom retiré dudit article. Ce genre de chose n'est vraiment pas bon signe concernant la qualité d'une étude.

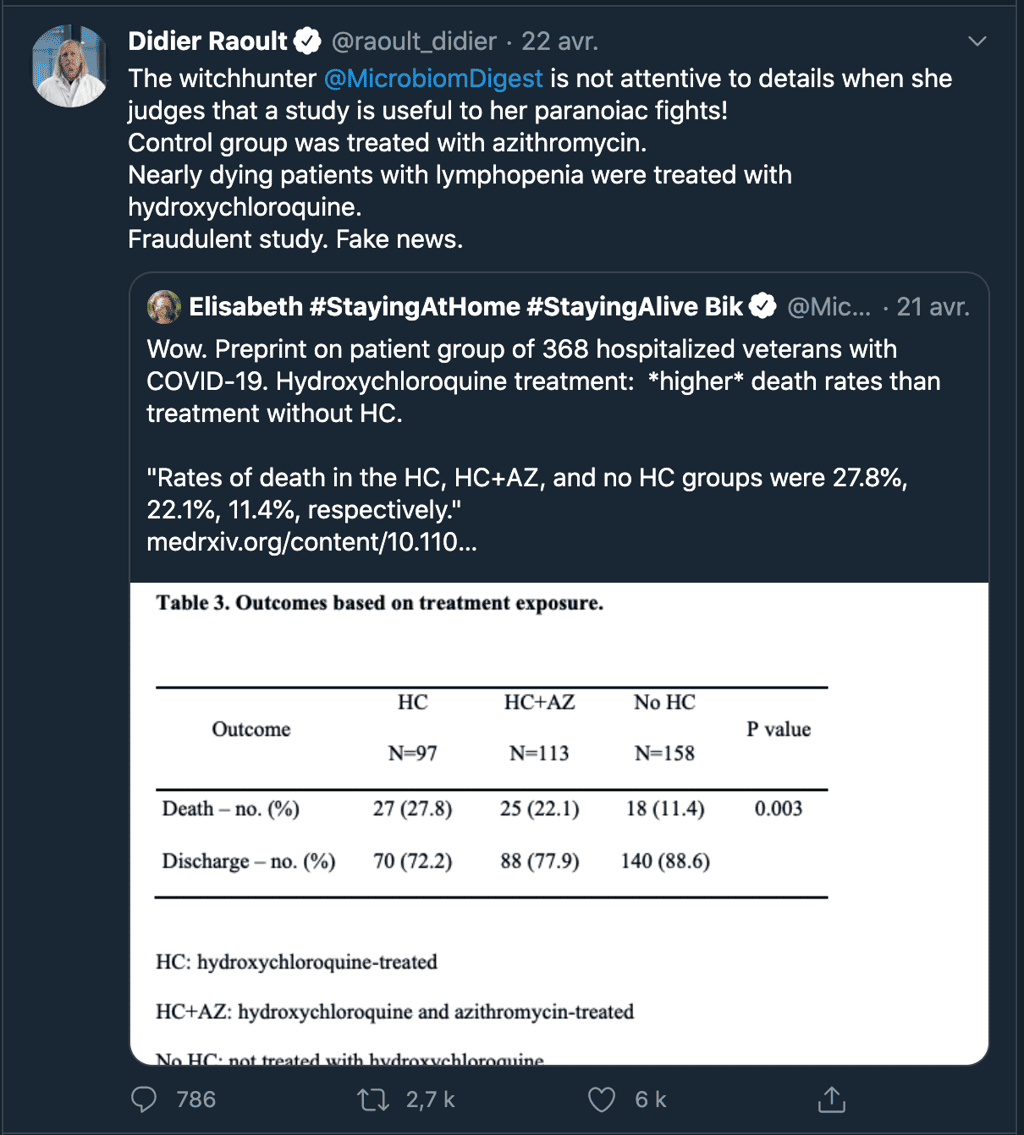

Pourtant, celui qui a popularisé ce protocole, le Professeur Raoult, salue sur son compte TwitterTwitter comme on peut le voir ci-dessus « le très bon travail de l'équipe du Professeur Perronne ». Quelques semaines auparavant, il désignait une de ses pairs comme étant « une chasseuse de sorcières » pour avoir osé partager une étude d'observation prépubliée qui comportait des biais.

Cette étude, aussi biaisée soit-elle, avait pourtant l'honnêteté de posséder une conclusion en adéquation avec la faiblesse de ses résultats en énonçant qu'il fallait attendre les essais cliniques randomisés. Cette étude comportait des biais et il fallait les relever, ce qu'a fait le Professeur Raoult. Pourquoi ne fait-il pas de même avec cet article ? Nous avons essayé de le solliciter hier après-midi sans succès. S'il nous répond après publication, nous veillerons à mettre l'article à jour. En attendant, lorsque la chasse aux sorcières ne semble prendre qu'une direction, cela ressemble à du dogmatisme.

Ce qu’il faut

retenir

- Une nouvelle étude à la méthodologie douteuse publiée au sujet de ce qu'on appelle désormais le « protocole marseillais » dans le cadre de la Covid-19 vient d'être mise en ligne sur un serveur de prépublication et a été partagée massivement.

- L'étude est truffée d'énormes biais méthodologiques et de potentielles manipulations de données. L'auteur principal de cette étude n'a pas souhaité répondre à nos questions.

- Le Professeur Raoult souligne pourtant sur son compte Twitter le « très bon travail de l'équipe du Pr Perronne ». C'est très étonnant étant donné la piètre qualité de cette étude.