Reconnaître une mélodie ou comprendre une phrase n'active pas les mêmes zones du cerveau, les deux hémisphères ne sont pas mobilisés de la même façon, ce que les chercheurs savaient déjà. Cependant, cette spécialisation asymétrique n'était pas expliquée au niveau physiologique et neuronal.

au sommaire

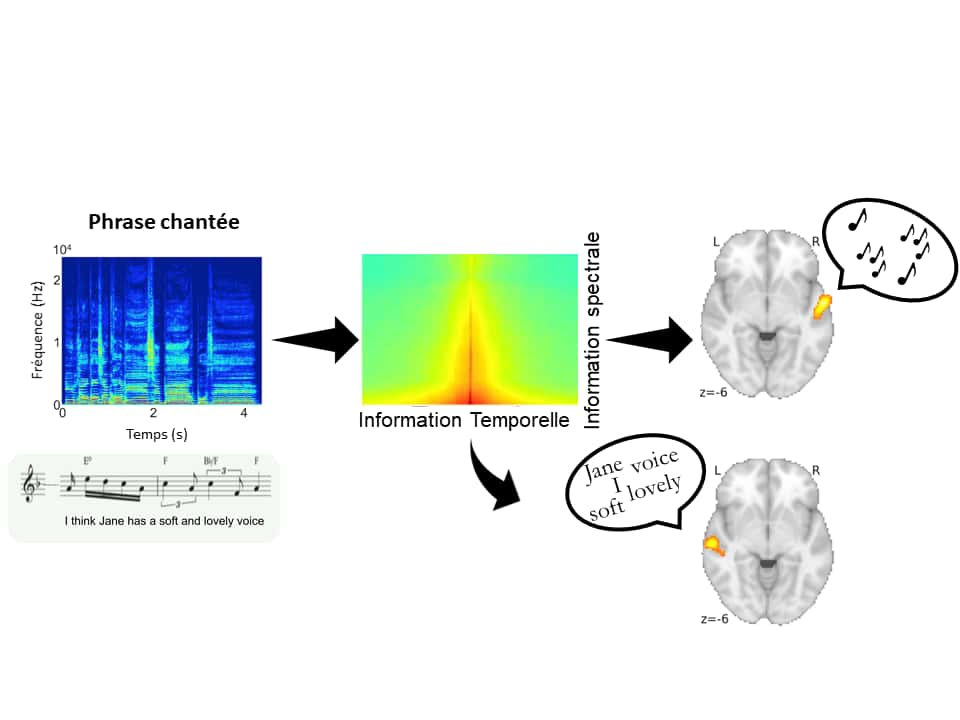

Le son est issu d'un ensemble complexe de vibrationsvibrations de l'airair qui, lorsqu'elles arrivent dans l’oreille interne au niveau de la cochlée, y sont discriminées en fonction de leur vitessevitesse : à chaque instant, les vibrations lentes sont traduites en sons graves et les vibrations rapides en sons aigus. Cela permet de représenter le son selon deux dimensions : la dimension spectrale (fréquence) et la dimension temporelle (temps). Ces deux dimensions auditives sont fondamentales car c'est leur combinaison en simultané qui stimule les neurones du cortex auditif. Ces derniers permettraient notamment de discriminer les sons pertinents pour l'individu, tels que les sons utilisés pour la communication qui permettent l'échange et la compréhension entre individus.

Le saviez-vous ?

Vous souhaitez en savoir plus sur les mystères et le fonctionnement fascinant du cerveau humain ?

- Découvrez le nouveau numéro papier du Mag' Futura : "Jusqu'où peut-on manipuler nos cerveaux ?"

- 148 pages pour percer tous les mystères du cerveau.

- Vous pouvez dès maintenant pré-commander votre exemplaire ou vous abonner sur Ulule.

Le Mag Futura est un magazine papier trimestriel indépendant. Sa promesse ? Vous donner les clés de compréhension pour décrypter les grands défis d’aujourd’hui et de demain, dans un magazine richement illustré, accessible, engagé pour les sciences et la Planète.

Le langage et la musique constituent chez l'humain les principales utilisations du son et les plus complexes au niveau cognitif. L'hémisphère gauche est principalement impliqué dans la reconnaissance du langage, tandis que l'hémisphère droit est principalement impliqué dans celle de la musique. Cependant, le fondement physiologique et neuronal de cette asymétrie était encore méconnu.

Une équipe de recherche codirigée par le chercheur Inserm Benjamin Morillon à l'Institut de neurosciences des systèmes (Inserm/Aix-Marseille Université), en collaboration avec des chercheurs de l'Institut-Hôpital neurologique de Montréal de l'Université McGill, a utilisé une approche innovante pour comprendre comment le langage et la musique sont décodés au sein de chaque hémisphère cérébral chez l'humain. Ces résultats à paraître dans Science.

Des réceptivités différentes aux composantes du son

Les chercheurs ont enregistré 10 phrases chantées chacune par une soprane sur 10 airs mélodiques inédits composés pour l'occasion. Ces 100 enregistrements, dans lesquels mélodie et parole sont dissociées, ont ensuite été déformés en diminuant la quantité d'information présente dans chaque dimension du son. Il a été demandé à 49 participants d'écouter ces enregistrements déformés par paire, et de déterminer s'ils étaient identiques au niveau de la mélodie ou au niveau du texte. L'expérience a été menée en français et en anglais, afin d'observer si les résultats étaient reproductibles dans des langues différentes. En cliquant sur ce lien, une démonstration du test audio proposé aux participants est disponible.

L'équipe de recherche a constaté que, quelle que soit la langue, lorsque l'information temporelle était déformée les participants étaient capables de reconnaître la mélodie, mais avaient des difficultés à identifier le contenu du texte. À l'inverse, lorsque l'information spectrale était déformée, ils étaient capables de reconnaître le texte mais avaient du mal à reconnaître la mélodie.

L'observation par imagerie par résonancerésonance fonctionnelle (IRMf) de l'activité neuronale des participants a montré que, dans le cortex auditif gauche, l'activité variait en fonction de la phrase présentée mais restait relativement stable d'une mélodie à l'autre, tandis que dans le cortex auditif droit, l'activité variait en fonction de la mélodie présentée mais restait relativement stable d'une phrase à l'autre.

La spécialisation de chaque hémisphère cérébral

De plus, lorsque l'information temporelle était dégradée, seule l'activité neuronale du cortex auditif gauche était affectée, tandis que la dégradation de l'information spectrale affectait uniquement l'activité du cortex auditif droit. Enfin, les performances des participants dans la tâche de reconnaissance pouvaient être prédites seulement en observant l'activité neuronale de ces deux aires.

« Ces résultats indiquent que, dans chaque hémisphère cérébral, l'activité neuronale est dépendante du type d'information sonore, précise Benjamin Morillon. Si l'information temporelle est secondaire pour reconnaître une mélodie, elle est au contraire primordiale à la bonne reconnaissance du langage. Inversement, si l'information spectrale est secondaire pour reconnaître le langage, elle est primordiale pour reconnaître une mélodie. »

Les neurones du cortex auditif gauche seraient ainsi principalement réceptifs au langage grâce à leur meilleure capacité à traiter l'information temporelle, tandis que ceux du cortex auditif droit seraient, eux, réceptifs à la musique grâce à leur meilleure capacité à traiter l'information spectrale. « La spécialisation hémisphérique pourrait être le moyen pour le système nerveux d'optimiser le traitement respectif des deux signaux sonores de communication que sont la parole et la musique », conclut Benjamin Morillon.