au sommaire

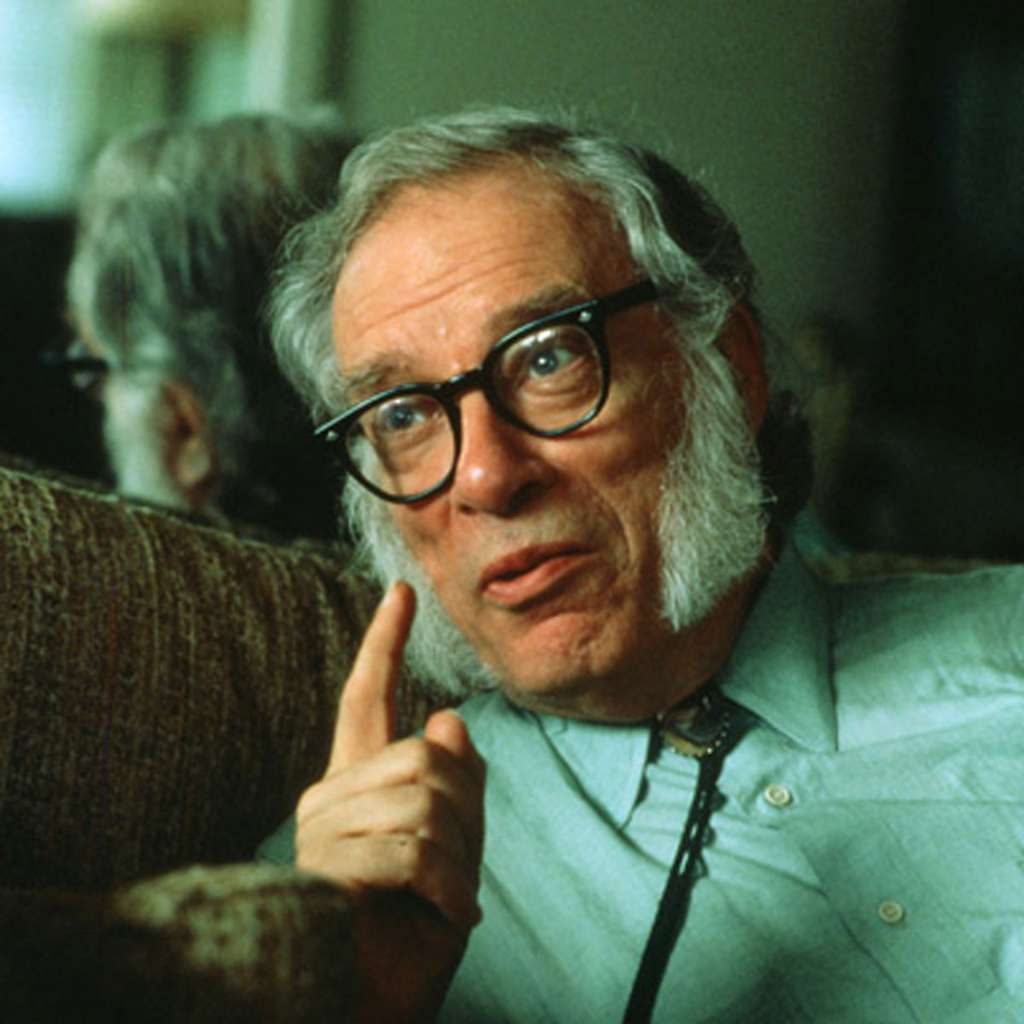

Les lois d'Asimov apparaissent à première vue tout à fait valides et pertinentes, mais lorsqu'on y regarde de plus près, leur application pratique se révèle délicate et soumise à de nombreuses difficultés.

Ainsi, dans plusieurs nouvelles, Asimov place les robots dans des situations de dilemme où il est impossible d'agir sans prendre le moindre risque pour un humain. Aussi crée-t-il un contexte qui contredit la première loi quelle que soit la décision prise ensuite par le robotrobot.

Dans d'autres cas, le robot doit choisir entre plusieurs ordres contradictoires. Il se retrouve alors dans une situation de conflit avec la deuxième loi, dans laquelle il doit choisir à qui il va finalement obéir.

Que ce soit pour des raisons d'ambiguïté des termes, de perception et d'analyse incomplète, de dilemmes ou d'ordres contradictoires, il existe une infinité de cas pratiques qui placent le robot dans une situation où il devient impossible d'agir sans enfreindre d'une manière ou d'une autre l'une des trois lois. De ce fait, contrairement à leur principe initial d'inviolabilité, elles ne peuvent pas être absolues. En outre, leur priorité relative peut varier selon les implémentations, les circonstances, les ordres précédents et l'expérience du robot. Il en résulte une très grande complexité logique qui ne peut se résoudre par des réponses strictement binairesbinaires, d'action ou d'inaction. Il existe le plus souvent plusieurs réponses possibles et une gradation dans la réponse ou l'action choisie.

Asimov était parfaitement conscient des limites de ses trois lois, d'autant qu'il les avait conçues de manière à profiter de leurs faiblesses. Assez rapidement, dès 1950, il en pointa certaines limites, en particulier concernant la première loi qui protège l'humain en tant qu'individu et non en tant qu'espèceespèce. En effet, il serait préférable en toute logique de sacrifier un individu si cela pouvait permettre de sauver un groupe plus important, sinon l'humanité tout entière. Malgré cette prise de conscience précoce, ce n'est qu'en 1985 qu'il intégra cette idée en modifiant les lois. Il ajouta aux trois lois une loi zéro qui plaçait l'intérêt de l'humanité au-dessus de celui d'un seul individu :

- loi zéro : un robot ne peut nuire à l'humanité ni laisser sans assistance l'humanité en danger.

Dans les faits, l'ajout de règles supplémentaires ne résout pas totalement les problèmes. Dans mon livre consacré à ce sujet, je propose une version étendue et plus réaliste des lois de la robotique et j'analyse la manière dont il serait possible de les intégrer en pratique.