au sommaire

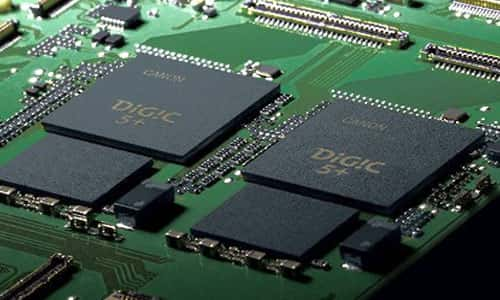

Le processus qui permet de transformer le signal de chaque photosite en image est complexe. Il commence par la numérisationnumérisation du signal initialement analogiqueanalogique, la reconstitution des couleurs par interpolation puis la création d'un fichier dans un format graphique, généralement le JPEGJPEG. Ceci nécessite la présence dans l'appareil d'un ou deux processeurs dédiés.

Macrophotographie d'une feuille. © Bertomic, CCO

Comment l'exposition se fait-elle ? Tout d'abord, il faut « vider » les photosites des charges électroniques parasitesparasites qui s'y trouvent grâce à un signal adapté puis procéder immédiatement à l'exposition.

Certains types de capteurscapteurs ne nécessitent pas, ou ne nécessiteraient théoriquement pas d'obturateurobturateur : il suffit, juste après le « vidage » du capteur, de transférer vers le circuit amplificateur les charges qui se sont accumulées au cours d'une brève fraction de temps qui correspond au temps de pose. Ceci repose sur un système d'horloges électroniques qui séquencent les opérations à exécuter. On n'entrera pas ici dans les détails techniques qui n'ont guère d'intérêt que pour les électroniciens.

D'autres capteurs nécessitent l'utilisation d'un véritable obturateur pour exposer le capteur de la même manière qu'un film. C'est le cas en particulier des reflex, où il existe un obturateur plan focal, ce qui explique pourquoi on doit utiliser le viseur optique traditionnel du reflex pour cadrer l'image au lieu de l'écran LCDécran LCD (sauf sur les modèles pouvant utiliser le mode life view)).

Les circuits d'amplification sont directement intégrés dans les capteurs CMOScapteurs CMOS mais sont séparés pour les capteurs CCDCCD. Le signal une fois amplifié est toujours un signal analogique qui doit être numérisé par un convertisseur analogique/digital (intégré également dans les capteurs CMOS) avant d'être traité par le processeur. On sait que tous les écrans de visualisation reposent sur un codagecodage sur 8 bits de chacune des trois couleurs primaires Rouge, Vert, Bleu. Cette solution donne 256 niveaux possibles pour chaque couleur primaire et 2563=16.777.216 combinaisons pour l'ensemble des couleurs, ce qui fait dire que ces écrans peuvent afficher 16 millions de couleurs. Ceci paraît largement suffisant car c'est plus que ce que l'œilœil humain peut discriminer. Pourtant, en réalité, ce nombre est trompeur : entre le blanc et le noir total il n'y a que 256 gradations de gris possibles (28) et ceci est vrai pour chacune des couleurs pures. Les 16 millions de couleurs proviennent du mélange en proportion variable de la lumière émise par chaque couleur primaire, chacune ne pouvant prendre que 256 niveaux distincts.

Malheureusement, cette situation n'est pas optimum pour un capteur. Imaginons une image test constituée de bandes grises dont la luminance moyenne est telle qu'elle est réduite de moitié quand on passe d'une bande à la suivante, la première bande étant blanche. Bref, c'est comme si on fermait le diaphragmediaphragme d'un cran en passant d'une bande à sa voisine plus foncée. Si on l'expose correctement de telle sorte que la bande blanche soit enregistrée comme un blanc parfait (valeur 255 pour chacune des trois couleurs RVBRVB) dans ces conditions la première bande grise sera représentée par 128, 128, 128, la troisième par 64, 64, 64, la quatrième par 32, 32, 32... Autrement dit, le nombre de bits disponibles devient de plus en plus faible au fur et à mesure qu'on considère des zones de plus en plus sombres. Les nuances allant du blanc absolu au premier gris disposent de 128 bits pour être représentées, celles comprises entre le premier gris et le suivant ne disposent que de 64 bits, et pourtant il y a le même écart de luminance dans les deux cas, etc. Conclusion : on pourra enregistrer beaucoup de détails dans les zones lumineuses tandis que les régions sombres enregistreront trop peu d'informations, celles-ci étant en outre plus ou moins parasitées par le bruit. En d'autres termes, la dynamique est médiocre dans les zones peu éclairées ou, de façon encore plus concrète, il sera difficile de rattraper aisément une sous-exposition6.

La solution pour améliorer les choses consiste à offrir un espace supérieur à 8 bits pour faire la conversion analogique-numériqueconversion analogique-numérique. On ne trouve guère de renseignement sur ce point critique à propos des compacts, mais pour les reflex et les dosdos numériques, on sait que la numérisation se fait selon les cas sur 12 ou maintenant plus souvent sur 14 bits, voire 16 bits pour certains dos professionnels, ce qui améliore nettement l'information collectée pour les zones les plus sombres.

Cependant, il n'y a toujours pas d'image à ce stade : l'étape suivante est confiée à un programme qui va « dématricer » l'ensemble du signal, c'est-à-dire combiner les informations des différents photosites monochromes pour restituer des pixelspixels trichromes, en nombre égal au nombre de photosites présents dans les capteurs. Le programme exécuté par le processeur de l'appareil peut éliminer également à ce stade certains défauts de l'image avec des algorithmes adaptés.

Carte électronique du Canon 1DX équipée de deux processeurs graphiques DIGIC 5+. © Canon

Traitement des couleurs, balance des blancs…

Enfin, l'image sera transformée en un format connu, le plus courant étant le JPEG. Là, le processeur doit procéder à une nouvelle interprétation car le JPEG ne supporte que le codage sur 8 bits, ce qui est, de toute façon, la manière dont l'écran affichera l'image. Il faut donc que le programme de conversion, tout en acceptant des sacrifices dans la dynamique du signal, les fasse en sacrifiant le moins possible ce que la dynamique plus élevée du capteur avait permis de récupérer dans les zones sombres. Durant cette étape, le processeur de l'appareil procède habituellement à un traitement des couleurs (sur la saturation en particulier) de façon à fournir une image plus « flatteuse » que le strict rendu neutre et objectif du capteur ; il corrige aussi le manque de vigueur de l'image causée par le filtre passe-bas. C'est également à ce niveau que se fait la balance des blancs pour tenir compte des conditions d'éclairage (habituellement les amateurs laissent ce réglage sur automatique, ce qui ne donne pas toujours un résultat optimum).

Le format JPEG est un format de compression très performant car il accepte une perte des plus petits détails ou des plus faibles nuances de couleur que l'œil ne remarque habituellement pas. Les appareils permettent généralement d'enregistrer des images JPEG de haute qualité (avec pertes faibles) ou de plus basse qualité. Dans ce cas, le fichier de l'image est plus petit (on peut donc en stocker davantage sur une carte mémoirecarte mémoire) mais au prix d'une perte plus importante des détails. Il faut se méfier du fait que le menu de certains appareils désigne ce mode dégradé comme qualité standard.

Ne pas confondre cette option avec celle qui consiste à changer la taille de l'image (exprimée en nombre de pixels), où l'appareil recalcule entièrement l'image pour la réduire à un format plus petit. Sauf si on sait d'emblée que la photographiephotographie n'aura qu'une utilisation limitée (illustrer un site Web par exemple ou affichage sur écran d'ordinateur uniquement), il n'y a aucun intérêt à choisir cette option. Certes, on peut mettre davantage d'images sur la carte mémoire mais au détriment de leur taille, donc de la possibilité de les agrandir sur papier.

Le format JPEG est le seul qui soit disponible sur les compacts et la plupart des bridgesbridges. Comme c'est un format de compression avec perte, on comprend aisément que si on doit retoucher l'image sur ordinateur, l'enregistrement de l'image retouchée introduira des pertes supplémentaires. Cela reste possible tant qu'on utilise une compression avec un facteur de qualité élevé, qu'on ne multiplie pas trop des interventions successives sur l'image, et qu'on ne projette pas de tirer des agrandissements de grande taille. Mais les possibilités d'intervention restent limitées.

Le format TIFF

C'est pourquoi les professionnels et les amateurs exigeants préfèrent d'autres formats d'enregistrement pour travailler les images. En particulier le format TIFF qui est un format sans perte de qualité et qui peut, au moins avec certains programmes, travailler avec des niveaux sur 16 bits au lieu de 8. En contrepartie, les fichiers sont de taille très importante même s'il existe des options pour les compresser sans perte.

Il est possible de visualiser les pertes dues au format JPEG en utilisant l'espace de couleur LAB. La décomposition d'une image en LAB par Gimp fournit trois calques. Le calque L reproduit la luminance de l'image et la couleur est codée dans les calques A et B. La manière dont les niveaux de gris sur les calques A et B codent en fait des nuances de couleur est un peu complexe et sans intérêt ici. Il est facile de constater que si la luminance est assez fidèlement conservée (du moins pour des taux de compression modérés), pour les couleurs, les détails le sont beaucoup moins, contrairement à ce que donne la même image au format TIFF.

Les images ci-dessous ont été obtenues à partir d'un cliché numérique « haute qualité », c'est-à-dire avec une compression faible.

Détail d'une image JPEG au format 1/1 (1 pixel d'écran = 1 pixel de la photo). © J.-P. Louvet

Canal L (luminance après décomposition LAB). On constate que les détails sont bien conservés. © J.-P. Louvet

Canal A (un des deux canaux de chrominance). On observe clairement les pavés des artefacts de compression (le contraste a été renforcé pour les mettre en évidence). © J.-P. Louvet

Enfin les reflex, quelques bridges et compacts professionnels permettent d'enregistrer le signal numérisé brut dans un format appelé RAWRAW sur lequel nous allons revenir.

6. Cette description paraîtra caricaturale pour un spécialiste, les choses étant bien plus complexes, mais elle suffit pour faire comprendre le problème.