Lors de son événement annuel Search On, Google a annoncé une série de nouvelles fonctionnalités pour Google Lens et Google Search qui reposent sur son puissant algorithme MUM qui apporte une compréhension « multimodale » des requêtes.

au sommaire

Lors de la dernière conférence GoogleGoogle I/O, le géant californien de la recherche en ligne a dévoilé MUM (Multitask Unified Model), un algorithme d'apprentissage automatique chargé d'aider les internautes à trouver plus rapidement les réponses à leurs requêtes en réduisant le nombre d'étapes. Pour ce faire, MUM est capable d'analyser des données dans 75 langues différentes et de recouper des informations dans du texte, des images, des vidéos et de l'audio. C'est ce que Google appelle une compréhension « multimodale ». A l'occasion de son événement Search On qui vient de s'achever, l'entreprise a annoncé les premières utilisations concrètes de MUM dans ses services.

Ainsi, la recherche visuelle avec Google Lens va devenir plus pertinente grâce à la puissance de MUM. Il sera bientôt possible de lancer une recherche à partir d'une photo en ajoutant une question textuelle à propos de ce que l'on voit. Par exemple, explique Google, on pourra prendre la photo d'un animal et demander des informations sur la manière de le nourrir. Ou encore, à partir de la photo d'un t-shirt, demander à Google Lens de trouver une paire de chaussettes avec le même motif. Le déploiement de cette fonctionnalité interviendra pour la version anglaise du service entre la fin de l'année et le premier trimestre 2022.

Google Lens arrive dans Chrome

D'ici quelques mois, la version pour ordinateurs de bureau du navigateur Chrome intègrera Google Lens. Il sera alors possible de sélectionner des images, des vidéos et du texte sur une page web et d'obtenir des résultats de recherche sans quitter celle-ci.

MUM va également contribuer à affiner et approfondir les résultats du moteur de recherche Google avec de nouveaux outils : Things to know (ce qu'il faut savoir) qui recense les informations clés liées à une recherche ; Refine this search / Broaden this search pour affiner ou élargir certains aspects d'un sujet ; Une page de résultats à parcourir visuellement afin de faciliter la navigation, notamment sur les mobilesmobiles.

Autre évolution majeure, d'ici quelques semaines, MUM fonctionnera pour faire de la recherche au cœur d'une vidéo. L'algorithme sera capable d'identifier des thèmes, même s'ils ne sont pas mentionnés spécifiquement. Une option qui sera d'abord réservée aux requêtes en anglais.

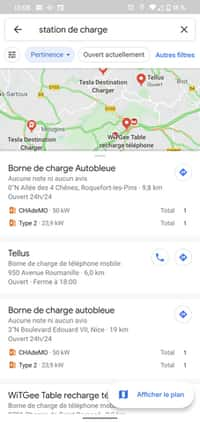

Google muscle également la partie shopping de son moteur de recherche depuis un terminal mobile avec, là encore, des résultats plus visuels accompagnés d'informations mieux localisées. La principale nouveauté qui est introduite est le filtre « en stock » grâce auquel on pourra voir quels sont les commerces à proximité ayant en rayons l'article recherché. Une fonction qui est disponible en France dès à présent.

Les incendies dans Google Maps

Après avoir introduit des données satellites sur les incendies de forêt l'année passée, Google Maps va s'enrichir d'un nouveau filtre pour aider les internautes avec des sites web et numéros d'urgence, des consignes d'évacuation lorsqu'elles sont disponibles ou encore la taille et la progression d'un incendie. Cette fonction sera disponible mondialement sur AndroidAndroid, iOSiOS et ordinateurs de bureau le mois prochain.