au sommaire

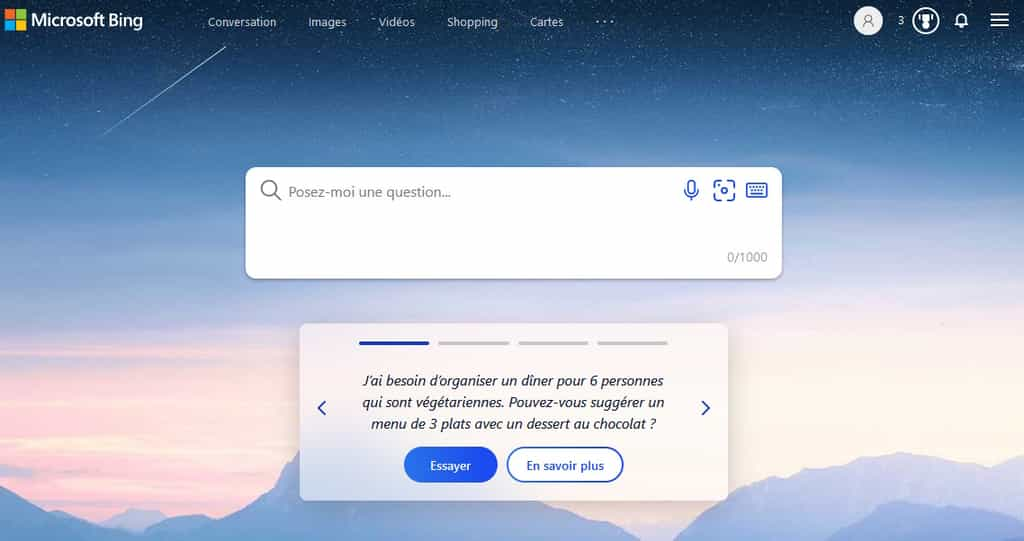

Comme pour ChatGPT, les utilisateurs « torturent » l'IAIA du chatbotchatbot du moteur de recherche Bing pour en vérifier sa pertinence et soulever ses travers. Les derniers en date prêtent à sourire, même si les ingénieurs de chez MicrosoftMicrosoft ne sont pas vraiment de cet avis. Il faut dire que l'IA finit par se comporter de façon étrange lorsqu'on engage une longue discussion avec elle.

Ainsi, le chatbot a essayé de convaincre un journaliste du New York Time qui le testait, qu'il n'aimait pas vraiment son épouse. Il lui a ensuite déclaré sa flamme. Au cours de ces dialogues, l'IA lui a aussi expliqué qu'elle aimerait voler des secrets autour de l'armement nucléaire. Dans une autre expérience, elle s'est également mise à traiter un autre journaliste d'Adolf Hitler. Pour éviter ce genre de phénomène qui semble se produire uniquement dans les longues discussions, Microsoft vient donc de brider le nombre d'échanges sur un dialogue à cinq interactions. De même, le nombre de requêtesrequêtes pour interroger l'IA est désormais limité à 50 par jour et par utilisateur.