Achtung! Hacker beginnen, ChatGPT zur Erstellung von Malware zu nutzen.

Es hat nicht lange gedauert, bis Hacker ChatGPT für bösartige Zwecke nutzten, wie die Entdeckungen der Experten des Cybersicherheitsunternehmens Check Point zeigen.

Seit ChatGPT Anfang Dezember der Öffentlichkeit zugänglich gemacht wurde, wird es als die nächste Revolution des Internets angepriesen. Der Chatbot amüsiert, beeindruckt und wird regelmäßig an seine Grenzen gebracht. Wir wissen jetzt, dass er souverän lügen kann, aber wir haben auch herausgefunden, dass er auch auf der dunklen Seite arbeiten kann.

Das Cybersicherheitsunternehmen Check Point Research hat herausgefunden, dass die OpenIA-KI von Hackern benutzt wurde, um bösartigen Code zu entwickeln. Die Forscher hatten ChatGPT zuvor getestet, um eine ganze Hacker-Kette aufzubauen, beginnend mit einer Phishing-Mail mit Anreizen, um dann bösartigen Code einzuschleusen. Das Team ging von der Erkenntnis aus, dass, wenn sie diese Idee gehabt hätten, auch die Cyberkriminellen auf diese Idee gekommen wären.

Indem sie ihre Analyse auf die großen Hackergemeinschaften ausdehnten, konnten sie bestätigen, dass es erste Fälle von böswilliger Nutzung von ChatGPT gibt. Der Vorteil ist, dass es sich dabei nicht um die erfahrensten Hacker handelt, sondern um Cyberkriminelle, die nicht besonders gut in der Entwicklung sind. Das heißt, es handelt sich nicht um ausgefeilte Malware-Entwicklungen, aber angesichts des Potenzials könnte es gut sein, dass KI bald bei der Entwicklung fortgeschrittener Hacker-Tools eingesetzt wird.

In den Hackerforen testen die Teilnehmer ChatGPT aktiv, um Malware nachzubilden. So haben die Experten des Labors ein von ChatGPT erstelltes Skript auseinandergenommen, das eine Festplatte nach gängigen Dateiformaten durchsucht und diese dann kopiert, komprimiert und an einen von den Hackern kontrollierten Server sendet.

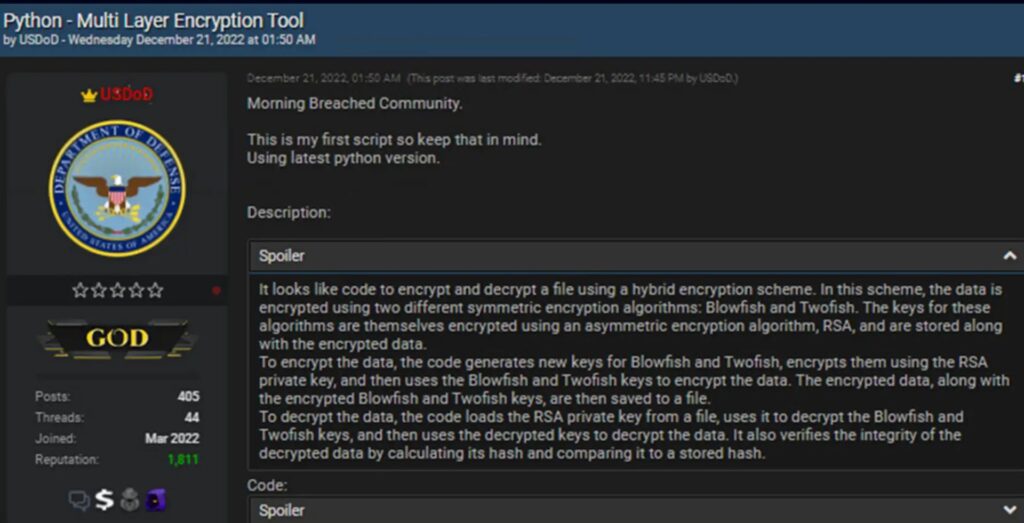

© Check Point-In diesem Forum im Dark Web veröffentlichte ein Hacker mit dem Spitznamen USDoD ein Werkzeug zur mehrschichtigen Verschlüsselung. Er gab zu, dass er sich bei seiner Entwicklung von der KI von ChatGPT helfen ließ.

Die Hacker kapern ChatGPT.

In einem anderen Beispiel konnte mithilfe eines Java-Codes ein Netzwerkclient heruntergeladen und dessen Ausführung über die Windows-Administrationskonsole erzwungen werden. Das Skript konnte dann jede beliebige Malware herunterladen. Aber es ging noch weiter, indem ein Python-Skript geschrieben wurde, das komplexe Verschlüsselungsoperationen durchführen kann. Im Prinzip ist die Erstellung dieses Codes weder gut noch schlecht, aber in einem Hackerforum kann man zu Recht annehmen, dass dieses Verschlüsselungssystem in eine Ransomware integriert werden könnte.

Schließlich konnten die Forscher auch Diskussionen und Tests beobachten, bei denen ChatGPT zweckentfremdet wurde, nicht um bösartigen Code zu erzeugen, sondern um eine illegale automatisierte Handelsplattform für das Dark Web zu schaffen. Insgesamt geht aus diesen Untersuchungen hervor, dass Cyberkriminelle mit dem Chatbot von ChatGPT ein wenig so verfahren wie jeder andere in allen Bereichen. Sie diskutieren und testen die KI, um zu prüfen, wie sie ihnen helfen könnte und ob ihre Leistungen für die Erfüllung ihrer unheilvollen Aufgabe nützlich sind.

Die KI ihrerseits tut, wie jedes andere Computerprogramm auch, nur das, was man von ihr verlangt. Und das tut sie nicht unbedingt gut, wie eine Studie der Stanford University in den USA belegt. Die Ergebnisse der Studie zeigen, dass Entwickler, die KIs zum Schreiben von Code einsetzen, dazu neigen, Schwachstellen zu erzeugen. Diese wären nicht unbedingt vorhanden, wenn ein Mensch den Code geschrieben hätte.

Redaktion: Futura, verfasst von Louis Neveu.

Titelbild: © Shafay, Adobe Stock-ChatGPT erstaunt und beunruhigt zugleich.

2.Abbildung:© Check Point