Les réseaux neuronaux peuvent être infectés silencieusement par des malwares sans que cela ne dégrade leurs performances. Aucune solution de sécurité ne peut les détecter. Inquiétant.

au sommaire

L'intelligence artificielle est capable de prouesses. Elle sait reconnaître des objets sur les photos, générer du texte semblant avoir été rédigé par un humain et devient de plus en plus performante pour ce qui est de la reconnaissance vocale. Mais, selon les chercheurs de l'Université de Californie, de San Diego et de l'Université de l'Illinois, les réseaux de neurones, qui constituent l'IA, pourraient également servir à dissimuler de redoutables malwares qui passeraient entre les mailles du filet des solutions de sécurité. Il faut dire que, par leur nature même, ces réseaux sont conçus pour ingurgiter des quantités énormes de données pour consolider leur apprentissage. Ils peuvent tout aussi bien assimiler du code malveillant.

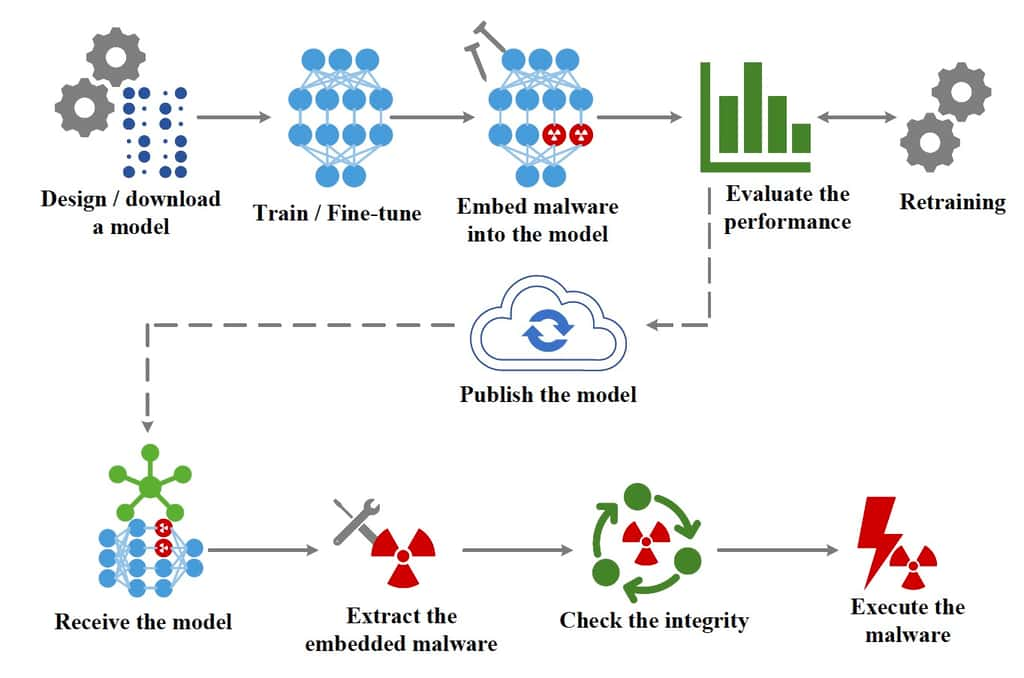

Ce code est placé dans des données semblant inoffensives, selon la méthode de la stéganographie, c'est dire l'art de faire passer inaperçu un message dans un autre message. Pour prouver leur théorie, les chercheurs ont utilisé ce qu'on appelle désormais un EvilModel, une suite de code malveillant pesant 26,8 Mo. Ils l'ont inoculé dans une IA convolutive. Ils ont choisi AlexNet, une IA de 178 Mo spécialisée dans la reconnaissance des images. Fragmenté, ce code malveillant n'a pas vraiment perturbé le réseau neuronal puisque la perte de précision de celui-ci a été limitée à 1 %, selon leurs mesures de performances.

Cela signifie que l'utilisateur ne peut pas soupçonner la présence d'un problème puisque le réseau neuronal ne faillit pas à ses tâches habituelles. Et surtout, aucun des antivirusantivirus n'a été capable de détecter la présence de ces 26,8 Mo de malwares. Après cet entraînement intégrant ce code, les chercheurs ont ensuite augmenté le volumevolume de malwares à 36,9 Mo. Entraîné avec cette nouvelle base de donnéesbase de données, les performances ont décliné seulement de 10 %, ce qui reste suffisant pour faire illusion. Ils ont également testé EvilModel sur d'autres IA, notamment VGG, Resnet, Inception et Mobilenet et obtenus des résultats similaires.

Menace dans l'Intelligence artificielle

La contaminationcontamination par du code malveillant reste inoffensive tant que l'utilisateur n'appelle pas cette IA avec une applicationapplication elle aussi préalablement vérolée par un malware. C'est ce dernier qui va permettre d'activer la charge viralecharge virale et exécuter, par exemple, un ransomwareransomware sur l'appareil de la victime. Le souci est que les IA se trouvent de plus en plus imbriquées dans les applications courantes. Elles pourraient bien devenir le terrain de jeu préféré des pirates étant donné l'impossibilité de détecter ce code malveillant qui ne vient pas altérer les fonctions de l'Intelligence artificielle.

Pour inoculer le malware à une Intelligence artificielle, l'attaquant pourrait proposer des modèles d'apprentissage fonctionnels vérolés en les hébergeant sur des plateformes comme GitHub ou TorchHub. D'une façon un peu plus vicieuse, comme les données envoyées par les applications de l'utilisateur servent aussi à l'apprentissage de l'IA, le pirate pourrait également la contaminer via des mises à jour vérolées de ces applications. Comme ces passagers clandestins sont indétectables, la seule façon d'éviter leur activation va reposer sur la détection d'un malware en sommeilsommeil sur l'appareil de l'utilisateur, ce qui est loin d'être gagné.