L’intelligence artificielle de ModelScope est capable de générer de très courtes vidéos à partir de texte, et les premiers résultats sont aussi étranges qu'impressionnants. L’IA n’en est qu’à ses balbutiements, mais il semble déjà clair que ce type de générateur de vidéos va monter en puissance.

au sommaire

Après les IAIA génératives pour le texte et les images, voici venu le temps de celles qui créent des vidéos. On est encore très loin des vidéos de Deepfake, mais en moins de trois minutes, tout un chacun peut générer une très courte séquence animée. Parmi ces outils spécialisés, il y a celui de Modelscope.

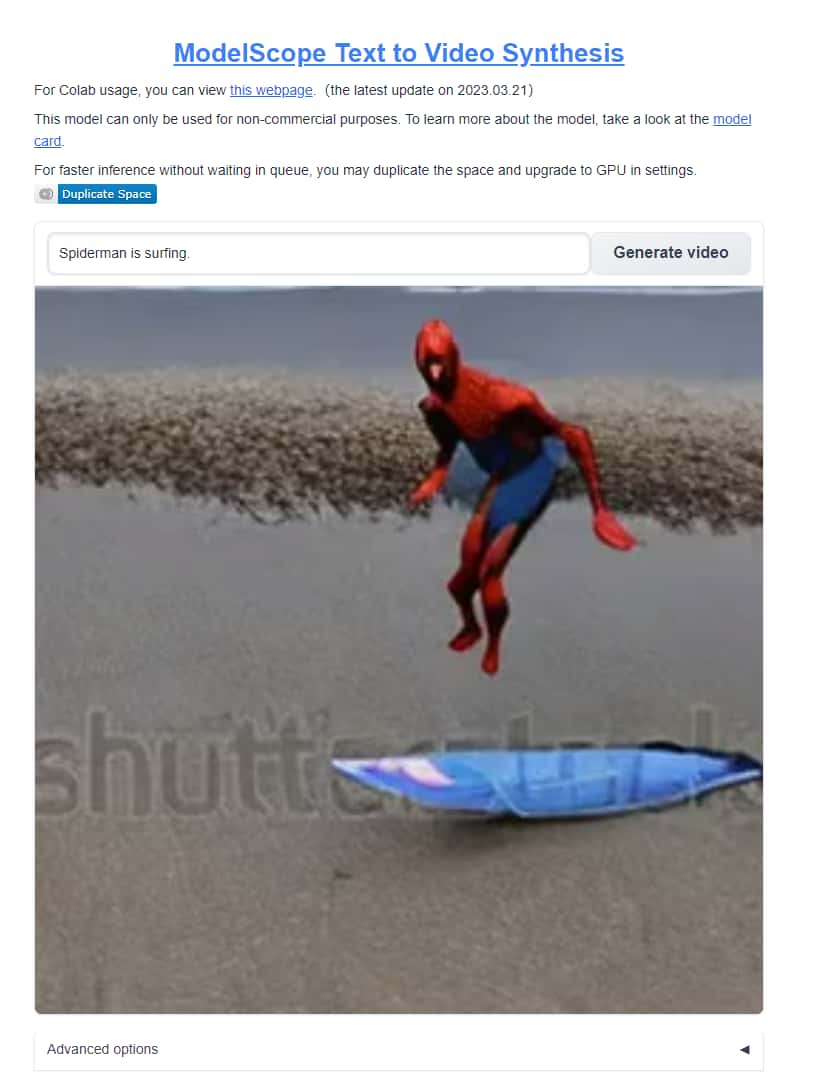

La plateforme n'en est qu'à ses balbutiements. C'est pour le moment la seule à avoir sauté le pas pour libérer son accès au grand public. L'outil à l'aspect rudimentaire est hébergé par HuggingFace, une plateforme américaine dédiée au traitement du langage naturel, mais Modelscope provient de Chine. Dans le champ disponible, il suffit de saisir le type d'animation que l'on souhaite voir affiché et de cliquer sur le bouton « Generate Video ». Là encore, comme pour des IA transformant le texte en images, seule l'imagination peut présenter un frein. Il faut également penser au nouvel art du « prompt » associé à ces IA. Ce « prompt » permet de décrire précisément ce que l'on souhaite voir affiché. Dans le cas de Midjourney, par exemple, plus il y a des détails techniques (éclairage, stylestyle de rendu, profondeur de champ...)), plus le résultat est précis. Pour Modelscope, c'est pour le moment moins utile, mais il faut préciser si la vidéo est en couleurcouleur, sinon ce sera du noir et blanc par défaut. Le temps de traitement est assez long, au moins 200 secondes pour générer une vidéo de seulement deux secondes. Il faut également noter que la plateforme est souvent saturée.

Des courtes séquences un brin inquiétantes

À l'issue du traitement, un aperçu de la vidéo est disponible. Sous le lecteur, en jouant avec les options avancées, il est possible d'augmenter le nombre d'images par seconde et d'affiner la transition entre les différentes scènes. À partir du moment où l'on augmente le niveau de ces options, la duréedurée de traitement peut prendre un bon quart d'heure. Parlons du résultat. Il reste assez abstrait avec des visages très approximatifs, une définition médiocre et des scènes saccadées. À noter qu'un filigrane Shutterstock est souvent présent, signe que l'IA vient piocher dans cette base photographique à partir du moment où l'on souhaite mettre en scène une personnalité.

Au final, cela ressemble aux premiers Gif animés. Au niveau de leur aspect, les personnages sont semblables aux premières versions de DALL-E, il y a plus d'un an, ce qui laisse supposer que les améliorations vont très rapidement arriver. Parmi les premières créations publiées sur les réseaux sociauxréseaux sociaux, on trouve déjà de nombreuses séquences mettant en scène des personnalités. C'est le cas de Will Smith qui mange goulûment des spaghettis, ou encore d'Emmanuel Macron qui débarrasse des rues encombrées de poubelles. Le côté grotesque de ces images animées a un effet inquiétant. Si ce n'est que le début, il faut savoir que de son côté OpenAI planche aussi sur une IA identique.