Les récents progrès en intelligence artificielle ont permis des avancées spectaculaires dans de nombreux domaines. Moins médiatisées pour la musique, les applications de l'IA n’en sont pas moins importantes. Elles suscitent dès lors de nombreuses interrogations : l’IA peut-elle égaler les meilleurs compositeurs ? Va-t-elle un jour remplacer les artistes ? Est-ce le futur de la musique ?

au sommaire

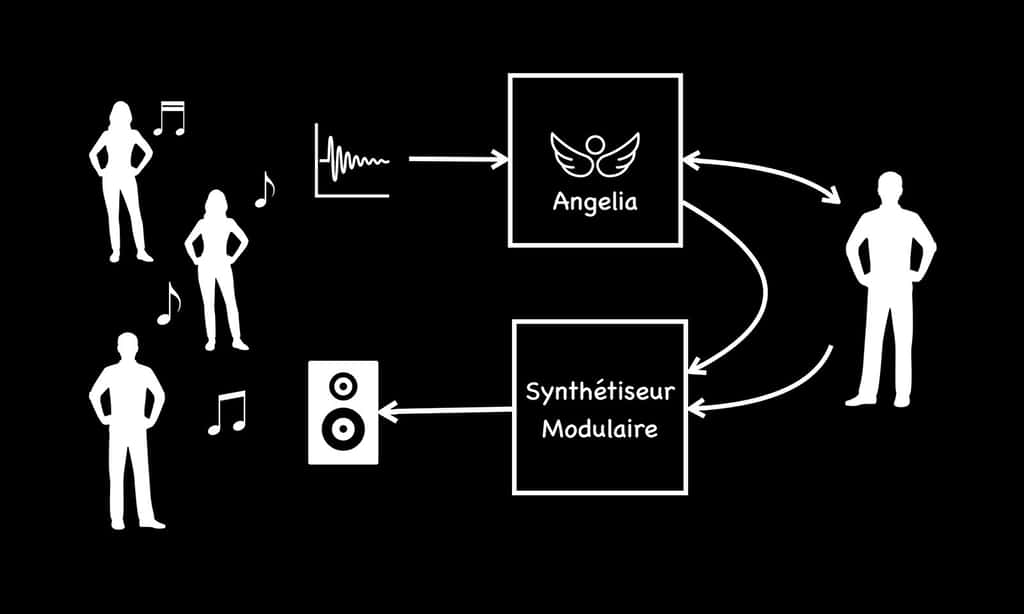

Pour répondre à ces questions, nous allons retracer brièvement l'histoire de l'intelligence artificielle en musique, puis avec « Angelia », une IA dédiée à la musique électronique, nous mettrons en évidence ses enjeux et perspectives.

Depuis l’Antiquité, les liens entre la musique et les algorithmes ont suscité l’intérêt des scientifiques et des compositeurs

Depuis toujours, la musique intéresse les scientifiques par ses qualités formelles et, vice versa, les musiciens trouvent dans les sciences de nombreuses sources d'inspiration. L'idée d'utiliser des instructions pour créer de la musique est évoquée par les Grecs dès l'Antiquité, en particulier par Pythagore (VIe siècle avant J.-C.). Comment ne pas citer Jean-Sébastien Bach (1685-1750) qui utilisait des méthodes mathématiques et géométriques, ou bien encore Wolfgang Amadeus Mozart (1756-1791) et sa génération de pièces musicales par recombinaisonrecombinaison de fragments tirés au sort avec des dés (Musikalisches Wurfelspiel, 1787).

Du côté des scientifiques, Jacques de Vaucanson (1709-1782) a créé en 1738 deux automates musiciens capables de jouer réellement de leur instrument. Si les automates de Vaucanson ont disparu, ceux réalisés par les Jaquet-Droz et Leschot en Suisse sont toujours visibles au Musée de Neuchâtel. La musicienne est probablement le plus bel exemple. L'automate joue réellement de l'orgue, grâce à son cylindre où est « programmé » son répertoire, préfigurant ainsi la programmation des robots. Citons également la « Joueuse de Tymapon » de Peter Kintzing, visible au Musée des Arts et Métiers à Paris.

Ada Lovelace (1815-1852), qui assistait Charles Babbage dans la conception de sa « machine analytique », fut la première à programmer un algorithme sur un calculateur, citant explicitement la composition musicale comme une applicationapplication potentielle.

Les ordinateurs et l’intelligence artificielle apparaissent dans les années 1950, déjà avec des expérimentations musicales

Le premier morceau de musique généré par ordinateur est celui de Lejaren Hiller et Leonard Isaacson à l'université de l'Illinois en 1955 sur l'Illiac (Illinois Automatic Computer).

Dès 1956, Iannis Xenakis (1922-2001) créait des « compositions stochastiquesstochastiques » en utilisant une approche mathématique, puis il continua à partir des années 1960 en développant des programmes musicaux en Fortran.

La première International Computer Music Conference s'est tenue au Michigan State University en 1974. Progressivement, l'IA pour la musique devenait un domaine de recherche académique actif.

En 1980, David Cope de l'université de Californie à Santa Cruz développait EMI (Experiments in Musical IntelligenceIntelligence), un programme Lisp capable de composer des pièces musicales dans les stylesstyles de Bach, Mozart, Brahms et bien d'autres. EMI comprenait une importante base de données de descriptions de styles, de règles de recombinaison, et différentes stratégies de composition.

Les réseaux de neurones et l’apprentissage profond ouvrent la voie à de nouvelles applications pour la musique

En 1997, une équipe de recherche dédiée est initiée par François Pachet au sein du Computer Science Laboratory de Sony à Paris. En 2016, ils créent l'évènement avec « Daddy's, Car », un morceau dans le style des Beatles composé avec « Flow Machines », puis arrangé et interprété par Benoît Carré.

Avec les avancées de l'IA au cours des années 2010, de nouvelles applications de reconnaissance ou de production sont développées. Citons le projet Magenta de GoogleGoogle basé sur TensorFlow à titre d'exemple, ou bien encore le service AIVA (Artificial Intelligence Virtual Artist) accessible par abonnement. Des outils d'aide à la composition et à la production basés sur l'IA font progressivement leur apparition dans les plateformes de production musicale (DigitalDigital Audio Workstations).

Les artistes eux aussi commencent à utiliser l'IA de manière créative, comme Holly Herndon ou Actress.

La musique : un phénomène sonore complexe qui crée de l’émotion à l’état pur

L'approche la plus courante consiste à entraîner un réseau de neuronesneurones avec un grand nombre de partitions d'un compositeur. Une fois l'apprentissage terminé, le réseau est capable de produire une suite de notes qui correspond au style du compositeur si on lui fournit quelques notes de départ. En quelque sorte, le réseau de neurones prédit la séquence la plus probable compte tenu de ce qu'il a appris. Cela donne des résultats impressionnants pendant quelques secondes, mais sur un temps plus long, cela devient rapidement ennuyeux. Avec du Frédéric Chopin, par exemple, on obtient une suite de notes statistiquement correcte, évoquant effectivement son style, mais qui n'arrive jamais à nous faire ressentir l'émotion romantique caractéristique du compositeur polonais.

La principale difficulté réside dans la structure enchevêtrée des œuvres musicales. Les différents niveaux (notes, mesures, sections, pour ne citer que les plus évidentes) tissent des relations localement et globalement. Si les réseaux de neurones actuels arrivent à résoudre les liens de « tension-résolution » au niveau de quelques mesures, la gestion des corrélations plus longues reste problématique.

En outre, la musique est comme de l'émotion à l'état pur. Pour Kant, elle est « le langage des émotions ». Or, par constructionconstruction, une IA est totalement dénuée d'émotion. « Elle » ne ressent rien. D'ailleurs, la plupart « n'entendent rien », « elles » sont « sourdes » et ne peuvent produire que des suites statistiques de nombres sans aucune intention artistique.

« Angelia », une intelligence artificielle émotionnelle pour la musique électronique

Angelia est un projet de recherche visant à créer une intelligence artificielleintelligence artificielle dédiée à la musique électronique. Ce nom est une contraction de « Angel » (angeange) et de l'acronyme IA, pour intelligence artificielle.

Un point important du projet Angelia est de placer l'humain au centre. Trop souvent, sa place est tout simplement oubliée dans les projets d'intelligence artificielle ou de robotiquerobotique. Par conséquent, une IA pour la musique doit augmenter les capacités créatrices d'un artiste et non chercher implicitement à le remplacer. Il est donc impératif que cette IA soit interactive et qu'elle puisse s'insérer dans le processus créatif du compositeur.

Pour interagir, il faut un langage commun. La musique possède son propre langage, sous la forme des partitions connues de tous. Il y a longtemps déjà, des musiciens ont proposé des alternatives plus graphiques et plus souples, comme Iannis Xenakis ou bien encore Brian Eno. Mais ces représentations sont peu adaptées aux traitements algorithmiquesalgorithmiques.

Angelia utilise plutôt un « langage algorithmique de composition musicale » qui est à la fois compréhensible pour un auteur et interprétable par l'IA. Cette approche permet également le « live coding », une tendance musicale qui émerge depuis quelques années où l'on joue de la musique en direct avec du code informatique.

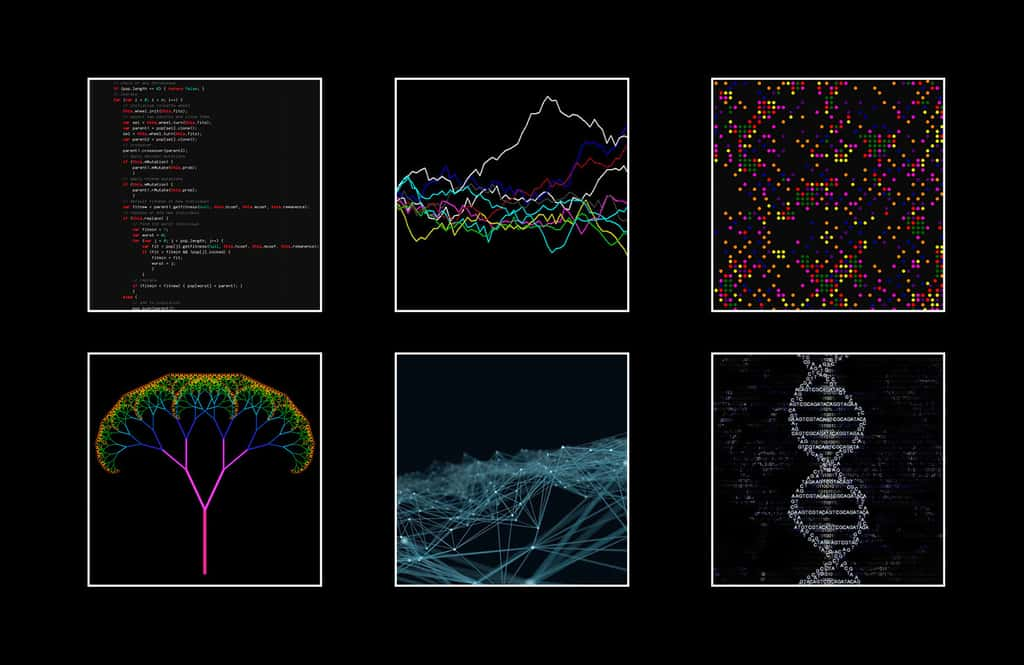

Angelia ne repose pas sur une unique technologie « miraculeuse » qui serait capable de tout faire. Son langage de programmation musical permet d'utiliser différents algorithmes issus de la recherche en IA : procéduraux, stochastiques, automates cellulairesautomates cellulaires, réseau de neurones, algorithme génétiquegénétique, etc. Le trait commun reste celui d'une approche bio-inspirée, c'est-à-dire qui trouve son inspiration dans les processus naturels et le vivant. Une partie importante du développement consiste aussi à « nourrir » la base de connaissance avec des corpus de données provenant de grands compositeurs classiques, mais aussi du jazz.

Une seconde caractéristique importante du projet Angelia est d'intégrer l'émotion au cœur de son approche. Si une IA ne peut ressentir des émotions, il est néanmoins possible de concevoir une architecture où l'IA perçoit son environnement sonore. Les données obtenues peuvent être analysées en temps réel pour générer des stimuli qui font évoluer un « métabolismemétabolisme émotionnel », sorte de simulation de notre système limbiquesystème limbique. Celui-ci va en retour influer sur certains paramètres modifiant l'expressivité de l'interprétation, ou le choix de telle ou telle ligne mélodique. On peut imaginer dans l'avenir étendre cette perception de l'environnement pour « écouter » les autres musiciens et le public, ou bien encore augmenter la capacité de perception grâce à la vision artificielle.

Vers des instruments de musique augmentés : les « hyperinstruments »

Pour générer la musique, Angelia est couplée à un instrument électronique, comme un piano numérique par exemple. L'ensemble devient alors une sorte d'instrument augmenté.

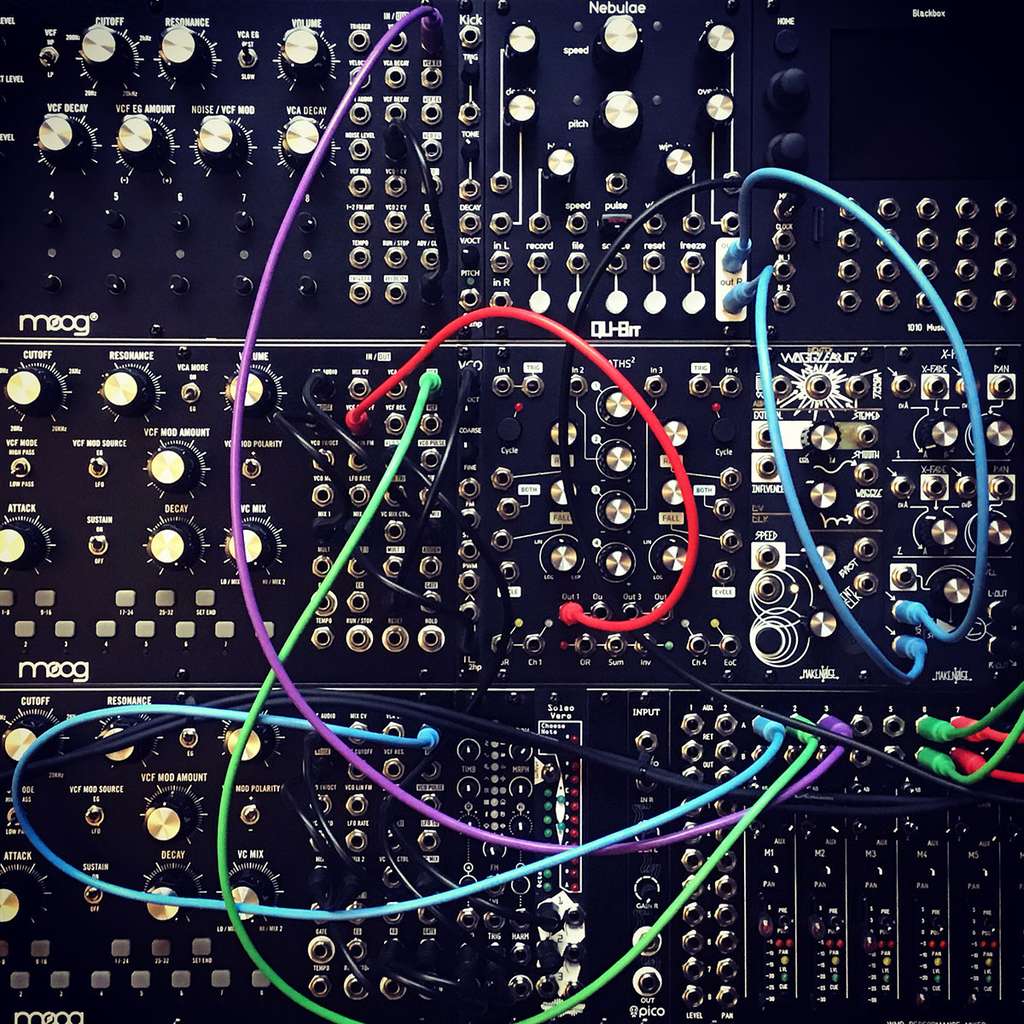

Dans les performances, j'utilise plutôt un synthétiseur modulaire. Les premiers ont été inventés dans les années 1960, en parallèle par Robert Moog et Donald Buchla, respectivement sur les côtes Est et Ouest des États-Unis. L'intérêt est de pouvoir construire son propre instrument en choisissant les modules qui le composent : oscillateurs, samplers, filtres, enveloppes, etc., tous contrôlés par tension et interconnectables par l'intermédiaire de câbles. C'est un instrument impressionnant, entièrement reconfigurable.

Couplé avec Angelia, il devient alors un « hyperinstrument » qui dépasse les capacités des instruments classiques (au sens défini par S. Casanelles), permettant ainsi d'explorer de nouveaux territoires « hyperréalistes ». Il s'anime et devient presque organique. Composer et jouer avec un tel instrument est alors très stimulant.

Une IA émotionnelle dédiée à la musique électronique représente un challenge de recherche ambitieux, toujours en cours de développement. Plusieurs albums ont été produits qui montrent son évolution. À l'inverse de remplacer les artistes, l'IA peut donc être un « compagnon de musique » qui augmente la capacité créative de l'artiste et ouvre la voie à de nouvelles perspectives musicales.

Pour suivre l’actualité d’Angelia :

- Instagram @angelia.heudin

- https://www.artificial-creature.com