Pour soulager le processeur principal et réduire la consommation électrique des serveurs et des data centers, Intel a développé des processeurs intégrant leur propre intelligence artificielle. Idéal pour effectuer des calculs très complexes, mais aussi compiler d'immenses banques de données.

au sommaire

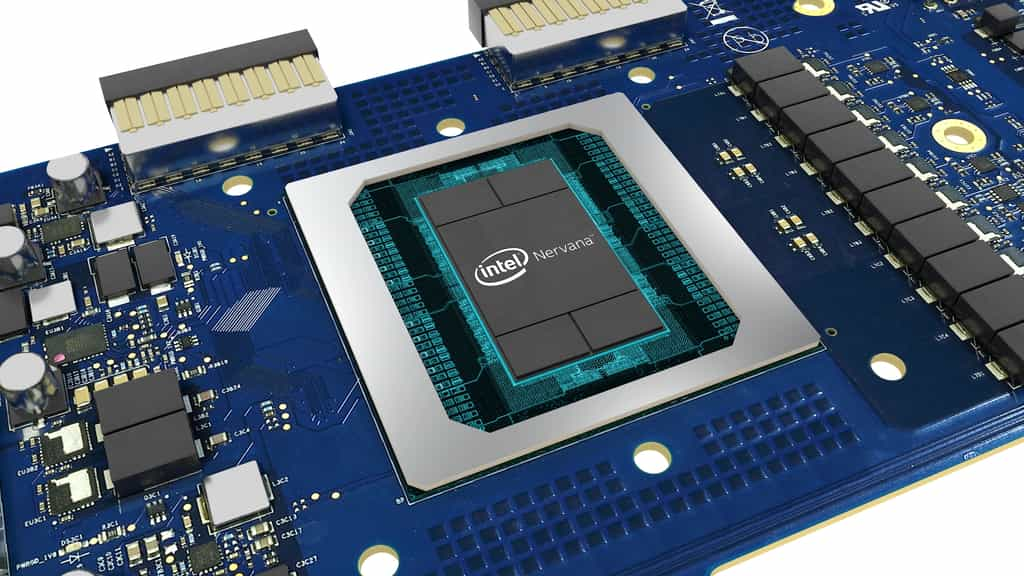

À l'occasion de la conférence Hot Chips 31 qui s'est déroulée du 18 au 20 août à l'université Stanford aux États-Unis, IntelIntel a dévoilé de nouvelles puces décrites comme étant des accélérateurs d'intelligence artificielle haute performance. Elles sont baptisées Intel Nervana « Neural NetworkNeural Network Processors » (NNP) ou processeurs à réseau neuronal.

Intel a développé deux processeurs distincts qui s'appuient sur la nouvelle architecture Ice Lake de la firme en 10 nanomètresnanomètres. Ils s'inscrivent dans la vision à long terme du constructeur, qui imagine déjà l'intelligence artificielle partout. Selon Naveen Rao, directeur général du département des produits d'intelligence artificielle d'Intel, « Pour parvenir à un futur où l'IA est partout, il sera nécessaire de prendre en charge l'énorme quantité de données générées et s'assurer que les entreprises disposent des outils pour utiliser de manière efficace leurs données là où elles sont produites. »

Deux processeurs, pour l’entraînement et la mise en pratique de l’IA

Le premier, appelé NNP-T et qui porteporte le nom de code Spring Crest, sert à l'entraînement de l'intelligence artificielle. Il diffère beaucoup des processeurs Intel Xeon qui apportent certaines instructions spécifiques à l'IA. Il s'agit ici d'une nouvelle architecture construite spécifiquement pour accélérer l'entraînement des réseaux neuronaux, tout en réduisant la consommation électrique nécessaire.

Le second processeur, qui se destine à un déploiement à plus grande échelle, s'appelle NNP-I (I pour inférence) ou Spring Hill. Dans le domaine de l'intelligence artificielle, l'inférence est la mise en pratique des algorithmes générés pendant l'entraînement, où l'IA va inférer des résultats à partir des données fournies (comme prédire votre prochain achat d'après les items consultés dans le magasin). Intel a donc prévu une carte qui pourra être branchée sur toute carte mère, mais vise avant tout les serveurs et les data centers, plutôt que le grand public. FacebookFacebook l'a d'ailleurs déjà intégré dans ses immenses serveurs.

Une carte compatible avec les serveurs existants

Le NNP-I se branche sur le port M.2 standard d'une carte mère, connu avant tout pour le branchement des cartes de stockage SSD, et permet donc de décharger le processeur principalprocesseur principal des tâches qui font appel à l'intelligence artificielle. Le processeur utilise une interface PCI-ExpressPCI-Express 3.0 x4 ou x8, et il est composé de deux cœurs dédiés à l'intelligence artificielle (SNC IA Core) et 12 moteurs d'inférence (Inference Compute Engines ou ICE).

La carte NNP-I est donc prévue pour être compatible avec la plupart des serveurs existants, nécessitant un simple branchement sur un emplacement libre. L'architecture est extensible, ce qui permet d'ajouter de multiples cartes au besoin sur un même serveur. Ce nouveau système est entièrement autonome ; Intel fournira des logicielslogiciels qui permettront d'envoyer des tâches directement à la puce NNP-I, contournant complètement le processeur principal de la machine.

Intelligence artificielle : Intel dévoile Nervana, un processeur pour l’apprentissage profond

Intel vient de présenter un processeur dédié aux applicationsapplications d'intelligence artificielle faisant appel à l'apprentissage profondapprentissage profond. Le fondeur s'est associé à Facebook pour développer cette nouvelle gamme de puces spécialisées.

Publié le 20/10/2017 par Marc ZaffagniMarc Zaffagni

En août 2016, Intel a fait l'acquisition de la jeune pousse Nervana Systems qui travaillait sur l'intégration des techniques d'apprentissage automatique (machine learningmachine learning) et profond (deep learning) directement dans un processeur. Un peu plus d'un an plus tard, le fondeur vient de dévoiler son premier processeur dédié aux réseaux neuronaux artificiels qui sous-tendent l'apprentissage profond.

Baptisée Nervana Neural Network Processor, cet Asic (Application-Specific Integrated Circuit ou circuit intégrécircuit intégré spécialisé) est présenté comme le premier du genre à être commercialisé. Il sera disponible d'ici la fin de l'année. Intel promet que cette puce Nervana ouvrira la voie à la création d'applications d'intelligence artificielle (IA) entièrement nouvelles, notamment dans les domaines de la médecine, de l'automobileautomobile, des réseaux sociauxréseaux sociaux ou encore de la météorologiemétéorologie. Le développement de Nervana s'est fait en partenariat avec Facebook qui investit beaucoup dans l'intelligence artificielle.

Nervana est moins précis dans les calculs... et c'est mieux

L'architecture de ce processeur présente trois spécificités censées optimiser le traitement du deep learning. Tout d'abord, il n'utilise pas de mémoire cachemémoire cache physiquephysique mais une mémoire gérée par un logiciel. Ensuite, Intel a mis au point un nouveau format numériquenumérique nommé Flexpoint qui offre moins de précision sur les nombres entiers et laisse passer davantage de « bruit » dans les données.

Comme l'explique Naveen Rao, vice-président du groupe produits d'intelligence artificielle et cofondateur de Nervana, les réseaux neuronaux peuvent exploiter ce bruit pour parfaire leur entraînement. La troisième spécificité de l'architecture Nervana concerne sur les interconnexions sur et autour de la puce qui sont censées produire un taux de transfert bidirectionnel très élevé. Mais Intel n'a fourni aucun détail précis sur les performances de ce nouveau processeur.

Ce qu’il faut

retenir

- Pour améliorer les performances des serveurs, Intel lance des processeurs équipés de leur propre intelligence artificielle.

- Ces puces ont pour mission d'accélérer le traitement des données, mais aussi de soulager le processeur principal.

- Facebook l'utilise déjà dans ses serveurs pour traiter les milliards de données de ses membres.