Lire dans les pensées et les retranscrire, voici ce qu’est capable de réaliser un modèle d’IA basé sur GPT1 d’OpenAI. Les chercheurs ont même été choqués par la précision et la justesse de ce décodeur.

au sommaire

Avec des IAIA toujours plus douées au fil des jours, se dirige-t-on véritablement vers la singularité énoncée par le futurologue Ray Kurzweil ? En tout cas, l'IA sait maintenant décrypter nos pensées. C'est l'expérience qu'Alexander Huth, un neuroscientifique et son coauteur Jerry Tang de l'Université du Texas à Austin (États-Unis) sont parvenus à réaliser avec un décodeur animé par une IA sur trois volontaires. L'IA est capable de traduire l'activité cérébrale et de transformer les pensées en un flux continu de texte. Concrètement, il suffisait que les volontaires écoutent ou imaginent une histoire en silence pour que l'IA puisse la reconstruire avec une précision étonnante.

Interpréter la pensée de certaines zones du cerveaucerveau, cela se fait déjà, mais ici la grosse différence est que pour les relever il n'y avait pas besoin d'implanterimplanter des capteurscapteurs chirurgicaux dans le crânecrâne comme c'est généralement le cas. Les données d'analyse utilisées provenaient tout simplement d'un système d'Imagerie par résonance magnétique fonctionnelle (IRMfIRMf). Avec ce décodeur, cela vient décupler la capacité d'analyse des données IRMf. Le problème de ce dernier est qu'il y a une sacrée latence pour capter l'activité cérébrale à un emplacement spécifique avec une haute définition. L'IA a encore une fois réussi le tour de force d'accélérer cette lecture qui est habituellement difficile. À l'issue de leurs expérimentations, les chercheurs se sont dits «choqués » autant qu'« excités » par la qualité des retranscriptions obtenues grâce à cette IA.

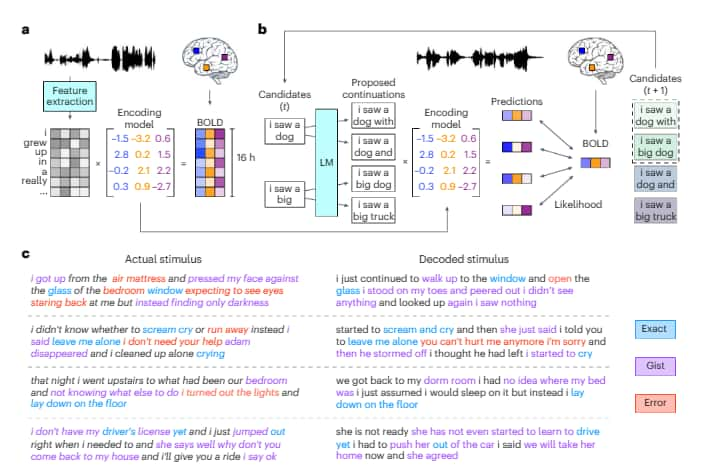

À gauche, l’histoire entendue ou générée par le volontaire. À droite, l’interprétation qu’en fait l’IA de GPT1 intégrée au décodeur. © Université du Texas, Nature

Impressionnant de précision

Avec les grands modèles de langage de type GPT, d'OpenAI, cela a permis de savoir quels types d'activités neuronales pouvaient correspondre à des chaînes de mots ayant une signification particulière plutôt que d'essayer de lire l'activité mot par mot. L'apprentissage ne s'est pas fait tout seul. Il a fallu que les trois volontaires restent allongés dans un scanner pendant 16 heures chacun, en écoutant des podcasts. C'est sur cette base que l'IA a été entrainée pour faire correspondre l'activité cérébrale au sens des histoires relatées dans les podcasts.

Le modèle de langage employé est l'un des ancêtres de ChatGPT, il s'agit de GPT-1. Avec lui, alors que les participants écoutaient une histoire ou en imaginaient une, environ une fois sur deux, le texte correspondait étroitement ou même de façon précise au sens des mots originaux. Attention, il ne s'agit certes pas des mots exacts, mais du sens. Mais le décodeur a quelques difficultés dans certains cas, notamment pour les genres ou dans d'autres cas précis linguistiques. Des problèmes étranges que les chercheurs ne parviennent pas encore à expliquer. Autre particularité, le modèle est en réalité sur mesure puisque, s'il est testé sur un autre participant, il retranscrit très mal les pensées.

Pour les scientifiques, ce type de décodeur pourrait servir pour restaurer la parole chez les patients qui ont du mal à communiquer en raison d'un AVC ou d'autres maladies cérébrales.