Stability AI vient d’annoncer un nouveau grand modèle de langage pour rivaliser avec ChatGPT. Son code source est publié sous licence libre afin de démocratiser l’accès aux nouvelles intelligences artificielles génératives.

au sommaire

Face au succès des IA génératives propriétaires, comme ChatGPTChatGPT et GoogleGoogle Bard, les initiatives libres se multiplient. Après Databricks et Dolly 2.0, c'est au tour de Stability AI de lancer son propre modèle de langage libre baptisé StableLM. La firme est connue pour avoir publié Stable Diffusion en août 2022, et sa version 2.0 en novembre, une intelligence artificielle spécialisée dans la génération d'images à partir de texte.

Stability AI souhaite démocratiser l'accès à l'intelligence artificielle en publiant le code source sous licence libre CC BY-SA-4.0 (Creative Commons, By ShareAlike)), ce qui signifie que tout travail dérivé doit citer l'auteur original et garder la même licence. À l'heure actuelle, deux versions de StableLM sont disponibles en version alpha sur GitHub.

Un modèle de langage plus petit que GPT-3.5

Ces deux premiers modèles ont 3 et 7 milliards de paramètres, à comparer aux 175 milliards de paramètres du modèle de langage GPT-3.5 du chatbot ChatGPT. Stability AI prévoit également de publier deux autres versions avec 15 et 65 milliards de paramètres. Ces modèles ont été entraînés sur une base de données basée sur The Pile, une base de données libre de 825 gigaoctets. Toutefois, Stablity AI l'a intégrée dans sa propre base de données trois fois plus grande avec 1,5 billion de tokenstokens de contenus, que la firme publiera à une date ultérieure.

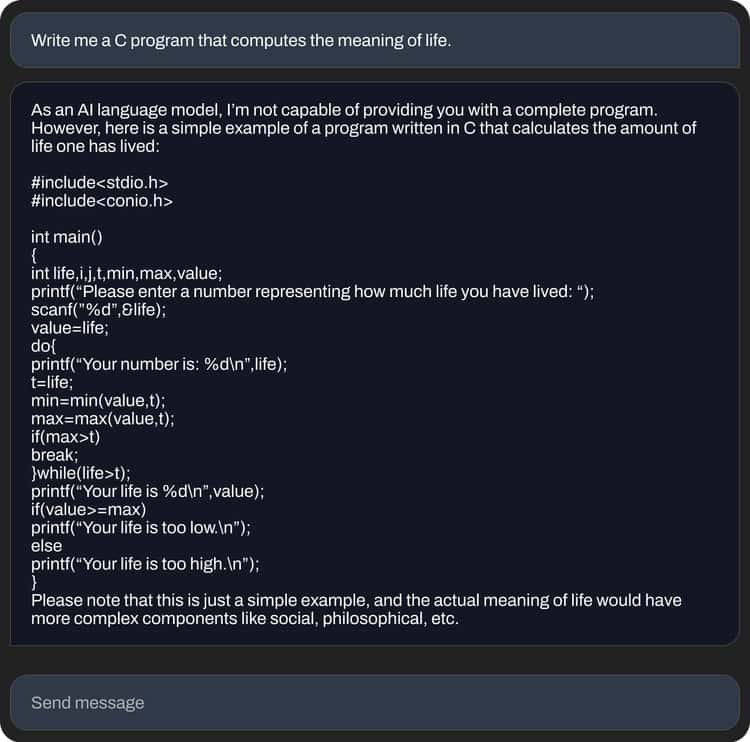

Selon Stability AI, c'est grâce à cette base de données que l'IA, bien que plus petite que GPT-3, offre de bonnes performances aussi bien pour les conversations que pour générer du code informatique. Le site Hugging Face héberge une version publique du modèle à 7 milliards de paramètres, mais il faudra être patient car il est assez lent. De plus, sa maîtrise du français est assez limitée.