La tête robotisée Emo est capable d’identifier une expression faciale avant qu’elle ne soit marquée sur le visage et d’y répondre avec son équivalent. C’est un grand pas vers l’ajout de la communication non verbale aux robots humanoïdes.

au sommaire

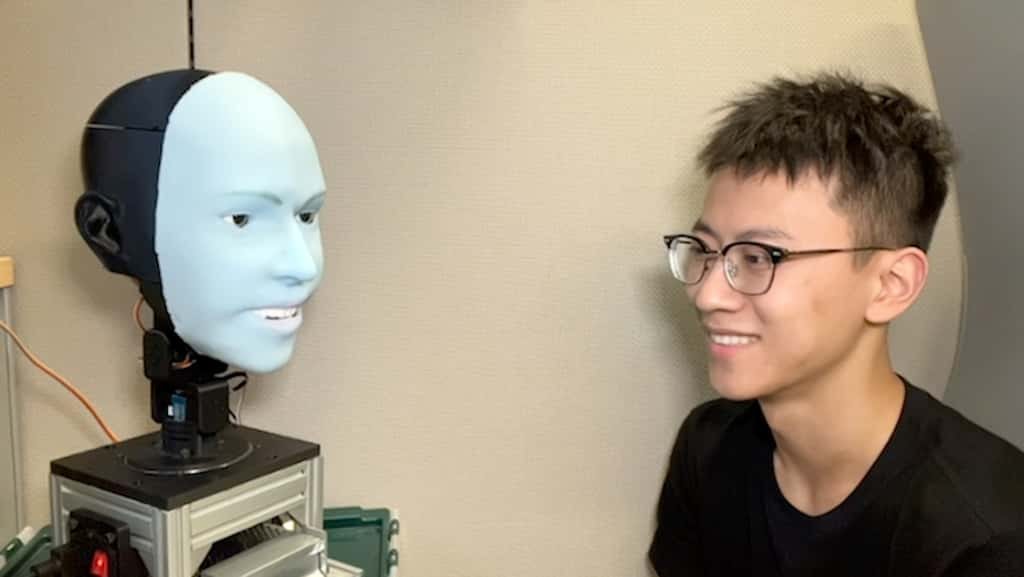

Avec son visage de siliconesilicone bleu, la tête robotisée humanoïde d'Emo est un brin inquiétante. Mais si on lui sourit, Emo réagit immédiatement en rendant lui aussi ce sourire. Mise au point par des chercheurs du Creative Machines Lab de ColumbiaColumbia Engineering de l'université de Columbia aux États-Unis, cette tête vient apporter sa pierre au développement de la communication non verbale des robots.

Aujourd'hui, les grands modèles de langage (LLM), comme ChatGPT, permettent aux robots d'être assez bons en communication verbale. Mais pour établir une confiance plus humaine, il leur manque toujours l'interprétation et la réponse appropriée des expressions faciales. C'est justement ce pour quoi Emo a été entrainé.

Pour y répondre, les chercheurs ont créé un visage expressif et polyvalent, avec toute une machinerie permettant d'animer la peau de silicone. En tout, 26 actionneurs lui confèrent toute une gamme de nuances d'expressions. Il a également fallu apprendre au robot quel type d'expression générer au bon moment pour paraître naturel, face à l'attitude de son interlocuteur. Pour cela, deux caméras se trouvent dans les yeuxyeux pour pouvoir cerner l'expression faciale d'une personne. C'est à partir de ce moment que l'IAIA entre en œuvre.

Parler avec un robot, comme avec un ami

Pour apprendre à Emo à générer des expressions faciales, les chercheurs l'ont laissé effectuer des mouvementsmouvements de visage aléatoires, face à des modèles et une caméra. Au bout de quelques heures, le robot avait pu cerner quelles commandes permettaient de reproduire les expressions qu'il voyait. D'autres entrainements à partir de vidéos ont également aidé Emo à prédire les expressions faciales des personnes à partir de petits détails sur le visage.

L’apprentissage du robot passe par une phase de « grimaces » pour qu’il puisse contrôler les bons actionneurs afin de marquer une expression. © Université de Columbia

De cette façon, le robot a pu prédire un sourire humain environ 840 millisecondes avant qu'il ne se produise. Il a alors pu simultanément répondre avec l'un des siens. En mixant cette communication non verbale avec un LLM, les chercheurs comptent maintenant créer un robot capable de plus d'empathieempathie et d'authenticité dans ses interactions. Avec les progrès actuels en matièrematière de robotique humanoïde, les LLM et ce type de procédé, la création d'un robot androïde - comme Data dans la saga Star Trek - se rapproche à grands pas.