Un robot-aspirateur Roomba a enregistré les images d'une femme dans les toilettes et elles se sont retrouvées publiées sur Facebook. À qui la faute ?

au sommaire

Une photo d'une jeune femme portant un t-shirt, assise sur la cuvette des toilettes et avec le short baissé jusqu'à mi-cuisse... Ce cliché, de mauvaise qualité, avec beaucoup de grain, fait partie d'un lot d'une quinzaine d'autres que le MIT Technology Review (MIT)na pu consulter sur des groupes de médias sociaux pourtant fermés. Tous ces clichés ont pour point commun qu'ils ont été capturés au ras du sol. Et pour cause, ce n'est pas une personne qui les a prises, mais un robot aspirateuraspirateur Roomba J7 d'iRobot, le plus grand fournisseur de ce type d'appareil.

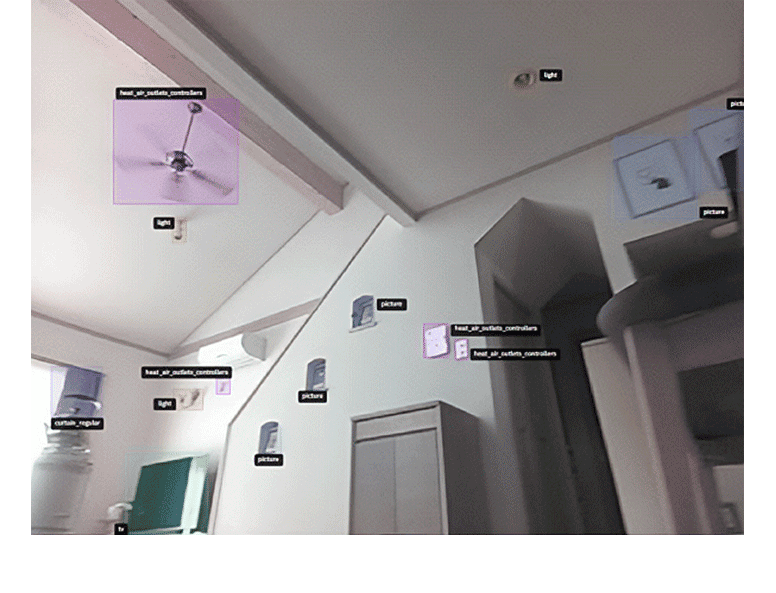

Alors comment ces photos prises par des aspirateurs se sont-elles retrouvées sur des réseaux sociauxréseaux sociaux, aussi privés soient-ils ? Et d'abord, pourquoi ces aspirateurs prennent-ils des photos ? Comme pour la grande majorité des accessoires dits intelligents, le constructeur vient collecter de nombreuses données. Elles servent à nourrir l'algorithme d'apprentissage automatique de l'Intelligence artificielle. C'est elle qui vient améliorer les services et les capacités de l'appareil. Dans le cas d'un robot aspirateur, les capteurscapteurs sont nombreux et il y a même des caméras intelligentes embarquées sur le Roomba J7. Le robot peut envoyer des images, des voix, des visages, des géolocalisations, des plans des habitations et tout un tas d'autres informations personnelles.

Cela n'a qu'un but : entrainer les algorithmes. Généralement, cette collecte est précisée dans la politique de confidentialité que personne ne prend le temps de lire. Dans ce cas précis, ces photos ne proviennent pas des robots commercialisés, mais de modèles de développement utilisés par les employés et testeurs rémunérés par la marque.

Des humains pour labelliser les données collectées

L'affaire daterait de 2020 et ces personnes avaient signé des accords écrits reconnaissant qu'ils renvoyaient des flux de données, y compris des vidéos, à l'entreprise. Autrement dit, cette collecte particulière ne concerne pas les clients de la marque. C'est un début d'explication, mais cela ne justifie pas le fait que ces photos se soient retrouvées par la suite sur des réseaux sociaux. Ces données sensibles sont parties des réseaux domestiques de foyers en Amérique du Nord, en Europe et en Asie pour être stockées sur les serveurs d'iRobot au Massachusetts (États-Unis).

“C’est la seule façon pour apprendre à l’IA à reconnaitre son environnement et à identifier un câble qui traîne ou une chaussette, par exemple”

Mais, selon le MIT, certaines de ces données ont été envoyées à un sous-traitant de San Francisco appelé Scale AI. Sa mission consiste à faire analyser les données par des humains pour leur donner des étiquettes de description. C'est la seule façon pour apprendre à l'IA à reconnaitre son environnement et à identifier un câble qui traîne ou une chaussette, par exemple. Or, face aux montagnes de données, il se trouve que Scale AI utilise des sous-traitants dans le monde entier. Parmi eux, des travailleurs vénézuéliens, sous contrat, ont publié ces photos des groupes privés sur des réseaux sociaux comme FacebookFacebook, ou encore DiscordDiscord. La fuite ne provient donc pas du tout d'une faille de sécurité, mais d'un maillon faible dans la chaîne de sous-traitance de la marque.

Le problème, c'est que iRobot a déclaré au MIT avoir partagé à ses sous-traitants plus de deux millions de clichés pris par le Roomba. Si cette histoire est arrivée pour des données provenant d'appareils de développement, cela pourrait être aussi le cas pour l'aspirateur de n'importe quel client. Il faut dire qu'il est inconcevable pour les utilisateurs qu'un humain puisse les observer par le truchement de leur aspirateur. À la suite de cette enquête du MIT, iRobot a expliqué que la marque avait mis fin à sa collaboration avec la société dont les employés avaient divulgué les images. Reste que l'intervention d'humains est la seule possibilité pour pouvoir améliorer les IA.