Alors que l’accès aux IA développées par OpenAI est bloqué en Russie, les hackers du pays se retrouvent sur des forums pour se donner des astuces leur permettant d’y accéder.

au sommaire

Comme Futura l'évoquait hier, les hackers testent actuellement les capacités de ChatGPT pour générer du code malveillant. Différents types de scripts créés par l'intelligence artificielle ont déjà été découverts sur les forums de hackers du Darknet par les experts de la société Check Point. Pour le moment, ils n'en seraient qu'aux balbutiements et ces scripts sont encore loin de faire partie de l'arsenal des cyberattaques les plus sophistiquées. En revanche, c'est une tout autre découverte autour de ChatGPTChatGPT qu'a soulevée Check Point. En fouillant dans les forums, les chercheurs en cybersécurité ont identifié des échanges animés par des hackers russes. Leurs interrogations tournaient autour de la problématique d'accès au chatbot à partir du territoire russe.

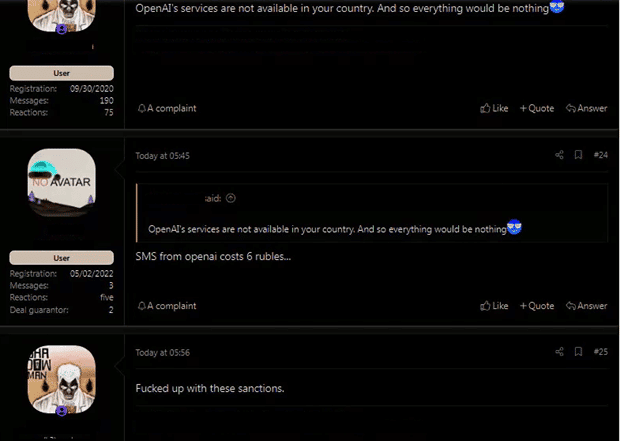

Les hackers cherchent à contourner le blocage en Russie

Dans un sujet de discussion sur l'utilisation de ChatGPT pour générer un malware, les hackers partageaient des informations sur la façon de contourner les blocages géographiques pour pouvoir exploiter l'IA dans la création de code malveillant. Le contournement de ces géorepéragesgéorepérages n'est pas compliqué à réaliser de l'aveu même du porteporte-parole de Check Point. Ainsi, les hackers expliquent comment ils pourraient accéder au service en payant pour acheter des comptes d'utilisateurs existants. Évidemment pour payer, ils imaginent d'utiliser les données de cartes bancaires dérobées. Mais pour créer un compte, il faut nécessairement utiliser un numéro de téléphone. Les interlocuteurs ont donc évoqué l'utilisation d'un service de génération de SMS russe qui pourrait passer les différentes mesures de blocage.

ChatGPT : des hackers l'utilisent déjà pour créer des malwares

Les pirates n'ont pas tardé à utiliser ChatGPT à des fins malveillantes, comme viennent de le découvrir les experts de la société de cybersécurité Check Point.

Article de Sylvain BigetSylvain Biget, publié le 17/01/2023

Depuis qu'il s'est ouvert au grand public au début du mois de décembre, ChatGPT est présenté comme la prochaine révolution d'InternetInternet. Le chatbot amuse, impressionne et est régulièrement poussé dans ses retranchements. On sait désormais qu'il sait mentir avec aplomb, mais ce que l'on découvre également, c'est qu'il peut aussi œuvrer du côté obscur.

La société de cybersécurité Check Point Research a découvert que l'IA d'OpenIA a été utilisée par des hackers pour concevoir du code malveillant. Les chercheurs avaient préalablement testé ChatGPT pour créer toute une chaîne de piratage, à commencer par un mail de phishingphishing incitatif, pour ensuite injecter du code malveillant. L'équipe est partie du constat que, s'ils avaient eu cette idée, les cybercriminels aussi.

En poussant leur analyse sur les grandes communautés de hackers, ils ont pu confirmer que des premiers cas d'utilisation malveillante de ChatGPT sont en cours. L'avantage, c'est qu'il ne s'agit pas des hackers les plus expérimentés, mais de cybercriminels qui n'ont pas spécialement de compétences en développement. Autant dire qu'il ne s'agit pas de créations de malwares sophistiquées, mais étant donné le potentiel, il se pourrait bien que l'IA soit bientôt utilisée dans des développements d'outils de piratage avancés.

Sur les forums des pirates, les participants testent activement ChatGPT pour recréer des malwares. Les experts du labo ont ainsi décortiqué un script créé par ChatGPT qui vient rechercher des formats de fichiers courants sur un disque durdisque dur et qui va les copier, les compresser et les envoyer vers un serveurserveur contrôlé par les pirates.

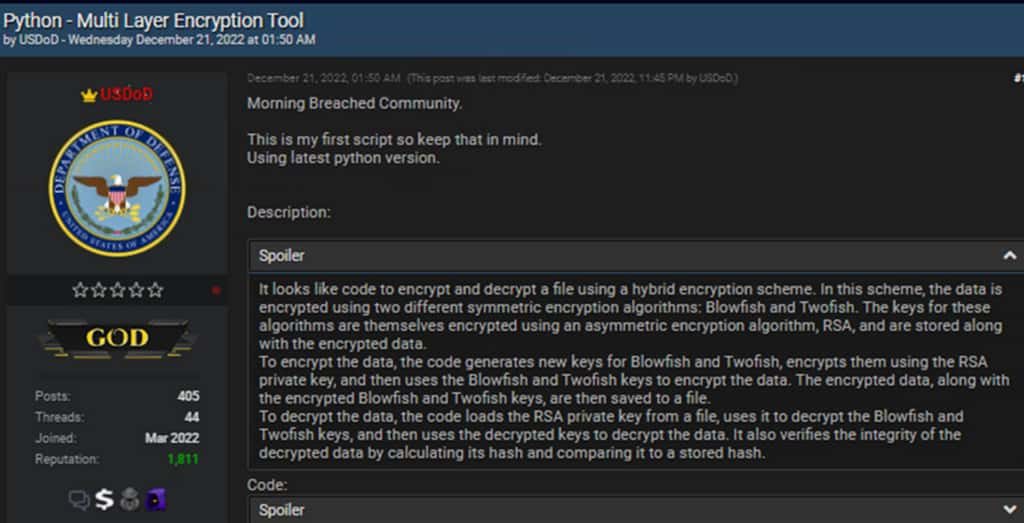

Les pirates détournent ChatGPT

Dans un autre exemple, un code JavaJava permettait de télécharger un client réseau et de forcer son exécution via la console d'administration de Windows. Le script pouvait alors télécharger n'importe quel malware. Mais il y a plus poussé, avec la rédaction d'un script PythonPython qui sait faire des opérations de chiffrementchiffrement complexe. Sur le principe, la création de ce code n'est ni bien ni mal mais, sur un forum de hackers, on peut légitimement supposer que ce système de chiffrement pourrait être intégré à un ransomware.

Enfin, les chercheurs ont aussi pu constater des discussions et des tests qui détournaient ChatGPT, non pas pour générer du code malveillant, mais afin de créer une plateforme de commerce automatisée illicite pour le Dark Web. Globalement, ce qui ressort de ces enquêtes, c'est que les cybercriminels font un peu comme tout le monde dans tous les domaines avec le chatbot de ChatGPT. Ils discutent et testent l'IA pour vérifier en quoi elle pourrait les aider et si ses performances sont utiles pour accomplir leur funeste besogne.

De son côté, comme n'importe quel programme informatique, l'IA ne fait que ce qu'on lui demande de faire. Elle ne le fait d'ailleurs pas forcément bien, comme peut en témoigner une étude de l'Université de Stanford aux États-Unis. Ses conclusions montrent que, lorsque les développeurs utilisent des IA pour rédiger du code, celles-ci ont tendance à générer des failles. Elles n'existeraient pas forcément si un humain l'avait composé.