Les 125 membres des Nations unies se réunissent jusqu'à demain à Genève pour poser les bases d'une réglementation sur les systèmes d'armes létales autonomes, les fameux robots tueurs. Il n'est clairement plus question de les interdire. Comme lors de la dernière tentative, le consensus est loin d'être atteint et les doctrines militaires autour de l'utilisation de ces armes diffèrent selon les pays.

au sommaire

Robot chien armé d'un fusil d'assaut, scientifique iranien éliminé grâce à une arme robotisée, essaim de drones tueurs, les exemples récents ne manquent pas pour alimenter le débat sur les systèmes d'armes létales autonomes (SALA), autrement dit les robots tueurs. Il y a deux ans (voir ci-dessous), à l'ONU, la mise en place d'un traité international interdisant l'usage d'armes létales autonomes avait été bloquée par une minorité de pays. Cette année, les membres des Nations unies se retrouvent à nouveau à Genève en jusqu'à demain 17 décembre pour plancherplancher sur le sujet.

Si les 125 membres s'accordent à dire qu'il faut appliquer un cadre légal à leur utilisation, il n'est désormais plus question de les interdire, puisqu'ils sont déjà exploités parfois de façon opérationnelle par certains membres. Personne ne se fait d'illusion sur la mise en place d'un véritable traité cette année, mais les États espèrent que des bases seront néanmoins posées pour l'avenir. Mais, comme lors de la dernière séance, ce sont toujours les mêmes pays qui traînent les pieds sur ce règlement. Ainsi l'Inde, la Russie qui teste des robots de combat en Syrie, et les États-Unis qui ne souhaitent pas de réglementation contraignante, devraient à nouveau empêcher tout consensus.

Des robots tueurs non-décideurs

En France, le comité d'éthique de la défense a déjà donné son avis. Ses membres ne souhaitent pas que l'armée exploite des systèmes d'armes létales totalement autonomes. En revanche, ils ne s'opposent pas aux armes robotisées, pilotées par des opérateurs humains. On a d'ailleurs pu voir le robot-chien Spot de Boston Dynamics évoluer auprès des soldats français au cours d'exercices. La France a même renommé les SALA en SALIA, pour « Systèmes d'armes intégrant de l'autonomie ».

C'est également la doctrine d'autres pays, comme l'Australie, Israël, la Turquie, la Chine et la Corée du Sud, qui développent également leurs propres systèmes d'armes létales autonomes.

De son côté, l'ONG Human Rights Watch, à l'origine de la campagne Stop Killer Robots, indique que ces armes finiront par tomber dans de mauvaises mains avant même qu'une éventuelle réglementation soit un jour fixée. Contrairement à la lenteur de la mise en place d'un cadre légal, la course technologique se poursuit et les robots s'améliorent très rapidement. Pour eux, lorsque leur prix sera suffisamment bas, le risque est important de les retrouver comme arsenal de guérilla dans des organisations terroristes ou dans certaines dictatures afin de mener des assassinats ciblés.

Armes létales autonomes : faut-il interdire les robots tueurs ?

Aux Nations unies, quelques pays viennent de bloquer la mise en place d'un traité d'interdiction des Systèmes d'armes létales autonomes, ou SALA. Les robots tueurs peuvent donc poursuivre leur développement avant d'arriver sur le champ de bataille. La communauté scientifique est inquiète et les ONG multiplient les appels pour imposer ce traité. Et si la solution consistait à donner une morale aux robots ?

Article de Sylvain BigetSylvain Biget, publié le 15/12/2019

Après une semaine de réunion au bureau des Nations unies à Genève (Suisse), la mise en place d'un nouveau traité international interdisant l'usage d'armes létales autonomes a été bloquée par une minorité de pays (Australie, Corée du Sud, États-Unis, Israël et Russie). Au final, sur ce sujet, seules une vingtaine de recommandations, non contraignantes, ont été adoptées à l'issue de la réunion, dans la nuit de vendredi à samedi derniers. Elle s'est surtout consacrée à reconduire le mandat actuel du groupe d'experts gouvernementaux.

L'Allemagne et la France ont simplement proposé de maintenir le principe de contrôle humain sur l'usage de la force, alors que le président Emmanuel Macron s'était déjà « catégoriquement opposé »aux armes létales entièrement autonomes.

Mais seul un traité peut protéger l'humanité contre ces robots tueurs, et celui-ci est loin d'être sur les rails. D'ailleurs, l'Australie, la Corée du Sud, les États-Unis, Israël et la Russie s'opposent à toute proposition de traité pour le moment.

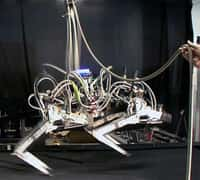

Avec sa taille volumineuse, le très agile Big Dog de Boston Dynamics a déjà fait l’objet de nombreuses expérimentations aux côtés des soldats de l’armée américaine. Il n’est pas opérationnel en raison du volume sonore émis par sa motorisation, mais la firme a développé d’autres robots quadrupèdes plus discrets et aux performances étonnantes. © Boston Dynamics

Faut-il un code éthique chez les robots tueurs ?

Les SALA, ou robots tueurs, sont déjà expérimentés depuis des années. Futura évoque régulièrement les prototypes de Boston Dynamics. La firme développe depuis plus de vingt ans des robots dédiés à la guerre. Des robots qui se déclinent en machines bipèdes, quadrupèdes aux capacités impressionnantes. Qu'il s'agisse de ces robots particuliers, de drones autonomes ou de véhicules armés sans occupants, l'arrivée d'un « Terminator » programmé pour tuer de façon autonome et froide des cibles prédéfinies n'est désormais plus du domaine de la science-fiction. Ce genre de robot de combat pourrait débarquer sur les champs de bataille d'ici quelques années aux côtés des troupes, ou à leur place. Et surtout, l'absence de réglementation en la matièrematière va fatalement engendrer une course aux armements une fois que les premiers modèles de robots de combat seront véritablement opérationnels.

Pour l'ONG Human Rights Watch, à l'origine de la campagne Stop Killer Robots, l'arrivée de ces armes est dramatique. Selon elle, des dictateurs ou des terroristes pourraient en disposer assez facilement et à bon prix pour contrôler ou exterminer des populations. Ils pourraient également ordonner aux machines des assassinats ciblés. L'ONG n'est pas la seule à mobiliser les consciences sur ces robots tueurs. Le 18 juillet dernier, des ténors de l'universunivers de la high-tech, dont Elon Musk, ont mis en garde les pays membres des Nations Unies contre ces armements. Les signataires craignent que leur utilisation dans les conflits vienne dépasser l'échelle de la compréhension humaine.

Ces réactions sont loin d'être les premières. Chaque année, depuis 2014, ce genre de message est adressé aux Nations Unies. En vain. Dès les prémices de ces évolutions techniques, des personnalités notoires des sciences, à commencer par Stephen Hawking, Max Tegmark, Stuart Russell ou Frank Wilczek, y ont exposé leurs craintes contre le potentiel danger de l’IA.

Si aucun accord ne peut les interdire, une des solutions pourrait consister à les humaniser, pour qu'elles se comportent de façon « morale » sur les champs de bataille. Il s'agirait de les doter d'un code de valeurs propre aux combattants. C'est d'ailleurs ce que préconise le lieutenant-colonel de l'armée française Brice Erbland dans son ouvrage Robots tueurs, aux éditions Armand Colin. Il montre ce que pourrait être un SALA doué d'une IAIA pouvant faire preuve de suffisamment de discernement pour se comporter comme des soldats. Autrement dit, ces robots autonomes de combat devraient intégrer une éthique artificielle. On ne parlerait alors plus de SALA, mais plutôt de SALMA (Systèmes d'armes létaux, moralement autonomes).

Cependant, pour que cela soit le cas, il faudrait que tous les États jouent le jeu. En attendant, ils restent majoritairement d'accord sur la nécessité de maintenir un contrôle humain sur les systèmes d'armes létaux autonomes. C'est pourquoi la grande majorité des 88 États membres souhaitent qu'un nouveau traité soit proposé en 2019.

Ce qu’il faut

retenir

- Plusieurs pays entravent le projet d'une interdiction des robots tueurs autonomes.

- La communauté scientifique ainsi que l'ONG Human Rights Watch mettent en garde les États contre l'utilisation de ces armes qui pourraient échapper à tout contrôle.