au sommaire

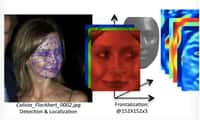

Trois programmes d'analyse faciale commercialisés par de grandes entreprises technologiques présentent des biais fondés sur le type de peau et le sexe. C'est ce qu'affirme une équipe de chercheurs du Massachusetts Institute of Technology et de l'université de Stanford (États-Unis) dans un article scientifique qui sera prochainement présenté lors de la conférence Fairness, Accountability and Transparency.

L'étude a porté sur trois logiciels d'analyse faciale généralistes conçus par IBM, Microsoft et Face++. Et le verdict est sans appel. Le taux d'erreurs pour déterminer le sexe d'un homme à la peau claire n'excède pas 0,8 %. En revanche, il passe à plus de 34 % quand il s'agit de déterminer le sexe d'une femme à la peau sombre.

Des risques d’erreurs et d’injustices

La démonstration n'a pas pour but de dénoncer une forme de ségrégationségrégation intentionnelle de la part des concepteurs de ces programmes. Il s'agit de souligner le manque de diversité des données qui sont utilisées pour entraîner les algorithmes. En effet, si une base de données sur laquelle s'appuie un logiciel de reconnaissance faciale contient plus de visages d'hommes blancs que de femmes noires, le système aura nécessairement plus de mal à reconnaître ces dernières.

Pour les chercheurs, des efforts de transparencetransparence et de responsabilité sont indispensables pour changer cette situation. En effet, les techniques d'apprentissage automatique (machine learningmachine learning) qui servent à distinguer le sexe d'une personne à partir d'une photo sont appliquées à de nombreux domaines de la vision informatique et de l'intelligence artificielle. La reconnaissance faciale, notamment à des fins policières, en fait partie. Mais c'est aussi le cas de l'analyse prédictive sur laquelle s'appuient des outils de recrutement, de santé, des banques ou des organismes de crédit pour accorder des financements. Les risques d'erreurs et d'injustices graves sont bien réels.