au sommaire

II. La construction sociale du problème (5ème partie)

2. De Stockholm à Rio : l'émergence de la « crise environnementale » (suite)

2. L'apparition de nouveaux risquesDans les pays industrialisés, la "crise environnementale" n'est pas prioritairement perçue comme une surconsommation de ressources, mais comme l'apparition de risques qualitativement nouveaux. Le rapport du MIT au Club de RomeClub de Rome a sans doute fait grand bruit, mais il a eu de fait peu de conséquences. Le travail de N. Georgescu-Roegen sur la décroissance inéluctable des économies, au point de vue matériel, n'a eu qu'une diffusion confidentielle.

La liste des catastrophes ayant entraîné un changement qualitatif dans la prise en compte des risques liés à l'industrie est connue : les accidentsaccidents de MinamataMinamata (1959), le naufrage du Torrey Canyon (1967), l'explosion d'une usine chimique à Seveso en 1976, l'Amoco-Cadiz s'échouant sur les côtes bretonnes en 1978, l'accident nucléaire de Three Miles Island en 1979, l'explosion de l'usine chimique de d'Union Carbide à BhopalBhopal (1984), la fusion du réacteur de Tchernobyl et le survolsurvol de l'Europe par un nuagenuage radioactif (1986), l'Exxon Valdez en Alaska en 1989, l'usine AZF à Toulouse (2001) etc.

De Stockholm à Rio, nous assistons donc à une multiplication des risques et des définitions de "risque". Différentes urgences, différentes causes, différents conflits, et donc différents "accusés". Si les coûts des dommages explosent avec l'ampleur des catastrophes, les types de dommages sont eux aussi très nouveaux : il ne s'agit pas seulement de morts ou blessés humains, mais de dégradations graves et irréversibles de l'environnement, naturel et humain. Avec Tchernobyl, c'est une zone de dizaines de milliers de kilomètres carrés qui est rendue inhabitable, l'apparition de malformationsmalformations monstrueuses, et des centaines de milliers de cancerscancers en cours et bien davantage à venir.

En première approximation, on peut le définir comme "danger potentiel", ou "danger éventuel plus ou moins prévisible" (Robert). Ce peut être un danger probable, au sens mathématique ou non. Le danger est une menace sur la sûreté ou l'existence d'une personne ou d'une chose, une menace sur son intégritéintégrité. La menace implique donc un jugement de valeur, une qualification. La gravité de la menace est un aspect critique de cette qualification.

Dans la majeure partie des cas, le risque se "gère" et on évite les "maux" considérés comme inacceptables, socialement ou individuellement. La mort est de toute évidence un risque qu'on gère, que le risque soit causé directement par la main de l'homme (erreur etc.) ou par le comportement des artefacts (vieillissement des pièces etc.). Il y a donc un aspect politique et organisationnel. Pour n'importe quelle situation dans n'importe quel lieu, on peut en principe déterminer un ensemble d'événements dont il est raisonnable de penser qu'ils peuvent se produire - on construit ainsi le "possible" -, et on peut attacher à chacun d'entre eux une probabilité d'occurrence et une évaluation de la gravité du danger.

Les risques sont socialement construits : les jugements de valeur sont consubstantiels à ce concept, et ont une part de relativité culturelle. Cela qui ne signifie pas qu'ils puisse se réduire à l'expression d'une subjectivité : c'est avec des éléments du monde réel et matériel qu'ils sont construits, et non dans la pure volonté. Les risques prévisibles ou probabilisables sont en général inscrits dans la réglementation, par exemple sous la forme de critères "d'acceptabilité". On peut d'ailleurs faire des typologies de différents risques : les risques mettant en cause des personnes ou des choses connues ou inconnues, des risques proches ou lointains, locaux ou globaux etc. Les questions de l'espace (local, régional, global), du temps (risque à court terme, moyen terme, long terme), de la gravité (qu'est-ce qui est menacé, quelle est sa valeur, comment est-il menacé), et de l'identifiabilité (tangible, non-tangible, mesurable - identifiable par qui, etc.) sont sans doute les principaux déterminants d'une typologie des risques.

Une situation non-déterministe implique que les conséquences d'une action ne soient pas connues avec certitude et exactitude, mais puissent suivre différents chemins. Il y a donc incertitude. Cette incertitude peut parfois être ramenée à un jeu de probabilités. A la suite d'une action, par exemple le lancer d'un dé, chaque événement se voit affecté d'une probabilité : chaque numéro a 1 chance sur 6 d'être tiré. Mais il n'est pas toujours possible de réduire le problème à un tel jeu de probabilité, en particulier dans les situations faisant intervenir des êtres humains ou des êtres vivants, dont l'histoire prédétermine le comportement selon des "lois" qui ne sont pas mathématisables.

La connaissance des conséquences implique alors la mise au point d'une gamme de scénarios, une série d'histoires ou d'images du monde futur et des chemins qui y mènent. A la manière d'une enquête policière, le prospectiviste collecte des éléments statistiques, des "tendances" ou encore des éléments ayant trait au comportement du milieu naturel, et s'efforce de tracer différents chemins possibles pour l'action intentionnelle. On peut ainsi déterminer des fréquences d'occurrence de certains événements, ou encore le lieu de l'occurrence. L'enceinte hermétique d'un laboratoire pharmaceutique a ainsi pour fonction de confiner au mieux les risques dans un milieu qui est conçu empêcher leur propagation. De même, les rond-points créent davantage d'accidents de la route, mais de moindre gravité, que les systèmes utilisant les feux tricolores : c'est un fait issu de l'observation et de la statistique.

L'expérience et le "sens commun", au sens de capacités cognitives apprises et transmises culturellement, permettent ainsi de connaître les réactions "habituelles" du milieu - naturel et humain. Le risque est le plus souvent localisable (nul ne sera électrifié s'il ne s'approche de fils électriquesfils électriques) et son occurrence est évaluable (presque 100% de chances de se faire électrifier en mettant les doigts dans la prise d'une maison habitée). Il existe en général des moyens de réduire les risques et même de les réduire à zéro (ne pas avoir l'électricité chez soi).

La définition des rôles sociaux et en particulier des professions inclut une maîtrise du risque dans l'activité considérée. L'électricien est moins pardonnable qu'un simple particulier s'il provoque un court-circuitcourt-circuit et fait brûler la maison de son client. On attend d'un professionnel qu'il sache "gérer" le risque, soit qu'il se produise là où le professionnel le prévoit, et qu'il fasse en sorte que les conséquences soient acceptables, soit qu'il fasse en sorte qu'il n'y ait pas d'occurrence des événements indésirables. Le client doit pouvoir compter sur l'électricien : la définition des responsabilités vaut promesse.

Notons enfin que les risques auxquels nous nous intéressons sont les risques sur lesquels l'Homme a un certain pouvoir, soit qu'il les crée soit qu'ils les combattent, et non les risques en général. Mais les controverses au sujet des risques laissent penser que la question de la séparationséparation entre risques imputables à l'Homme et risques imputables à la nature n'est pas si claire que cela : il y a une latitudelatitude dans l'imputation qui peut permettre au Destin d'entrer en ligne de compte. La controverse entre Rousseau et Voltaire à propos du tremblement de terretremblement de terre de Lisbonne en 1755 en témoigne : si Rousseau impute la fatalité naturelle, Voltaire s'en prend plutôt à l'emplacement imprudent des maisons.

C'est avec l'apparition de risques ne répondant plus à l'ensemble des critères habituels que le doute s'est installé.

Jusque-là, le champ couvert par l'étude des risques était constitué de pollutions locales (milieu urbain, fuites etc.), d'événements répétables et probabilisables (accidents de la route, sécurité etc.), et de risques d'explosion confinables (usines etc.). Et tout était essentiellement réversibleréversible, au sens où il suffisait d'éliminer la cause pour que le milieu reprenne les qualités qu'il avait avant l'incident. Les "nouveaux risques" sont d'une autre nature.

On voit ainsi naître à la fin des années 70 la catégorie du "Risque Technologique Majeur", prenant acte du fait que l'ampleur des dommages causés est nouvelle. Jusque-là, la gestion du risque industrielrisque industriel avait essentiellement consisté dans le confinement (éloignement des installations par rapport aux villes) et la réglementation avec contrôle administratif périodique (en France, les "installations classées"). Désormais, le risque technologique peut s'étendre bien au-delà de "l'usine", c'est-à-dire de la zone délimitée comme étant "à risques", dont l'accès était contrôlé, et dont les activités étaient surveillées par des représentants de l'autorité publique.

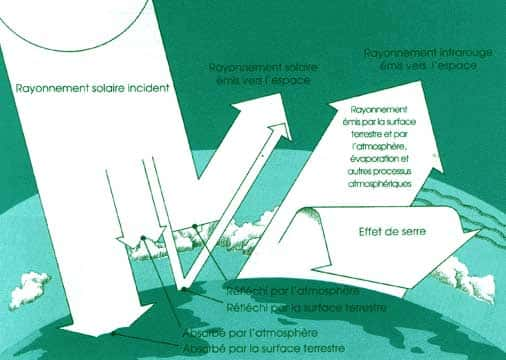

Au début des années 90, avec le "Risque Environnemental Majeur" on monte encore d'un cran dans l'ampleur et la gravité des conséquences possibles : il s'agit ici d'une catégorie de risques susceptibles de mettre en péril jusqu'à l'ensemble de la biosphèrebiosphère. Il s'agit donc de risques à l'échelle globale, tels que le changement climatiquechangement climatique ou la diminution de la couche d'ozonecouche d'ozone. Le risque est dit "majeur" «lorsque la pollution dépasse les capacités naturelles de résistancerésistance de l'être humain et / ou d'auto-épuration du milieu ». Autrement dit, lorsqu'il menace l'intégrité du corps naturel humain ou l'intégrité des milieux naturels: l'ordre naturel ne se rétablit pas, ou se rétablira à très long terme, a minima de l'ordre du siècle.

L'intégrité est l'état d'une chose qui a toutes ses parties. Une transformation réversible ne remet donc pas en cause l'intégrité de la chose. Avec l'atteinte irréversible, c'est l'intégrité qui est visée : la nature n'est plus exactement "la nature", mais une nature diminuée, amoindrie. La nature actuelle est alors un peu "moins" que la nature passée, de même qu'un homme malade est "un peu moins" qu'un homme en bonne santé.

Le concept d'intégrité pose de nombreux problèmes. Il suppose que l'on puisse identifier une chose "complète" qui servira de référence par rapport à laquelle on pourra juger qu'il y a atteinte à "l'intégrité" ou non. Mais quelle est la définition de cette chose "complète" ? Comment l'établir ? Sur quels critères justifier que la chose est bien "entière" ? Qui peut l'établir ? Nous reviendrons sur ce concept plus loin. Notons simplement ici que ce concept a été mobilisé par des acteurs en prise avec des enjeux politiques concrets, à l'instar du "Groupe de l'intégrité environnementale" dans les négociations sur le changement climatique, ou des organisations non-gouvernementales de protection de l'environnement.

Les nouveaux risques sont aussi spécifiques de par la lenteur avec laquelle se manifestent leurs effets. Dans le cas des CFCCFC (gazgaz chlorofluorcarbonés), qui réduisent la couche d'ozone, il a fallu quarante ans pour découvrir la dangerosité de ces produits, à quoi s'ajoutent les treize années nécessaires pour arriver à un début de réglementation (Montréal 1987). Cette lenteur est en partie liée à un cheminement très complexe des causes et des effets dans la nature. Leur trajet est largement inconnu, les conséquences maximales sont donc quasi-impossibles à prévoir, tant au niveau des effets directs sur l'homme (sanitaires ou non, par exemple évacuation d'un lieu ou interdiction de boire l'eau du robinet), ou sur les écosystèmesécosystèmes (dépassement de la capacité d'auto-épuration, concentration de polluants, modification de la biosphère), qu'au niveau des effets stochastiquesstochastiques : seuil d'apparition inconnu, période de latencelatence, extrême complexité des mécanismes mis en jeu, non-linéarité, problème de dilution des causes dans l'espace-tempsespace-temps, etc. La rationalité du risque environnemental majeur est par conséquent impossible à définir, faute de "réponse" claire de la nature, ce qui rend l'anticipation difficile. Par la même occasion, ils forcent à redécouvrir une nature qui s'avère beaucoup plus complexe que ce que l'on croyait jusque-là.

La lenteur induit en outre une grande distance entre responsables et victimes, ce qui rend leur traitement social et juridique difficile : comment trouver les "coupables" ? Comment condamner 20 ans après ? Comment qualifier le coupable, alors que le risque était si difficile à prévoir ? Peut-on invoquer "l'ignorance invincible" ? Le procès de Minamata va ainsi donner naissance à un nouveau type de preuve : la "présomption de causalité", en l'absence de preuve irréfutable. La question n'est pas anodine : il faut que soit désigné un responsable, qui n'est pas nécessairement un coupable, pour qu'existe un maillon à figure humaine dont le changement de comportement pourrait induire une cessation du dommage collectif. Sans cela, il est très difficile pour une société de répondre à un problème. Il en sera de même pour la nature : si on veut la protéger, il faut lui attribuer un porteporte-parole humain, avec tous les risques d'erreur que cela comporte, compte-tenu du caractère très parcellaire de nos savoirs sur la nature. Nous verrons ceci plus loin.

Ceci soulève en outre la question des limites de la nature humaine : jusqu'où est-on tenu de s'informer des conséquences possibles de notre action ? Peut-on invoquer "l'ignorance invincible" pour excuser l'auteur de l'acte incriminé ? Le droit fait référence au "bon sens", via l'exemple du comportement prudent du "bon père de famille" pour justifier de ce que l'auteur d'un dommage aurait du prendre comme précautions. Mais quelle est la latitude avec laquelle on peut interpréter ces concepts ? Ceci va peser lourd dans la résolutionrésolution collective des problèmes, dans les procès comme dans les négociations.

Les conséquences pour la philosophie de la nature sont immenses : désormais, la nature n'est plus invulnérable. Il devient évident que les transformations de la nature ne sont plus marginales et essentiellement anecdotiques par rapport à un ordre naturel que rien ne semblait pouvoir atteindre.

Aujourd'hui, ce sont les régulations fondamentales de la nature qui sont menacées : couche d'ozone, changement climatique, espècesespèces végétales et animales etc. Il y a menace sur l'intégrité de la nature car ces régulations ne sont pas reproductibles par l'artifice humain : une fois l'ordre dégradé, il y a irréversibilité, ce qui signifie que l'ordre ne se rétablit pas de lui-même, ni par une action humaine. Ces menaces mettent donc en jeu des échelles d'espace et de temps longues, voire quasiment infinies à l'échelle humaine. Bien entendu, il n'y a pas accord sur ce qui est menacé. Si tout le monde est d'accord pour dire que c'est l'intégrité de la nature qui est menacée, il y a désaccord sur les limites à poser pour établir ce qui constitue cette intégrité naturelle. Pour les uns, l'atteinte est massive, et la petite espèce vivante est à défendre, tandis que pour les autres l'atteinte n'est que minime, et la disparition de quelques espèces ne doit pas remettre en cause les pratiques habituelles. Nous y reviendrons plus loin. L'important ici est qu'une catégorie significative de personnes ait conçu cette éventualité comme entrant désormais dans le champ des possibles, du fait de l'accroissement de l'échelle de l'action humaine dans la nature.

Les négociations cherchent donc à établir corrélativement les limites de l'intégrité naturelle, sur la base de quoi on pourra ensuite tracer les limites du patrimoine naturel, et les limites de l'usage que l'on peut faire de ce patrimoine : les deux dimensions sont liées, puisque ce qui ne rentre pas dans le patrimoine est appropriable et destructible tandis que ce qui y entre doit être protégé. La question de l'intégrité naturelle a donc à voir avec la question de l'éthique. Si aujourd'hui il est dans le pouvoir humain de détruire ce qu'hier il lui était impossible d'atteindre, il se pose la question de la responsabilité morale de cet acte de destruction : dans quelle mesure est-il justifiable ?

En Europe, sur le plan éthique, c'est H. Jonas qui entrevoit la radicale nouveauté de cette classe de risques lié à ce pouvoir humain dont l'échelle est sans précédent : l'échelle de l'action humaine est si grande que l'éthique traditionnelle reste sans ressources pour savoir comment se comporter.

Les éthiques traditionnelles tenaient en effet pour acquis que la nature humaine est donnée une fois pour toutes, que sur cette base ce qui est bon se laisse déterminer, et que la portée de l'agir humain est limitée, et par conséquent la responsabilité l'est aussi. Mais désormais le pouvoir humain s'étend jusqu'à la biosphère, et l'intégrité de la nature humaine n'est pas garantie (radioactivitéradioactivité, génétiquegénétique, psychotropespsychotropes etc.). Il y a désormais possibilité de situations irréversibles. Il y a aussi déficit de savoir, au sens où les conséquences de l'action sont mal prévisibles. La responsabilité doit aujourd'hui s'exercer sur des échelles de temps beaucoup plus longues.

Jonas pose une seule question : existe-t-il l'espoir d'un Bien si grand que l'on s'autorise à risquer les conditions d'une "humanité authentique" future ? Sa réponse est clairement négative : quel que soit l'avantage attendu d'une opération, si le risque est tel que l'intégrité physiquephysique humaine et l'intégrité des conditions du milieu naturel nécessaire à l'organisme humain sont en jeu, alors l'action envisagée ne doit pas être entreprise. Il n'appartient pas aux hommes d'aujourd'hui de jouer avec la vie des hommes de demain, ni avec les conditions naturelles de cette vie. Les bienfaits attendus sont entachés de subjectivité, alors que l'on peut affirmer sans risque et objectivement que les hommes de demain dépendront eux aussi de conditions écologiques favorables pour exister et pour élaborer leurs propres activités.

H. Jonas ne s'en tient pas là, et s'en prend aux apologistes des pouvoirs de la technique qui affirment qu'il n'existe aucune irréversibilité à laquelle la technique ne puisse suppléer. Il existe une différence de taille, fait remarquer H. Jonas, entre les régulations naturelles et les régulations techniques : c'est que ces dernières reposent sur la faillibilité humaine pour être maintenues, alors que les premières n'en ont pas besoin. Les artifices sont donc toujours exposés à la faillibilité humaine, et il est donc plus risqué de s'en remettre à leurs services qu'aux services naturels qu'ils sont sensés remplacer. Il faut donc prendre en compte la faillibilité humaine et examiner avec soin les "scénarios du pire", qui ont une valeur heuristiqueheuristique et qui font le contre-poids de l'optimisme techniciste et transformateurtransformateur. L'Homme n'a pas le droit de s'inscrire dans une situation dans laquelle son infaillibilité serait requise sous peine de conséquences désastreuses.

Le cas des déchets nucléairesdéchets nucléaires est exemplaire à cet égard. Il s'agit là de déchets extraordinairement toxiques, et pour la plupart qui n'existaient pas dans l'environnement naturel avant que la main humaine ne les y introduise. La sécurité et l'intégrité de l'environnement reposent sur le confinement de ces déchets, et donc sur la faillibilité humaine, dans l'attente d'une hypothétique élimination qui équivaudrait à un confinement définitif et fiable à 100%. Quand on sait que certaines de ces matièresmatières seront encore actives dans plusieurs millions d'années, on mesure la teneur utopique d'un tel pari ! Et les déchets nucléaires ne sont pas les seuls : il faut aussi compter avec un grand nombre d'autres substances toxiques issues de l'activité humaine, en particulier chimique.

La faillibilité signifie qu'il n'existe pas de probabilité "zéro" d'occurrence d'un événement de type panne, du fait de la complexité des systèmes considérés. On avait jusque-là coutume de négliger les probabilité d'occurrence sont très faibles. Mais deux arguments nouveaux viennent remettre en cause cette pratique. D'une part l'enjeu, qui est beaucoup plus élevé qu'avant : le changement climatique est possible quand on brûle des énergies fossilesénergies fossiles en quantités suffisantes, pas avant. C'est tout le rôle des scénarios du pire de révéler les conséquences possibles les plus néfastes d'une action. Et d'autre part l'incertitude, l'incalculabilité principielle des probabilités d'occurrence de l'événement, comme on a pu le voir dans le cas des "surprises climatiques", et qui serait aussi le cas des centrales nucléairescentrales nucléaires : les attentats du 11 septembre 2001 aux Etats-Unis, avec un avion qui visait la centrale de Three Miles Island, ont montré que certains événements seront toujours hors des scénarios.

Dans un tel contexte, il peut être raisonnable d'envisager d'interdire l'existence de ces risques, et cela quelle que soit leur probabilité. En d'autres termes, aucune technique humaine ne doit avoir la capacité de bouleverser les conditions de la vie dans la biosphère : l'inexistence de la technique, c'est-à-dire du pouvoir, garantit l'inexistence du risque et l'absence de responsabilité. L'Homme, ne pouvant assumer une responsabilité aussi écrasante, refuse de l'endosser et réduit son pouvoir pour ne pas avoir à répondre d'un pouvoir trop grand pour lui. Le "risque zéro" est une astreinte inhumaine quand il s'applique à la conduite d'un artefact : c'est ce qu'affirme H. Jonas. Si l'on veut atteindre le risque zéro, c'est donc l'artefact, objet de la faillible conduite humaine, qu'il faut éliminer - ou ne pas créer.

La nature perd de son intelligibilité aux yeuxyeux des experts, dépositaires du savoir scientifique, qui ne savent plus répondre aux questions que leur pose la société. Au niveau des politiques publiques, les décideurs, que les problèmes sociaux convoquent sur la scène, ne savent plus quelle action entreprendre pour éviter le scandale.

Il se produit alors quelque chose qui était jusqu'ici tenu pour impossible : les parties mobilisent chacune leur expert, et il y a controverse sur l'expertise. Alors que l'Agence Internationale pour l'Energie Atomique compte toujours 31 morts des suites de l'accident de Tchernobyl, le correspondant de l'AFP en Ukraine rapporte l'existence d'une liste de 15 000 noms à Kiev, capitale de l'Ukraine, tandis que le gouvernement ukrainien parle de trois millions de personnes, dont un million d'enfants, malades des suites des radiations.

Les experts furent les premiers surpris : leur fonction se voyait remise en cause. Dans un mouvementmouvement de protection, ils répondirent tout d'abord par le déni : non, ils étaient toujours détenteurs du seul savoir légitime, complet, et s'il y avait erreur, elle ne pouvait venir que du camp opposé, qui fut donc taxé "d'irrationalité", comme en témoigne "l'Appel d'Heidelberg", formulée à l'occasion du Sommet de la TerreSommet de la Terre à Rio de Janeiro. Mais à la longue il fallut bien se rendre à l'évidence : les experts adverses étaient au moins aussi bien informés que les experts officiels, la raison de leur divergences résidait ailleurs.

Les sources de ce qui apparut tout d'abord comme une "confusion" ou un "sentimentalisme" sont doubles : d'une part, la redécouverte progressive de la complexité d'une nature que les experts de l'ancienne école imaginaient simple, inerte, et ensuite, la reconnaissance d'un contenu éthique et politique dans le discours de l'expert, et du désaccord légitime qu'il peut exister en matière de jugement sur la valeur des éléments naturels, sur les limites du "patrimoine naturel" et sur les autres choses mises en jeu.

La première ramenait l'expert au rang d'ignorant relatif, ce qui était peut-être vexant mais fondamentalement ne remettait pas en cause son statut : il suffisait d'en appeler à l'interdisciplinaritéinterdisciplinarité, ou à l'approfondissement des recherches. La seconde par contre interpellait sa représentativité, convoquait sa responsabilité sociale, et fissurait d'une manière irrémédiable un idéal de neutralité élaboré et protégé avec soin, et qui le distinguait de l'homme politique partisan. Pour les experts, et plus largement pour les scientifiques, le réveil fut donc brutal : il n'y avait plus de sens commun évident avec le grand public, engendrant incompréhension et dialogues de sourds. L'inquiétude grandit alors dans le "grand public", qui devint de plus en plus méfiant au fil des scandales qui s'enchaînaient : amianteamiante, sang contaminé, encélopathie spongiforme bovine (ESBESB) etc. Les risques n'étaient pas toujours très importants, chacun en aurait convenu : on aura dépensé pour chaque mort par ESB bien plus d'argentargent que pour un décès par accident de la route.

La confiance était minée. Les erreurs des responsables apparaissaient grossières : donner de la viande aux vachesvaches, masquer la dangerosité de l'amiante, affirmer que le nuage de Tchernobyl s'était arrêté à la frontière, vendre des semences stériles... sous la moquerie pointait un enjeu bien réel : celui de la perte de légitimité des institutions, et de l'inquiétude des citoyens. Le problème n'était finalement pas tant l'ampleur du risque que le sentiment d'être le jouet de décisions prises par d'autres. Les institutions semblaient avoir acquis un comportement autonome, s'éloignant des aspirations des citoyens. Elles étaient de plus en plus subies.

Ajoutons que les innovations techniques au nom desquelles les risques sont pris n'apportent plus de "progrès" aussi évidents qu'ont pu l'être la pénicillinepénicilline ou la machine à vapeur. Les citoyens sont donc moins disposés à prendre des risques pour des gains mineurs. L'agricultureagriculture biotechnologique est un bon exemple de gros risques pour des gains qui ressemblent davantage à de la stratégie corporatiste qu'à un mieux-être social.

Si l'on a eu besoin de reconnaître que "la nature n'est évidemment pas un concept scientifique", c'est bien que ce n'était pas si évident que cela au départ : on redécouvrit que la nature n'était pas seulement faite de la combinaison simple des lois et d'éléments mis en évidence en laboratoire.

Les risques écologiques signèrent donc la fin de "l'illusion du laboratoire" et du "toutes choses égales par ailleurs" : de ce que conclut le laboratoire quant aux causes et aux effets, on ne pouvait plus en déduire avec certitude les conséquences d'une action dans le monde. Il n'y a pas eu "naissance" de la "responsabilité sociale du savant", comme on a pu le dire, mais contestation de la responsabilité sociale du savant. Jusqu'ici, modèle positiviste qui permettait de tirer du laboratoire des conclusions fiables pour l'action, et donc d'atteindre "le bien" visé. Mais voilà qu'arrivent "les effets pervers"... la nature se révélait rebelle à l'appréhension scientifique.

La légitimité du découpage disciplinaire a été remise en cause par le même mouvement. Un acte dans le monde réel n'est pas disciplinaire : il s'imprime dans le tissu du monde sans égards pour les distinctions des catégories humaines. La main et l'esprit qui le guident procèdent par catégories, mais pas le monde. L'analyse disciplinaire et parcellaire était non seulement de moins en moins adaptée à la résolution des nouveaux problèmes, mais en plus elle risquait de réduire ou d'éviter un risque à un endroit pour en créer un autre un peu plus loin. L'interdisciplinarité est alors devenue un sujet majeur de réflexion pour une communauté scientifique et experte, qui voyait dans le même temps ses repères disparaître peu à peu. L'interdisciplinarité ne s'est pas pour autant traduite dans les faits. Elle resta et reste encore davantage de l'ordre de l'invocation que de la mise sur pied de programmes de recherche réellement interdisciplinaires, et non pluridisciplinaires : il ne s'agit pas de juxtaposer des disciplines, mais de mettre à jour ce qui dans l'objet lie un point de vue disciplinaire à l'autre.

Nous avons montré le rôle important joué par les paradigmes scientifiques dans l'établissement des critères de science. Nous voyons à présent qu'ils peuvent conduire à des erreurs énormes. Ainsi, il n'est pas rare de voir l'obsession de quantificationquantification / mathématisation aboutir à des études qui ont négligé des facteurs importants, simplement parce qu'ils n'étaient pas quantifiables. Le cas de l'évaluation des dommages dans l'analyse du changement climatique est à cet égard exemplaire : les experts ne se concentrent que sur les évaluations chiffrées et chiffrables, évaluables en monnaie, et rien d'autre, alors même qu'ils mentionnent par ailleurs l'existence de risques qui rend dérisoire les évaluations chiffrées faites auparavant. Les scientifiques expriment une sorte de malaise à conférer de l'être à quelque chose qui ne peut pas précisément être quantifié, comme si l'absence de quantification de l'objet était équivalente à leurs yeux à l'absence d'être de l'objet.

Dès lors, il ne suffisait plus d'avoir des connaissances scientifiques pour pouvoir affirmer détenir un savoir sur le monde. La question de l'interprétation revenait en force dans le discours de l'expert, et avec elle la question de l'éthique. S'il y a interprétation, alors il peut y avoir manipulation et subjectivité : on retrouve la seconde source de remise en cause. La mécanique fondamentale s'était certes heurtée à des problèmes similaires, mais ces questions n'intéressaient guère que les penseurs et les philosophes, en tant qu'objet de réflexion. Il en a été tout autrement lorsque ce sont des êtres humains se considérant comme victimes qui sont apparus.

L'éthique réapparaît encore avec la remise en cause du "maker's argument", comme nous l'avons évoqué plus haut. Non seulement il y a des limites éthiques à la manipulabilité, non seulement le passage du laboratoire au monde est contesté, mais c'est le critère scientifique de vérité comme manipulabilité lui-même qui se voit remis en cause : ce n'est pas parce que l'on est capable de faire quelque chose dans le monde que l'on est capable de le maîtriser, au sens d'en prévoir les conséquences d'une manière suffisante. Et "suffisante" a ici un sens éthique et juridique : il signifie qu'il y a une obligation de savoir avant d'agir, qu'on ne peut pas invoquer "l'ignorance invincible" pour n'importe quelle conséquence "involontaire".

Il y a responsabilité. Cela, l'industriel qui voit toute son activité menacée par une erreur mineure sur la qualité de ses produits le sait bien. L'erreur est montée en épingle par les associations de consommateur, qui sont devenues méfiantes. On est loin des Science & Vie faisant l'apologie des prouesses industrielles, comme l'exemple mentionné plus haut. Elles veulent "faire un exemple", estimant que pour une affaire soulevée, des centaines d'autres resteront tapies, efficacement cachées par les industriels. La campagne de dénigrement fait office de sanction, par la voie de la réputation.

Le monde industriel, qui était si stable et rassurant, incarnant la "rationalité", loin de l'agitation politique des partisans, entrait malgré lui dans la sphère du politique. La nécessaire politisation de la production, comme l'appelait Jonas de ses vœux, eut lieu contre le plein gré des principaux intéressés. Ils n'en furent que davantage pris au dépourvu. L'ingénieur n'avait jamais été formé aux problématiques politico-sociales, et l'entrepreneur savait mener des entreprises, pas des "affaires" telles que la contaminationcontamination par l'amiante. Et lorsque les structures de la responsabilité deviennent floues, les affaires économiques sont menacées : nous avons vu que le marché n'est pas un lieu instable de confrontation de l'offre et de la demande, mais une structure stable de production et de consommation, le choix entre différents produits intervenant à la marge, sans menacer l'évolution lente du système économique de production. Quand le marché est réellement devenu instable, en raison de ces nouveaux risques imprévisibles, les entreprises n'ont pas été les dernières à s'intéresser au sujet.

Il y a responsabilité. Le décideur politique lui aussi le sait, qui s'inquiète de la disparition des repères rassurants de la science pour prendre ses décisions. Les années s'étaient écoulées et on avait pu croire que l'on avait "rationalisé" le politique, en arrivant finalement à en faire une capacité d'ajustement marginale dans le développement des systèmes techniques. Il reprenait tout d'un coup un poids oublié, et les politiques eux-mêmes furent surpris.

Tous ces nouveaux développements dans le monde de l'expertise conduisent à l'émergenceémergence d'un nouveau concept : le "principe de précautionprincipe de précaution".

Le Principe de Précaution a fait une entrée très remarquée dans l'horizon politique et juridique des années 90. Sa maturation est toutefois antérieure. Objet de débat, de controverses, instrument de dénonciation ou de justification, le contenu de ce principe n'est pas encore stabilisé - à supposer qu'il le soit un jour.

Le Principe de Précaution s'adresse à un contexte bien particulier : celui de l'apparition de risques de dégradation "grave et irréversible" de l'environnement. Il n'est pas en lui-même une réponse claire à cette classe de problèmes. Il semble plus exact de dire qu'il reconnaît l'existence de ces problèmes, et invite à tirer les conclusions des remises en causes opérées par la crise environnementale : faillibilité et partialité de l'expertise, nouveaux risques, découverte d'une déficience profonde de nos savoirs sur la nature, incertitude et controverses sur la valeur des éléments naturels et sur la manière de les protéger, politisation de la qualification des menaces, mise en cause des structures habituelles de responsabilité etc. Le Principe de Précaution ne permet pas directement de dériver un jugement. Il reconnaît qu'il n'y a pas de réponse évidente, et surtout que l'inaction, c'est-à-dire le maintien des activités habituelles, peut être néfaste. Il invite donc plutôt à définir un cadre indiquant les éléments qu'il est nécessaire de rassembler pour élaborer une réponse qui ait une chance d'être à la fois légitime et pertinente au regard du problème posé.

Historiquement, le principe est issu du droit international. On peut dater son apparition de la fin des années 1980, avec le concept de développement durabledéveloppement durable. C'est dans la Déclaration ministérielle de la Deuxième Conférence internationale sur la protection de la Mer du NordMer du Nord (Londres, 1987) qu'il apparaît explicitement pour la première fois. A ce moment-là, les normes de références permettant de réguler l'action de l'Homme sur l'environnement étaient exclusivement fondées sur la capacité effective d'assimilation des écosystèmes, constatée post hoc. La prise en compte des incertitudes scientifiques conduisit à introduire une marge de sécurité. Le principe de précaution a ensuite été consacré par de nombreux textes internationaux, parmi lesquels la fameuse Déclaration de Rio sur l'environnement et le développement (1992), et les deux Conventions signées à Rio : la Convention relative au changement climatique et la Convention sur la diversité biologiqueConvention sur la diversité biologique.

Sur le plan des idées, les Européens font remonter la genèse du concept aux pressionspressions exercées par les groupes "verts" sur la politique allemande. Le Vorsorgeprinzip (Principe de Précaution) apparaît dès 1971 dans le Programme définissant la politique environnementale du Gouvernement fédéral. Chose intéressante, le concept de Vorsorge, ou plus exactement de Vorsorgemaßnahmen, qui apparaît dans la version allemande de la Déclaration sur la protection de la Mer du Nord, était considéré comme l'équivalent anglais de timely preventive action.

Il y a deux idées importantes à retenir à partir de là. La première est qu'au départ il ne semblait pas y avoir de différence de nature entre la préventionprévention et la précaution, mais plutôt une différence de degré. On conviendra plus tard que la prévention se réfère à des situations de risque probabilisable, tandis que la précaution fait référence à des situations dans lesquelles le risque n'est pas probabilisable : l'incertitude est dans une certaine mesure irréductible. La seconde est relative à l'importance de la dimension temporelle dans les deux cas : la détermination de l'échelle appropriée au problème posé est tout à fait déterminante pour la pertinence de la réponse.

Le Principe de Précaution est défini dans la législation française comme un principe selon lequel "l'absence de certitudes, compte-tenu des connaissances scientifiques et techniques du moment, ne doit pas retarder l'adoption de mesures effectives et proportionnées visant à prévenir un risque de dommages graves et irréversibles à l'environnement, à un coût économiquement acceptable" (Article L200-1 du Code rural). Cette formulation reprend largement celle des textes internationaux tels que la Déclaration de Rio (1992), suivant le principe de monisme juridique qui prévaut en France en ce qui concerne le statut du droit international. Elle reste imprécise et sujette à bien des équivoques.

L'objet, tout d'abord. Il s'agit de risques pesant sur "l'environnement", concept flou s'il en est. Environnement construit ou environnement naturel ? La définition ne le dit pas. On peut certes se douter qu'il s'agit bien de l'environnement naturel, puisque c'est les menaces pesant sur l'intégrité naturelle qui sont à l'origine du principe. Mais l'équivoque suscite d'interminables débats souvent éloignées du sujet.

L'absence de certitudes n'est pas moins sujette à controverses. Est-ce une absence totale de certitudes ? Ou ne doit-on pas avoir quelque idée précise de la menace ? Quelle est la différence avec un cas d'ignorance invincible ? Pour que le principe ait un sens, l'incertitude ne peut pas être totale : il doit être possible de se faire une idée des conséquences possibles de l'action, qu'elles soient probabilisables ou pas.

Les "dommages graves et irréversibles", ensuite. La "gravité" du dommage quant à elle requiert un jugement pratique : ce qui est visé est l'action qui peut introduire dans le milieu un risque qui menacera certains êtres considérés comme importants au point de vue moral ou juridique, par exemple, les choses et les êtres dont on estime que l'intégrité doit être préservée. Or la définition des objets à protéger est sujette à controverse, comme nous l'avons mentionné plus haut, et elle n'est pas vierge d'enjeux socio-politiques : ceux qui vivent des pratiques qui conduisent à dégrader l'intégrité d'éléments naturels que d'autres veulent protéger ne souhaitent pas toujours changer d'activité.

Les mesures "effectives et proportionnées", "à un coût économiquement acceptable", enfin. Rien n'est sûr ici : l'arbitrage relève encore une fois davantage du jugement moral ou politique que d'une décision de droit. Lorsqu'on voit la difficulté qu'il y a à élaborer un plan de licenciement ou une restructuration, on a une petite idée des difficultés qui naissent et naîtront autour de la question de la définition des "coûts acceptables"...

Il y a quand même quelques éléments pour préciser le contenu du principe de précaution. Nous en voyons six.

Tout d'abord, c'est un principe de politique publique : les effets destructeurs dont on parle ne sont pas le fait d'activités isolées, mais de leur agrégation en effets collectifs. Il s'agit donc de problèmes plutôt structurels. L'objet des politiques publiques est précisément de s'occuper des effets collectifs, puisqu'il n'y a nulle harmonie préétablie dans l'organisation des activités individuelles. Il ne vise donc pas directement l'action individuelle privée, et en particulier les choses marchandes, dont le propriétaire dispose par définition et par l'institution de usus et de l' abusus, et donc qu'il peut détruire si bon lui semble. Mais il les vise indirectement, à travers les réglementations et les politiques qu'il appelle à mettre en oeuvre. L'objet du principe est bien le milieu naturel. Mais c'est aux hommes qu'il s'adresse, seuls capables de responsabilité : les deux aspects, humain et naturel, sont donc indissociablement présents. On ne peut pas demander à la nature de produire davantage, ou d'être plus résistante : la seule solution est de demander à l'Homme d'être moins gourmand. Protéger le milieu naturel requiert donc de modifier l'environnement, naturel (arrêter la destruction) et humain (réorienter les activités potentiellement destructrices par des politiques publiques appropriées).

Ensuite, ce Principe ne s'adresse qu'aux risques créés par l'Homme, ce qui élimine le devenir naturel de la nature de la problématique. L'Homme n'est pas responsable de l'évolution naturelle. "L'irréversibilité" des risques dont il est question est donc relative aux les risques supplémentaires aux risques naturels. Il se pose alors la question de la légitimité de ces risques additionnels : au nom de quoi peut-on léguer au futur des risques dont l'existence est inscrite pour une duréedurée hors de portée de nos moyens techniques ? Peut-on les justifier par la constructionconstruction de "bienfaits" les compensant ? Il faudrait alors connaître les préférences des générations futures, et être certains que ces "bienfaits" de la "civilisation" soient garantis pour une durée aussi longue que les risques eux-mêmes. Or ceci est fort aventureux : il n'y a qu'à se rappeler que la paix n'est vieille que de 50 ans dans la Communauté Européenne, ou se rappeler l'état des techniques il y a 200 ans. En d'autres termes, en faisant pour l'instant abstraction de la question de la continuité dans le temps des valeurs humaines, il faudrait déjà démontrer que l'irréversibilité des systèmes techniques permettant de dépolluer (annuler le risque) est au moins aussi grande et durable que celle des pollutions (risques). Comme il semble déraisonnable de penser qu'une institution humaine puisse avoir une espérance de vieespérance de vie supérieure au siècle, nous disposons déjà d'un premier ordre de grandeurordre de grandeur pour ce qui est de l'irréversibilité.

En outre, le principe est à mobiliser uniquement en cas de risque grave et irréversible. Ces actions sont loin de représenter l'ensemble des actions humaines. Ainsi, la diffusion des savoirs, de la culture, des arts, la solidarité, la démocratisation et les débats, etc. n'en font pas partie, pas plus que l'agriculture, ni l'élevage, ni la bouturebouture, ni de manger, ni de respirer, ni de construire des villes. Autant d'actions qui ne sont pas sans impact sur le milieu naturel, mais qui sont largement tolérables par celui-ci : le principe de précaution n'est pas à mobiliser dans ce cas.

Par ailleurs, la double mention de la "proportion" et du "coût économique" montre que la question des mesures à prendre ne doit toutefois pas être restreinte à une analyse de type utilitariste (coûts/bénéfices) : la question déontologique du respect des droits, dont relève en particulier la logique de l'intégrité du patrimoine ou de l'éthique environnementale (respect des animaux etc.), doit elle aussi être prise en compte. La question de la "proportion" est donc une question économique mais aussi une question de casuistique juridique et morale, étayée sur un ensemble de possibilités sociales, techniques et naturelles. Notons enfin que, comme toutes question de casuistique, il serait bien imprudent de le laisser décider par des experts au regard spécialisé, donc parcellaire, et encore moins à des experts qui ont un intérêt personnel ou corporatiste à faire pencher la balance d'un côté ou de l'autre.

Le Principe de Précaution ouvre donc nécessairement des questions de redéfinition des responsabilités, en particulier en ce qui concerne la charge de la preuve. Dans la plupart des risques environnementaux évoqués, l'identité du responsable est rarement aisée, et il faut pourtant trouver un interlocuteur pour que la résolution sociale du problème ait lieu. Un exemple simple : dans le cas des émissionsémissions de CO2CO2, doit-on imputer l'automobiliste, le constructeur de voituresvoitures, le revendeur, l'Etat ou les Régions ? Il est évident qu'il n'existe aucune réponse simple à cette question, et que la "dilution" des responsabilités rend le problème plus difficile à appréhender. Dans l'invective et la dénonciation qui va suivre la prise de conscience collective de l'existence d'un risque, nul ne souhaite être désigné comme responsable, ni voir son activité remise en cause. Le Principe de Précaution en appelle donc à l'action, mais ne précise pas qui doit en être responsable. Par défaut, tout le monde peut donc se retrouver sur le banc des accusés.

Enfin, l'un des points les plus controversés est ce qu'on a appelé parfois "l'inversion de la charge de la preuve". La puissance publique seule ne peut faire l'inventaire a priori des permis et des interdits, puisqu'il existe d'importantes incertitudes scientifiques. Le Code ne peut se prononcer : c'est donc aux acteurs eux-mêmes de prendre garde à ne pas engendrer de "risque grave et irréversible", parce qu'ils pourraient ensuite être amenés à faire la preuve que tel n'était pas le cas devant un tribunal. La charge de la preuve n'est alors plus exclusivement à la charge de la victime, mais aussi en partie à la charge du coupable présumé, qui doit démontrer son innocence.

Le Principe de Précaution vient sans doute rappeler que l'époque positiviste des va-t-en-guerre de la technique et de l'innovation est révolue, et qu'un certain consensus autour des activités de production s'est brisé. Il y a (ré-)émergence d'une valeur importante et concurrente : l'intégrité du milieu naturel.