au sommaire

En matière de recherche scientifique, ce que l'on nomme aujourd'hui big databig data correspond à la masse considérable de données dont nous disposons. En neuro-imagerie par exemple, une IRMIRM produit une quantité considérable de données de qualité et de nature très variables. Ces données s'amoncellent très rapidement et représentent chaque jour plusieurs centaines de téraoctets (1012 octetsoctets). Le terme big data englobe tous ces aspects, mais révèle également une peur : celle des politiques, des scientifiques ou des chercheurs face à la destination, à la signification ou à la possibilité de traiter ces données.

Célya Gruson-Daniel a cofondé HackYourPhD, une plateforme communautaire qui rassemble doctorants, jeunes chercheurs, entrepreneurs et designers autour de l'open science. Diplômée de l'École normale supérieure (ENS) et de l'université Pierre-et-Marie-Curie (UPMC -- Paris 6) en neuroscience cognitive et comportementale, elle est ingénieure de recherche, spécialisée dans les MOOCMOOC et le big data dans le domaine de la santé au Centre Virchow-Villermé de santé publique Paris-Berlin.

Le développement du big data pose des questions éthiques. © DP

Le big data et l’open data nous confrontent-ils à de nouveaux défis ?

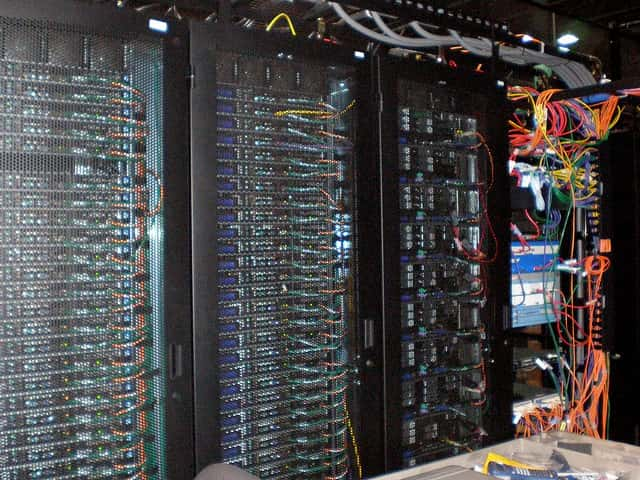

Célya Gruson-Daniel : le big data impose l'utilisation de structures adaptées, en particulier pour l'archivagearchivage et la pérennisation des données. Des capacités de stockage considérables sont désormais nécessaires et il faut recourir aux infrastructures distribuées, comme le cloud. L'utilisation des données requiert également une puissance de calcul accrue. Ainsi, de véritables défis technologiques se posent à toutes les branches de la recherche, même si certaines ont de l'avance sur d'autres.

Le traitement massif des données nécessite une capacité de stockage impressionnante comme celle des data centers. © Sean Ellis, Flickr CC by-2.0

La physique fondamentale, par exemple, met déjà en œuvre des dispositifs performants. L'ensemble des disciplines, notamment la santé et la science du vivant, utilise de manière croissante des masses de données considérables. Une approche complexe et multi-échelle est de plus en plus nécessaire, d'où le recours à la biologie des systèmes (également connu sous le nom de systems biology), c'est-à-dire à l'intégration de données issues du génomegénome, de la cellule ou du phénotypephénotype.

Outre l'infrastructure, en lien avec InternetInternet, le big data impose de nouvelles normes et une certaine standardisation qui font actuellement l'objet d'un travail important du W3C [le World Wide Web ConsortiumWorld Wide Web Consortium est un organisme de normalisation à but non lucratif, fondé en octobre 1994, chargé de promouvoir la compatibilitécompatibilité des technologies du World Wide Web, NDLRNDLR]. L'enjeu est de pouvoir étiqueter les données et de favoriser leur interopérabilité. En d'autres termes, il s'agit de pouvoir disposer de données suffisamment standardisées pour qu'elles soient échangeables et comparables à d'autres (on parle alors de linked data). Cet enjeu est considérable dans tous les domaines.

Dans le secteur de l'open data, il convient également de prendre en compte des problématiques d'anonymisation des données personnelles. Les données humaines doivent pouvoir être protégées et le big data pose évidemment des questions éthiques, dont découlent certaines problématiques techniques : comment rendre des données anonymes ? Comment, le cas échéant, les « réidentifier » ? Ces défis technologiques ne peuvent être minimisés. Les sciences de l'informatique permettent notamment le développement d'algorithmes spécialisés dans le traitement et l'analyse des données. Dans le domaine de la biologie, certaines études très importantes ont été lancées sur les liens entre big data et santé, notamment sous l'angle dynamique, celui du flux continu ou data stream.

Le big data permet de faire émerger des tendances ou de dresser des cartographies de contextes épidémiques pour la grippegrippe ou la gastro-entéritegastro-entérite, par exemple. Dans le domaine de l'open data, la biologie des systèmes est née de l'émergenceémergence d'une masse considérable de données dont l'analyse impliquait nécessairement des collaborations. Nitin Baliga, vice-président de l'Institute for Systems Biology de Seattle, l'explique très bien [voir l'interview Systems biology studies need Open Science, d'août 2013, sur HackYourPhD, NDLR].

Lors de la conférence « So Data ! » en mars 2014, Salma Mesmoudi, ingénieure de recherche à l'Inserm, a confirmé la même tendance, notamment pour les secteurs de la neuroscience et de la neuro-imagerie, plus particulièrement face à la maladie d'Alzheimermaladie d'Alzheimer. Elle a souligné l'accélération de la recherche permise par les ensembles de données. À cet égard, une comparaison entre deux projets, l'un français où les données ne sont pas partagées, l'autre américain où le partage est complet, est tout à fait édifiante : les publications sont bien plus nombreuses de l'autre côté de l'Atlantique. Mais le monde des données ouvertesdonnées ouvertes présente évidemment des lacunes. La question de l'accessibilité des données, plutôt que celle de leur existence me paraît essentielle. En outre, il faut que les données soient susceptibles d'être traitées.

Assiste-t-on à une révolution du monde de la science ?

Je suis prudente face à la notion de révolution, toutes les formes de communication étant très friandes de ce terme. En revanche, l'idée d'évolution est incontournable, en lien avec les technologies numériquesnumériques de l'information et de la communication. Internet, le web collaboratif et le numérique en général offrent de nouvelles possibilités en terme de partage, d'échange de contenu et de connaissances à bas coût et de façon quasi instantanée. Elle transforme nos pratiques : comment comprendre et accompagner ces nouvelles démarches scientifiques ? Comment intégrer toutes les sphères qui gravitent autour de la science ?

Les chercheurs s'appuient de manière croissante sur le travail des data scientistsdata scientists, qui disposent de compétences technologiques avancées leur permettant de traiter des données et de les analyser dans une logique statistique. La capacité à tisser des liens entre différentes échelles de données est également une compétence très recherchée. J'ai constaté que Seattle se positionnait à l'avant-garde de ces problématiques : des entreprises comme MicrosoftMicrosoft et AmazonAmazon s'y sont installées au milieu d'un grand nombre de computer scientists. Les réflexions sur les données et leur analyse y sont très intenses.

À Seattle, aux États-Unis, des entreprises comme Microsoft ont fait un choix stratégique en s'installant à proximité de computer scientists, capables de gérer des flux importants de données. © Johannes Hemmerlein, Wikimedia Commons, DP

Trois collaborateurs de Microsoft ont publié The Fourth Paradigm, dans lequel ils démontrent que les données stimulent la recherche de manière croissante. Il s'agit donc d'un véritable changement épistémologique. Antoine Flahault, qui travaille sur l'axe « big data et santé » au Centre Virchow-Villermé, considère que le secteur de la santé a subi de profondes mutations depuis l'émergence du big data. [Antoine Flahault est docteur en médecine et en biomathématique, ancien directeur de l'École des hautes études en santé publique (EHESP), il a mené ses recherches sur la surveillance épidémiologique et la modélisation mathématique des épidémiesépidémies et dirigé le centre de l'OMSOMS pour la surveillance électronique des maladies, NDLR].

Auparavant, il était indispensable de consulter un ensemble de travaux avant d'émettre une hypothèse, de produire des données et enfin de les analyser. Aujourd'hui, la logique s'est inversée : nous cherchons à donner un sens à un gigantesque ensemble de données, mais également à tester cette signification. Le paradigme évolue et une prise de conscience s'impose de la part des chercheurs : celle de comprendre les nouvelles problématiques issues du big data et ses différents aspects. L'analyse de ces données est complexe, elle requiert des compétences spécifiques. Même les ensembles limités de données impliquent une analyse statistique pertinente sans laquelle aucun résultat cohérent n'est possible. Nous ne sommes qu'au début du processus.

La recherche se trouve également face à la nécessité de faire collaborer les disciplines, et des notions comme l'interdisciplinaritéinterdisciplinarité et la transdisciplinarité revêtent aujourd'hui une importance toute particulière. Nous nous trouvons dans des systèmes et face à des questions de plus en plus complexes. Le contrôle et la contextualisation des données exigent cette collaboration. Quoi qu'il arrive, une mise à plat de cet ensemble de problématiques paraît désormais incontournable.

Qu’est-ce que l’open science ?

L'open science est une expression « valise » qui regroupe plusieurs initiatives, conduites à la fois par des chercheurs et des non-chercheurs, sur l'idée d'une recherche plus ouverte, plus transparente et plus collaborative. Cette logique vise également la multiplication des interactions entre le monde de la recherche et les sphères de la société civile, de l'entreprise ou même des arts.

L'open science présente différents aspects : libre accès aux publications scientifiques (open access), open data, logicielslogiciels open source, recherche participative et contributive. Par exemple, l'accessibilité des logiciels dont le coût de développement est parfois exorbitant permet aux non-chercheurs de s'impliquer également, par exemple PythonPython ou R [langages de programmation utilisés par les scientifiques de données, NDLR]. Les récentes interactions entre chercheurs et autres parties prenantes (institutions, citoyens, etc.) font d'ailleurs l'objet d'une terminologie nouvelle en français (collaboration, interopérabilité, norme ouverte, etc.).

L'open science se situe entre le monde de la recherche, les technologies numériques de l'information et de la communication et les pratiques et cultures « open » émergentes. Il en découle par exemple de nouveaux modes d'organisation, pair à pairpair à pair (P2P) et contributifs.

Le développement du big data pose des questions éthiques liées à la protection des données humaines. © DR

L'open science doit aussi être perçue en tant qu'outil de médiation et d'action. Elle vise notamment à mettre en lumière certaines critiques courantes, adressées à l'organisation de la recherche, en particulier sur le thème de la marchandisation du savoir. Ces réflexions méritent d'être replacées dans l'histoire, émaillée d'épisodes de revendication du savoir comme bien commun. Une forme d'open science avait déjà émergé, à d'autres époques.

Aujourd'hui, cette notion s'inscrit dans un vocable particulièrement séduisant pour les jeunes générations : open science, open data et open knowledge. Brian Glanz, [fondateur de l'Open Science Federation et cofondateur du chapitre américain de l'Open Knowledge Foundation, NDLR], évoquait déjà l'open science en 1999, à l'occasion d'un colloque sur l'open sourceopen source. Cet esprit et cette culture « open » se rapprochent également du mouvement des communs et la participation du patient dans le processus de recherche. qui aujourd'hui vit un nouvel élanélan avec le numérique et ce que l'on nomme « communs informationnels ». L'open science est donc un concept particulièrement large qui permet de rallier un grand nombre d'acteurs. L'open data en fait partie. Le big data en revanche n'est pas nécessairement open. Toutefois, son avènement et les transformations qu'il apporte impliquent une évolution des pratiques.

Pouvez-vous nous donner des exemples de projets réalisés grâce à l’open data ?

Le Personal Genome Project (projet du génome personnel) de Harvard, notamment, s'est fondé sur une logique open consent et open content. En d'autres termes, les membres d'une petite équipe ont été « génotypés » et ces éléments ont été rendus publics. Une telle initiative pose des questions éthiques et de confidentialitéconfidentialité. En effet, le génome des participants appartient désormais au domaine public.

Or, les éléments issus d'un décryptage du génome peuvent intéresser l'assurance-maladie ou les mutuelles, par exemple. Si tous nos génomes devaient être accessibles et qu'il était possible de les relier à chacun d'entre nous, il conviendrait de s'en inquiéter. Face à d'autres projets comparables, le génome a déjà donné lieu à des batailles juridiques. Il devrait cependant rester dans le domaine public et ne pas pouvoir être accaparé par des entreprises. Il apparaît en effet important d'empêcher la privatisation de ce patrimoine.

L'organisme Sage Bionetworks [un organisme à but non lucratif, basé à Seattle, qui favorise la science ouverte, NDLR] travaille avec l'industrie pharmaceutique sur des méthodes de partage des données, au profit des différents acteurs de ce secteur. Il ne s'agit pas d'« open » au sens strict du terme, mais un tel projet vise à faciliter la collaboration entre différents acteurs. De nombreux verrousverrous restent encore à ouvrir et, dans cette perspective, la facilitation du travail collaboratif constitue une première étape. Je pense également au projet open source MalariaMalaria, qui repose sur un modèle entièrement ouvert.

Comment l’open data et le big data font-ils évoluer les méthodes de travail ?

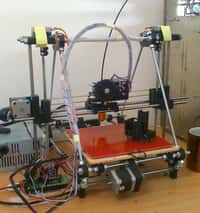

La situation varie considérablement selon les disciplines. Un projet comme Academic TorrentsTorrents permet de partager et de stocker les données par le biais du cloud. Un certain nombre de plateformes sont créées pour accueillir et archiver les données, mais aussi pour s'assurer de leur standardisation. Ces infrastructures présentent un impact fort sur les méthodes de travail. Toutefois, la formation des chercheurs aux outils disponibles n'est pas encore suffisante.

La médecine de demain pourra se servir des analyses issues du big data. Cette médecine se prépare notamment dans des centres comme celui du Campus Biotech, en Suisse. © Campus Biotech

Cependant, le numérique en général a transformé toutes les pratiques, celles des chercheurs les plus jeunes, comme celles des plus âgés. Les plus jeunes ne comprennent pas pourquoi ils ne peuvent pas avoir accès directement à l'information. L'existence des paywalls les dépasse.

À cet égard, nous nous ressemblons tous : nous n'admettons pas de devoir payer pour accéder à des articles scientifiques. C'est la raison pour laquelle certaines plateformes pirates d'échange d'articles ont émergé à l'image de ce qui existe pour la musique ou les films. Ces dernières sont évidemment illégales. Par ailleurs, certains jeunes chercheurs partagent leurs articles sur leurs propres sites Internet sans prendre en considération le copyright agreement (cession de droits) qui transfère le droit d'auteur aux éditeurs. Cette démarche n'est pas recommandée. En plus de ne pas respecter le contrat, l'article est plus difficilement référencé. Le mouvement open access essaye de remédier à cela en faisant émerger un modèle où les articles scientifiques sont accessibles à tous. L'open science est liée à une évolution générationnelle. Le numérique prend une place de plus en plus importante dans l'ensemble du processus de recherche et dans le workflow du chercheur. Les carnets de laboratoires sur papier semblent en voie de disparition et remplacés par des carnets de recherche en ligne parfois ouverts (Open Notebook).

Nous arrivons tout de même doucement vers un mouvement général de formation des chercheurs à l'open science, au big data et à l'open data. À l'échelle européenne, il existe l'initiative Foster (Facilitate Open Science To European Research) qui vise la mise en place de formations dans ce domaine. Dans le domaine de la science et du web, plusieurs formations sont déjà disponibles, notamment pour maîtriser les outils de gestion bibliographique. En France, tout au moins, la sphère open n'est pas encore bien prise en compte. Aux États-Unis en revanche, une prise de conscience est en cours autour du data management.

L’open science est-elle nécessairement synonyme de meilleure science ?

De mon point de vue, il est difficile d'avoir une réponse tranchée. L'open science est un courant qui questionne et remet en cause certaines pratiques actuelles. Pour autant, chaque pratique émergente porteporte des enjeux économiques et ouvre une niche ; les dérives sont toujours possibles. L'open data pose évidemment des questions éthiques, sous l'angle des données personnelles. L'open access constitue un nouveau marché, souvent confronté à des enjeux de qualité de l'information. De nouvelles modalités de contrôle de la qualité de cette information restent à créer.

L'open science vise certainement une plus grande efficacité et une meilleure idée de la science. Pourtant, l'atteinte de ces objectifs présuppose un regard critique sur les pratiques émergentes et la détection des dérives possibles. Le rôle des médias est important et, pour certains, la tentation de profiter d'un effet de mode est grande. Certains groupes attachent néanmoins à l'open science des valeurs particulièrement fortes. L'université Stanford aux États-Unis a créé un laboratoire de métarecherche, dont l'objectif est précisément d'évaluer la qualité de la recherche. De manière générale, il me paraît particulièrement important d'acquérir suffisamment de recul pour formuler des conclusions définitives. Reste que le secteur est très dynamique.