au sommaire

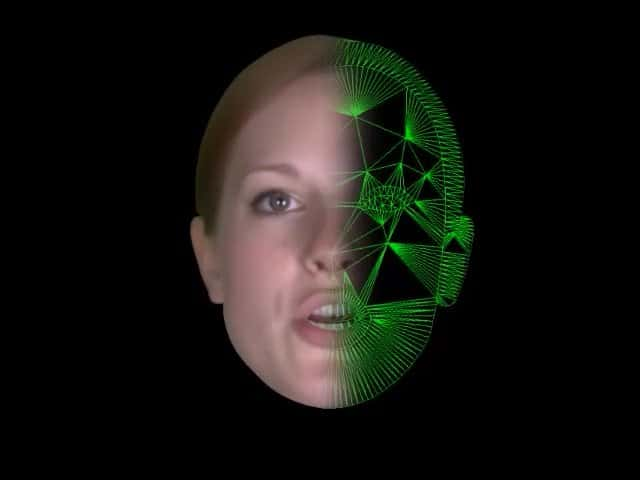

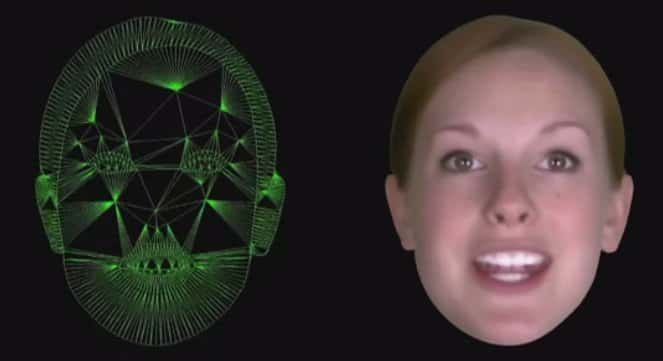

Sur l'avatar, il serait possible d'appliquer l'image de n'importe quel visage et de lui ajouter une voix, ce qui permettrait de le personnaliser. © Université de Cambridge, Toshiba Research Europe

Après les appels téléphoniques, l'envoi de SMS est l'activité principale des utilisateurs de téléphones mobilesmobiles. Selon les derniers chiffres de l'Arcep (Autorité de régulation des communications électroniques et des postes) portant sur le quatrième trimestre 2012 en France, 48,1 milliards de SMS ont été échangés avec une moyenne mensuelle de 229,8 SMS par abonné. Et si ces indispensables textostextos étaient un jour remplacés par des « face messages » ? En lieu et place d'un texte, le destinataire d'un SMS verrait apparaître le visage de synthèse de l'expéditeur qui lui délivrerait le message en mimant les émotions et les intonations adéquates.

C'est cette technologie qui a été mise au point par une équipe de chercheurs du Cambridge Research Laboratory de Toshiba et le département d'ingénierie de l'université de Cambridge. Ils ont créé un avatar nommé Zoe, qui est en fait un visage virtuel capable de retranscrire les expressions faciales et les intonations vocales liées à des émotions avec une grande fidélité. Le système repose sur une applicationapplication dans laquelle on tape le texte du message en indiquant le type d'émotion que l'on souhaite exprimer. L'ensemble sera ensuite récité par Zoe.

Le visage de Zoe repose sur une modélisation exprimant différentes émotions (joie, colère, tristesse, peur, etc.). Sur cette base (ici à gauche) a été ajoutée l'image de Zoë Lister, une actrice britannique. L'expéditeur d'un message tape son texte puis définit une certaine émotion et son intensité. Pour le destinataire, l’outil de modélisation reproduit les mouvements du visage, avec une grande finesse et une excellente synchronisation avec le discours. © Université de Cambridge, Toshiba Research Europe

L'avatar Zoe peut jouer six émotions

« Cette technologie pourrait marquer le début d'une toute nouvelle génération d'interfaces qui rendraient l'interaction avec un ordinateur plus proche d'une conversation avec un autre être humain », estime le professeur Roberto Cipolla qui fait partie de l'équipe à l'origine de ce projet. Car l'intérêt du système est qu'il repose sur un canevas où peut se plaquer le visage et la voix de n'importe quelle personne. On pourrait donc personnaliser son avatar à partir d'une photo et d'échantillons de voix. L'autre avantage est que ce programme est très léger, « une dizaine de mégaoctets » selon ses concepteurs, qui assurent qu'il peut facilement fonctionner sur des terminaux mobiles comme des tablettes, des smartphones ou encore des livres électroniques. Les applications envisageables sont nombreuses, qu'il s'agisse d'envoyer des messages depuis un mobile ou un ordinateur, d'ajouter une dimension interactive dans un jeu vidéo, dans un livre ou un magazine électronique.

Pour créer Zoe, les chercheurs ont fait appel à l'actrice britannique Zoë Lister, qui a prêté son visage et sa voix. Pendant qu'elle récitait des phrases types en mimant des émotions, les expressions de son visage et le ton de sa voix ont été enregistrés puis modélisés pour alimenter l'algorithme qui anime le visage virtuel. Forts d'une base de données de 7.000 phrases, les chercheurs sont parvenus à enseigner au logiciel la reconnaissance du langage et des expressions faciales. Résultat : l'avatar Zoe possède six émotions (joie, tristesse, colère, tendresse, peur, neutre) qu'elle peut jouer à partir d'un texte écrit.

Comme l'a confirmé à Futura-Sciences Björn Stenger, chercheur au Cambridge Research Laboratory de Toshiba, le système n'est pas doté d'une autonomie qui lui permettrait d'apprendre seul de façon empirique. On ne parle pas ici d’intelligence artificielle, mais d'un « système qui génère un rendu à partir de textes et d'émotions programmés ». En revanche, l'application permet de régler l'intensité de l'émotion que l'on souhaite exprimer, de jouer sur le volumevolume et le débitdébit de la voix, mais aussi de combiner les émotions afin de les restituer avec plus de subtilité. En associant par exemple la joie et la tendresse et en augmentant la vitessevitesse et la profondeur de la voix, Zoe prend un ton chaleureux et accueillant. Une combinaison mêlant peur, colère et élocution rapide suggère la panique.

Pas encore d’application grand public

Pour vérifier l'authenticité du résultat, l'équipe de chercheurs a réalisé une série de tests auprès d'une vingtaine de volontaires, à qui l'on a demandé d'identifier l'une des six émotions exprimées. Les personnes à qui l'on avait soumis un échantillon vidéo muet ont reconnu l'émotion exprimée à 52 %. Le pourcentage est monté à 68 % pour ceux qui ne disposaient que d'un extrait audio, et à 77 % pour les testeurs ayant eu un échantillon avec son et image. À titre de comparaison, le pourcentage d'identification à partir d'extraits tournés par la « vraie » Zoë Lister était de 73 %. Cette différence entre le virtuel et le réel s'explique par le fait que l'application force volontairement un peu plus le trait.

Ce système est certes puissant, mais serait sans doute complexe à utiliser tel quel dans une application grand public. « Dans le cas d'un usage grand public, le fonctionnement pourrait être simplifié en se servant d'émoticônes, par exemple », explique le professeur Stenger. Ce dernier a par ailleurs indiqué qu'il ne s'agit pour le moment que d'un projet qui n'a pas d'avenir commercial. « Il n'y a pour le moment pas de plan pour commercialiser cette technologie. C'est un pur projet de recherche, avec lequel nous essayons de repousser les limites de ce que l'on peut faire dans le réalismeréalisme de l'animation texte-voix. »