au sommaire

L'incivilité, voire l'agressivité, au volant est un phénomène récurrent, les Français jouissant même d'une assez mauvaise réputation dans ce domaine. Et si la voiture pouvait détecter l'état émotionnel de son conducteur et agir pour adoucir ses mœurs ? Elle pourrait par exemple passer une musique apaisante ou basculer sur un éclairage du tableau de bord plus doux. Farfelu ? Bien au contraire, puisqu'un tel système existe et est même testé en collaboration avec le groupe automobileautomobile français PSA Peugeot Citroën.

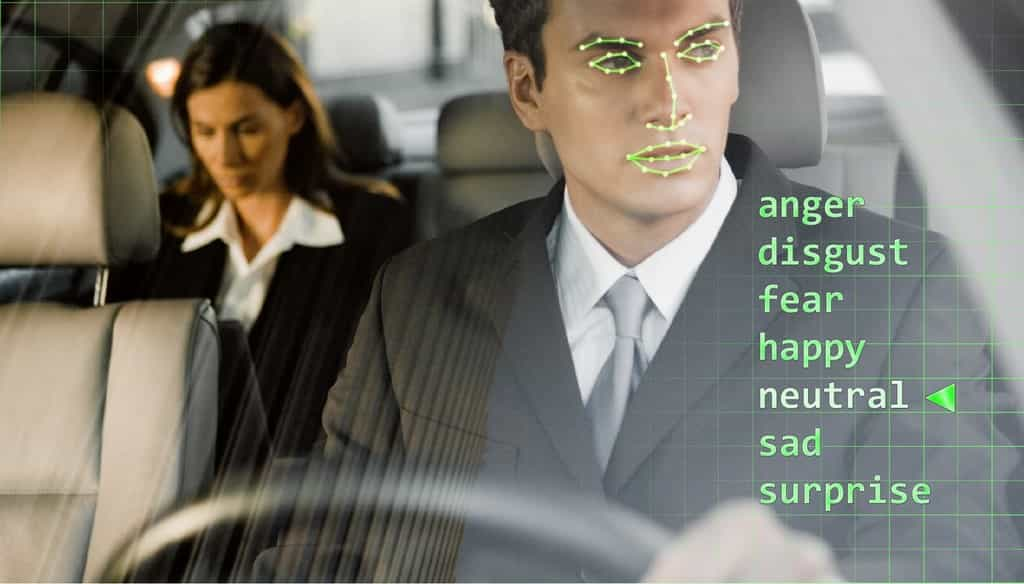

La technologie a été développée par l'École polytechnique fédérale de Lausanne (EPFL) sur la base d'un système de détection et d'analyse embarqué dans un véhicule. Une caméra infrarougeinfrarouge couplée à un éclairage LedLed installé derrière le volant filme le visage du conducteur. Les images sont analysées en temps réel par un algorithme classificateur qui extrait des points du visage afin de déterminer si l'expression correspond à un état de colère. Pour le moment, le système est capable de déterminer deux états : la colère et le dégoût, « dont les manifestations sont proches de la colère », expliquent les chercheurs de l'EPFL dans un communiqué.

Détection des expressions faciales liées à la colère

« PSAPSA Peugeot Citroën a installé il y a quelques années une cellule de recherche avancée sur le site de l'EPFL, avec comme mission de créer des liens et des projets avec les chercheurs », explique le professeur Jean-Philippe Thiran qui dirige le laboratoire de traitement des signaux 5 (LTS5) à l'EPFL. « Tout naturellement, lorsqu'il s'agit d'assistance à la conduite, l'image et la vidéo viennent dans la discussion. Et l'analyse de l'état émotionnel du conducteur est au centre des préoccupations des constructeurs dans ce domaine. Nos travaux en analyse d'expression faciale ont très vite trouvé un écho chez eux. »

Le système repose sur la création du classificateur à partir de modèles de référence. Des séries de photos de visages exprimant la colère et le dégoût sont assimilées par l'algorithme. La même méthode a été répétée avec des séquences vidéo. Lors de l'analyse des images, le système plaque un masque virtuel sur le visage qui contient des points de repère au niveau du contour des yeuxyeux, des sourcilssourcils, du neznez et des lèvres. « La position de ces points et l'apparence de la peau aux alentours sont extraites et entrées dans un système de classification, pour reconnaître l'expression manifestée à ce moment », précise le professeur Thiran.

Le système de détection des émotions mis au point par l’EPFL est actuellement capable de reconnaître les expressions du visage liées à la colère ou au dégoût, qui sont assez proches l’une de l’autre. Pour cela, le système définit des points de repère sur plusieurs zones du visage qui sont ensuite analysés par un algorithme. Sur cette image, le système décelé un état de colère (anger). © EPFL-LTS5, PSA

Créer une interface Homme-machine autodidacte

Jean-Philippe Thiran nous indique que le taux de reconnaissance en conditions réelles est actuellement de 85 %, ce qui représente une vraie performance en sachant combien une expression humaine peut être complexe. « Lorsque les tests ont échoué, c'est le plus souvent parce que l'expression de l’émotion est très variable en fonction des individus. C'est là que réside toujours la difficulté, étant donné la diversité des manifestations de la colère », reconnaissent les chercheurs de l'EPFL.

Le travail de développement va se poursuivre selon deux priorités. La première est de rendre le système d'analyse efficace lorsque le conducteur tourne la tête. La seconde sera d'établir un apprentissage plus spécifique avec un algorithme capable de s'adapter aux expressions de chaque conducteur afin de créer une « interface Homme-machine autodidacte ». Il faut également préciser que ce système a été couplé avec la détection de la fatigue en calculant le pourcentage de fermeture des paupières. Le LTS5 indique qu'il travaille également sur l'analyse d'autres expressions faciales qui pourraient traduire un état de distraction ainsi que sur la lecture labiale pour faire de la reconnaissance vocale.

Concrètement, dans quels cas de figure cette technologie pourrait-elle aider les automobilistes ? « Détecter des états émotionnels tels que la colère ou le stressstress pourrait permettre de déclencher des contremesures comme une musique apaisante ou un éclairage du tableau de bord moins intense, détaille Jean-Philippe Thiran. De la même façon, détecter de la fatigue pourrait déclencher la lecture d'une musique énergique ou un éclairage plus vif. » Il ajoute que « sur le long terme, dans un contexte de véhicules semi-autonomes, il sera de plus en plus primordial que la voiture ait connaissance de l'état émotionnel du conducteur afin de répartir correctement les tâches qui doivent être gérées automatiquement et celles qui peuvent être transférées à l'automobiliste. » Cette perspective, qui ne manquera pas de susciter des débats, est toutefois encore bien lointaine. Cependant, notre interlocuteur estime que d'un point de vue technique, des contremesures plus basiques pourraient être introduites dans des voitures de série d'ici un à deux ans.