au sommaire

Que se passe-t-il précisément dans notre cerveau lorsque nous regardons une image que nous reconnaissons immédiatement ? Un groupe de spécialistes en neurosciences de l'université de Washington, à Seattle (États-Unis), a réalisé un pas important dans la compréhension de ce processus neurologique. Grâce à des implantsimplants au niveau des lobes temporaux et à un algorithme, ils sont parvenus à décoder les signaux cérébraux associés à la vue d'une image. Ils ont alors pu entraîner leur logiciel afin qu'il identifie quasiment en temps réel ce que la personne voyait avec un taux de réussite de près de 96 %. Leurs travaux ont fait l'objet d'une publication dans la revue PLOS Computational Biology.

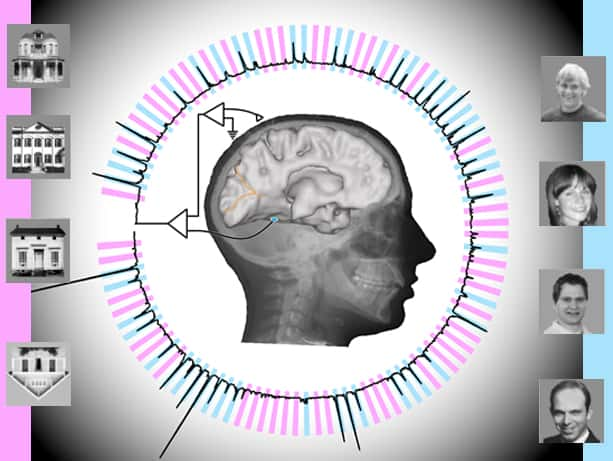

L'expérience a été menée avec sept personnes souffrant d'épilepsie auxquelles des électrodesélectrodes avaient été implantées au niveau des lobes temporaux afin de localiser les points de convulsionconvulsion. Les patients devant passer une semaine à porter ces implants, l'équipe de l'université de Washington a eu l'idée de profiter de cette occasion pour leur proposer de participer à une expérimentation. Leur tâche était simple : regarder des images défilant sur un écran d'ordinateur pendant que leur activité cérébrale était analysée. Il s'agissait de photos alternant des visages, des maisons et des fonds gris qui défilaient à 400 millisecondes d'intervalle. Afin de s'assurer de leur niveau de concentration, il était demandé aux participants de trouver la photo d'une maison à l'envers.

Cette infographie schématise les résultats obtenus par l’algorithme d’analyse des ondes cérébrales. En bleu, l’activité spécifique liée à la vision d’un visage ; en rose, celle associée à la vision d’une maison. © Kai Miller et Brian Donohue, university of Washington

Un décalage d’à peine 20 millisecondes

Pendant ce temps, l'algorithme avait pour mission d'extraire deux types de signaux cérébraux : le potentiel évoqué (qui désigne la modification du potentiel électrique du système nerveux en réponse à une stimulationstimulation externe) et les signaux persistant après qu'une image a été visualisée. Les ondes cérébrales étaient numérisées 1.000 fois par seconde, ce qui permettait au logiciel de déterminer quelles combinaisons d'électrodes et quels types de signaux répondaient lorsque les patients voyaient une image en particulier. Les chercheurs ont ainsi pu constater qu'ils obtenaient des réponses différentes depuis des zones différentes des lobes temporaux, certaines correspondant à la vue d'un visage, d'autres à celle d'une maison.

Ces données ont ensuite servi à entraîner l'algorithme. Puis les patients ont été confrontés à une nouvelle série d'images que le logiciel ne connaissait pas. Le programme a alors su dire avec une fiabilité de 96 % et un décalage d'à peine 20 millisecondes quand la personne voyait l'image d'une maison, celle d'un visage ou d'un fond gris.

Les chercheurs savaient déjà décoder les images qu'une personne voit. Cependant, comme l'a expliqué l'un des membres de l'équipe de l'université de Washington, les algorithmes utilisés avaient besoin de savoir à l'avance que l'on montrait des images au sujet observé. Dans le cas présent, le programme lit dans les ondes cérébrales en temps réel sans autre information préalable. Ce niveau de précision a pu être obtenu seulement lorsque les informations provenant des deux types de signaux cérébraux évoqués étaient croisées, ce qui tend à démontrer qu'ils sont complémentaires.

« Traditionnellement, les scientifiques se sont penchés de façon individuelle sur les neuronesneurones », souligne le professeur Rajesh Rao, le neuroscientifique qui a conduit cette étude en compagnie du neurochirurgien Jeff Ojemann et de leurs étudiants respectifs. Il y a quelques années, ce spécialiste des interfaces cerveaucerveau-machine a fait parler de lui en faisant bouger à distance le doigt de son collègue grâce au signal électrique de son cerveau. « Notre étude offre une vision plus globale, à l'échelle d'un grand réseau de neurones, de la manière dont une personne qui est éveillée et attentive perçoit un objet visuel complexe », poursuit-il.

Elargir la lecture à d'autres zones du cerveau

Si l'on peut effectivement parler d'une forme très simplifiée de lecture de la pensée, les chercheurs y voient d'abord une avancée dans la compréhension du fonctionnement du cerveau. Ils espèrent qu'à plus long terme, cet outil aidera à mieux appréhender certaines maladies affectant la mémoire et les fonctions motrices pour aider à une rééducation du cerveau mais ce n'est pas tout...

« D'un point de vue clinique, on peut voir notre résultat comme la preuve de concept vers la création d'un mécanisme de communication pour les patients paralysés ou qui ont subi un AVCAVC et sont complètement immobilisés », ajoute le professeur Rao. La prochaine étape va consister à travailler sur des représentations plus complexes afin d'élargir l'analyse de signal à d'autres zones du cerveau et d'aller jusqu'à savoir, par exemple, si une personne est en train de regarder quelqu'un qu'elle connaît, avec laquelle elle a un lien émotionnel, ou un étranger.

« Avec les enregistrements cérébraux adéquats, on pourrait apprendre des détails extrêmement fins à propos d'une personne. Par exemple : où elle va aller, quels objets elle voit lorsqu'elle regarde quelque part, ce qu'elle pense réellement », a déclaré au site Motherboard Gerwin Schalk, neuroscientifique et coauteur de cette étude. « Quand on y pense, ceci est vraiment très profond. » Peut-être trop profond ?