Une équipe d’ingénieurs du MIT a trouvé le moyen de matérialiser le processus de décision d’un robot autonome grâce à un système de réalité augmentée. Cet outil de visualisation est pensé pour aider les développeurs à trouver plus rapidement les bugs et défauts de conception dans les algorithmes de navigation.

au sommaire

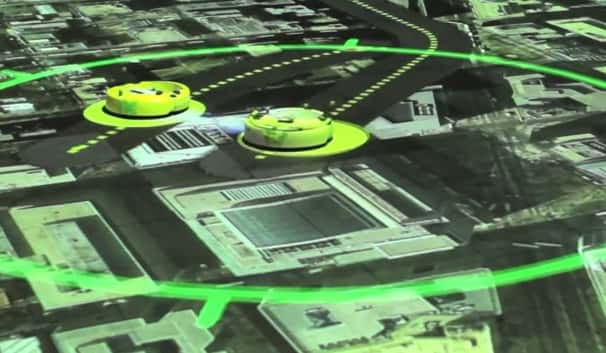

Par réalité augmentée, il est possible de visualiser le cheminement suivi par l'algorithme d'un robot autonome. Baptisée mesureable virtual reality, cette technique pourrait grandement faciliter le travail des développeurs de drones et autres véhicules autonomes en leur montrant les erreurs commises. © Massachusetts Institute of Technology

Certains veulent lire dans les « pensées » d'un robot autonome... Pourquoi ? Pour savoir si son algorithme de navigation fonctionne de manière optimale. Comment ? En observant de quelle manière il décide d'emprunter un chemin plutôt qu'un autre et répertorie les obstacles. C'est le cas d'Ali-akbar Agha-mohammadi et Shayegan Omidshafiei, deux ingénieurs du MIT (Massachusetts Institute of Technology). Ils ont créé ce qu'ils appellent un système de « réalité virtuelle mesurable » (measurable virtual reality ou MVR) qui visualise en temps réel la perception que le robot a de son environnement : de quelle manière il identifie les objets et les personnes en mouvementmouvement, comment il définit ses options de déplacement, etc.

« Normalement, un robot prend des décisions, mais on ne sait pas vraiment de quelle manière. Pourquoi choisit-il tel chemin plutôt que tel autre ? explique Ali-akbar Agha-mohammadi. Mais si vous pouvez visualiser le plan du robot projeté au sol, vous pouvez relier ce qu'il perçoit à ce qu'il fait et comprendre le sens de ses actions. » Ce système de réalité augmentée a pour objet de faciliter le développement et le prototypage des véhicules autonomes, qu'il s'agisse de drones ou d'autres engins roulant. Ainsi, la MVR fournit aux développeurs un moyen d'identifier rapidement les bugsbugs et les défauts dans leurs algorithmes.

Le dispositif de réalité virtuelle mesurable se compose de caméra à détection de mouvements et de capteurs placés sur les engins autonomes (drone ou véhicules, Interaction of physical and virtual agents). Les données sont traitées par un logiciel spécial qui les traduit sous forme visuelle (Display of augmented info (e.g.) pose and battery status)). Les images sont projetées en temps réel accompagnées d’un fond réaliste qui peut simuler tout type d’environnement (milieu urbain, forêt, route…). © Massachusetts Institute of Technology

Mettre en images le système de décision d’un robot

Le système se compose de 18 caméras à détection de mouvement disposées au plafond et qui peuvent suivre plusieurs robots simultanément. Les informations sont traitées par un logiciel spécialement développé qui crée un rendu visuel de ces données cachées telles que les itinéraires envisageables et la perception des obstacles. Les images, qui se présentent sous la forme de lignes pour les trajectoires et de points pour les obstacles, sont ensuite projetées au sol en temps réel grâce à un vidéo projecteurprojecteur. Le système peut aussi projeter un décor réaliste tel qu'un environnement urbain, un réseau routier, une forêt, etc. On peut découvrir le fonctionnement dans cette vidéo publiée sur YouTubeYouTube et intitulée Reading robots' minds. « Traditionnellement, les simulations et les systèmes physiquesphysiques sont disjoints. Il fallait plonger dans le plus bas niveau du code pour le décomposer et essayer de comprendre d'où venait le problème. Désormais, nous avons la capacité de matérialiser physiquement une information de bas niveau de telle sorte que vous n'avez pas besoin de creuser votre code ou de repenser le fonctionnement de votre algorithme », ajoute Shayegan Omidshafiei.

L'équipe du MIT a mené plusieurs tests en se servant de ce système de visualisation, notamment pour un concept de drone-livreur. Ils ont fait voler un drone quadricoptère au-dessus d'une ville virtuelle, projetée à la manière de ce que l'on voit dans GoogleGoogle Street View, afin de simuler une livraison et observer comment l'appareil se déplace. Un scénario similaire a été essayé pour un projet de drone-pompier qui survole une forêt virtuelle afin de détecter des départs d'incendie. Étant donné les limitations légales qui s'appliquent au vol de drones en extérieur, cet outil de simulation pourrait servir à développer et prototyper plus facilement de telles applicationsapplications en recréant n'importe quel type d'environnement. L'autre avantage est qu'il est possible d'éprouver les algorithmes en introduisant de la complexité dans les simulations, comme des nuagesnuages qui gênent la visibilité du drone ou des obstacles mobilesmobiles surgissant sur la trajectoire d'un robot.