au sommaire

« Deux pizzas posées au-dessus du four de la cuisinière ». Voilà le sous-titre généré automatiquement par le logiciel Google après avoir analysé cette image. Le système combine deux interfaces neuronales, l’une analysant la photo pour en produire une description mathématique ensuite transmise à la seconde qui la traduira sous forme de texte. © Google

« Une image peut valoir mille mots, mais parfois, les mots sont plus utiles. » C'est ce que pensent des chercheurs travaillant pour Google, qui ont créé un logiciel capable de décrire avec précision une image en langage naturel. Encore au stade expérimental, ce système obtient déjà des résultats prometteurs et laisse entrevoir plusieurs sortes d'applicationsapplications concrètes. Il pourrait notamment aider les personnes déficientes visuelles à comprendre une photo grâce à des sous-titres énoncés à voix haute. Il pourrait aussi servir dans certaines régions du globe où les connexions mobilesmobiles sont trop lentes pour afficher des images à l'écran en les remplaçant par du texte.

Enfin, cette technologie pourrait fonctionner dans le sens inverse et faciliter la recherche d'images en langage naturel via GoogleGoogle. Le système de Google combine deux interfaces neuronales qui, à l'origine, ont été développées séparément. L'une d'elles est un « réseau neuronal profondément convolutif » que le géant américain utilise déjà dans son service Street View pour reconnaître les numéros de rues. Ce système est conçu pour générer la représentation mathématique d'une image afin de pouvoir identifier des objets. Le second réseau neuronal a été développé pour faire de la traduction automatique.

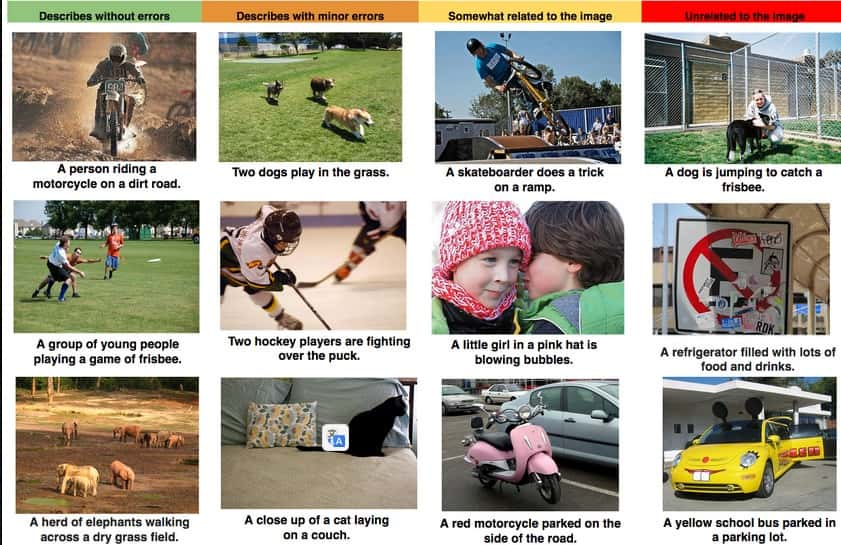

Quelques exemples des résultats obtenus par le logiciel de description d’images de Google lors de différents tests. Les colonnes de gauche à droite classent les descriptions en allant de la plus exacte au hors-sujet complet. © Google

Un niveau de précision déjà élevé

Une fois les deux réseaux associés, le premier va en quelque sorte détailler une image et transmettre une description mathématique de ce qu'il voit au second, qui s'en sert pour produire une phrase en langage naturel. Google a entraîné le système en le nourrissant de milliers d'images avec des descriptions rédigées par des humains. Puis la technique a été mise à l'épreuve avec plusieurs bases de données d'images dont Flickr, SBU et Pascal.

Dans l'article scientifique qui décrit ce projet (Show and Tell: A Neural Image Caption Generator), les ingénieurs Google livrent les résultats des différents tests qui atteignent, pour certains, le score de 59 % alors que ce taux est de 69 % pour les humains. Si les premiers chiffres témoignent déjà d'un haut niveau d'efficacité et de précision, la marge de progression du système est encore importante. Le perfectionnement de cette double interface neuronale dépend de la quantité et de la qualité de la matièrematière qu'on lui fournit pour apprendre. « À mesure que les bases de données adaptées à l'apprentissage des descriptions d'images vont croître et mûrir, il en sera de même pour les performances de ce genre d'approche », conclut Google.