au sommaire

Microsoft Research a conçu ce prototype de stylet dont le corps est doté de capteurs qui détectent à la fois ses mouvements mais aussi la manière dont il est saisi. En intégrant le même type de capteurs dans une tablette, les chercheurs ont créé une interaction inédite où les terminaux savent s’adapter en temps réel en fonction du contexte d’utilisation. © Microsoft Research

On l'aurait presque oublié, mais le stylet était un outil très populaire il y a quelques années avec les PDA (personal digital assistantpersonal digital assistant), les ancêtres des smartphones. L'arrivée des écrans tactiles multipoints a presque instantanément relégué cet accessoire au rang de gadget un peu désuet. Pourtant, quelques constructeurs, et non des moindres, croient aux avantages du stylet. C'est le cas de SamsungSamsung qui l'a remis à l'honneur avec sa phablette Galaxy Note et son tout nouveau Galaxy Note Edge.

MicrosoftMicrosoft mise lui aussi sur le stylet comme compagnon pour sa tablette hybridehybride Surface Pro. Et le géant américain veut aller encore plus loin. Le département de R&D Microsoft Research (MSRMSR) vient de présenter un prototype de stylet et de tablette qui explorent des pistes d'interactions inédites en détectant à la fois la préhension et les mouvementsmouvements.

Ce projet est mené en collaboration avec les universités nord-américaines de Cornell et du Manitoba. « Les doigts et les mains ont cette dextérité absolue, à la fois individuellement, comme lorsque l'on pince pour zoomer sur un écran tactile, mais aussi grâce à des outils que l'on tient en main. Et lorsque l'on considère le stylet, il s'agit juste d'un autre outil long et mince avec lequel on peut faire des choses incroyables », estime Bill Buxton, l'un des directeurs du département MSR.

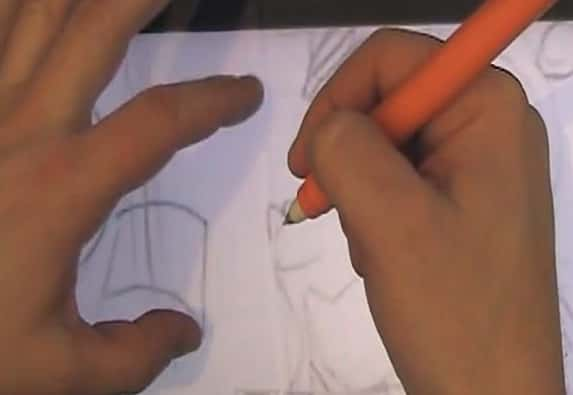

Sur cette capture issue de la vidéo de démonstration produite par Microsoft, on voit que la main droite peut reposer en position d’écriture sur l’écran tactile sans que celui-ci réagisse tandis que la main gauche peut zoomer sur une portion. Ce scénario illustre les nombreuses possibilités d’interaction entre un stylet et un écran tactile qu’offre ce nouveau concept. © Microsoft Research

Des terminaux qui s’adaptent en fonction du contexte

Microsoft Research explique s'être penché avec attention sur les « détails visibles, mais inaperçus » du comportement de la main et des doigts lorsque l'on tient un stylo pour écrire, effacer un mot ainsi que l'interaction entre la main dominante et non dominante. Pour étudier ces données, les chercheurs ont équipé une tablette tactile et un stylet de capteurscapteurs inertiels. Une fois associés, ces deux terminaux peuvent détecter neuf degrés de liberté et notamment la position de chaque appareil et son orientation. Le corps du stylet est lui-même doté d'un capteur qui enregistre la manière dont l'usager le saisit et lui permet de lancer ou d'interrompre une tâche d'un simple tapotement du doigt. Idem pour toute la surface de la tablette qui perçoit la manière dont elle est prise en main.

L'idée est de partir de ces informations pour inventer de nouvelles fonctionnalités qui optimisent le couple stylet-tablette, en proposant des fonctions contextuelles dérivées de la façon dont l'utilisateur tient et manipule les terminaux. Par exemple, le système peut savoir si la personne saisit la tablette de la main gauche ou droite et adapter l'interface des applicationsapplications en conséquence pour la rendre plus ergonomique. Il est également possible de tenir le stylet en position d'écriture tout en reposant la main sur l'écran tactile sans que celui-ci réagisse tout en se servant de son autre main pour zoomer à l'aide de l'index et du pouce. Une configuration qui pourrait s'avérer très appréciable pour les dessinateurs et autres designers qui travaillent sur des tablettes.

Dans une vidéo de démonstration publiée sur YouTube, MSR dévoile d'autres possibilités d'interactions pertinentes. On y découvre comment il est possible d'utiliser une main pour déplacer la zone cible d'un aérographe virtuel, tandis que la main tenant le stylet s'incline pour modifier l'angle de la pulvérisation. Si Microsoft ne s'avance pas quant à l'introduction de cette technologie dans ses futurs produits, il apporte la preuve que l'interaction entre un stylet et un écran tactile recèle un potentiel qui n'a été qu'effleuré jusqu'ici.